简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

vllm 部署多卡遇到的问题:/tmp/tmp2ynwcnmz/main.c:5:10: fatal error: Python.h: 没有那个文件或目录。sudo apt-get install python-dev# 对于 Python 2.x。sudo apt-get install python3-dev# 对于 Python 3。

1.强化学习-reward训练2.reward 模型重新加载与训练。

微调代码:参数定义—>数据处理---->模型创建/评估方式---->trainer 框架训练。,所以中需要进行文件配置,即可实现deepspeed的训练。注意: V100 显卡,不包括float16 精度训练。二、代码讲解,peft微调+trainer 实现。配置文件:ds_config.json。1、代码讲解,trainer 实现。transformers通。

1.使用unsloth 进行强化学习训练grpo2.训练后加载推理3. 训练后模型+lora 合并。

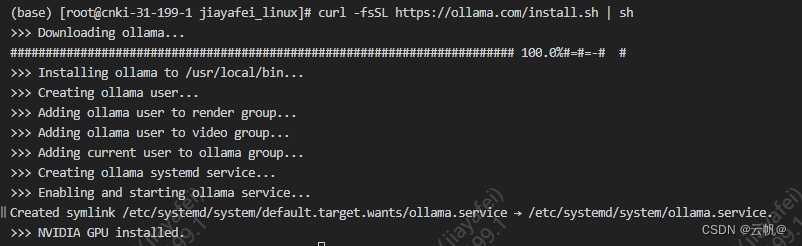

ollama 定义环境部署demo加载本地模型方法基本指令关闭开启ollamaollama 如何同时 运行多个模型, 多进程ollama 如何分配gpu修改模型的存储路径。

1.架构是什么2.如何初始化的3.tie_word_embeddings 了解4.语言模型类型有哪些?5.qwen、qwen1.5、qwen2、qwen2.5 不同之处6. 分词器粒度的优缺点?7. 数据有什么特点?

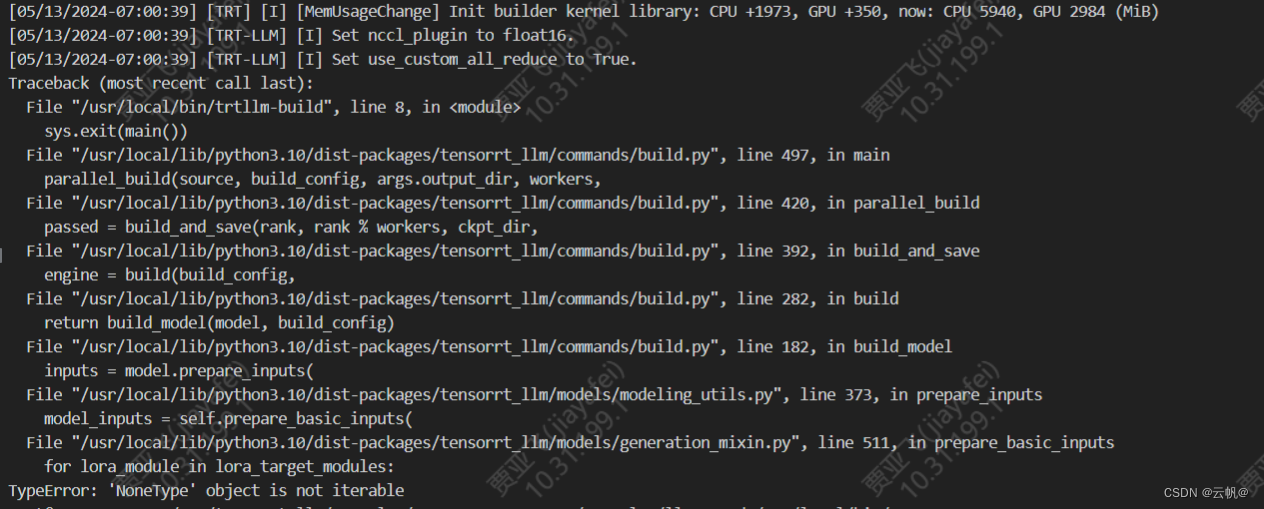

3.int8-kv-cache量化:KV Cache 量化是指将逐 Token(Decoding)生成过程中的上下文 K 和 V 中间结果进行 INT8 量化(计算时再反量化),以降低生成过程中的显存占用。最先进的量化方法,如SmoothQuant和AWQ,在量化造成的性能损失适中时,可以有效提升性能。1. 模型量化参考:https://github.com/NVIDIA/TensorRT-LLM

【代码】/onnxruntime_src/onnxruntime/core/session/provider_bridge_ort.cc:1193 onnxruntime::Provider& onnxrun。

解决:先说解决办法:将1.16.2版本的onnx降级为1.16.1。

安装: conda install cudatoolkit。