简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

本文介绍了8个提升AI代理开发效率的Python库:1)LiteLLM统一多模型调用接口;2)Instructor确保结构化输出;3)Tenacity处理API失败重试;4)Logfire提供详细调试日志;5)Diskcache实现轻量级缓存;6)Tiktoken精确计算令牌;7)Rich美化控制台输出;8)Watchfiles实现热重载。这些专一功能的小型库组合比复杂框架更灵活可靠,作者通过实际

个人AI代理构建指南 本文分享了作者使用AI技术栈快速构建个人AI代理的经验。通过Google AntiGravity、Gemini Pro和Claude模型等工具,作者能够在几小时内开发实用原型,包括个人助手Fernão。Fernão具备日程安排、写作辅助、投资建议等功能,整合了日历、待办事项和Notion数据。文章重点介绍了日程安排功能的技术实现,包括从Google日历获取事件的Python代

AI代理的局限性:装饰而非实质 当前AI社区热衷于构建代理系统(RAG流水线、工具链等),但这些系统本质上是现有AI能力的包装器,而非真正的智能突破。从数学和经济角度看,代理系统存在根本缺陷: 脆弱性:代理的价值会随着基础模型的能力提升(如上下文扩展、记忆增强)而迅速贬值 信息局限:代理只是重新分配现有信息,而非创造新认知 专业限制:对专家而言,预设流程反而会限制创造性思维 经济缺陷:易于复制的代

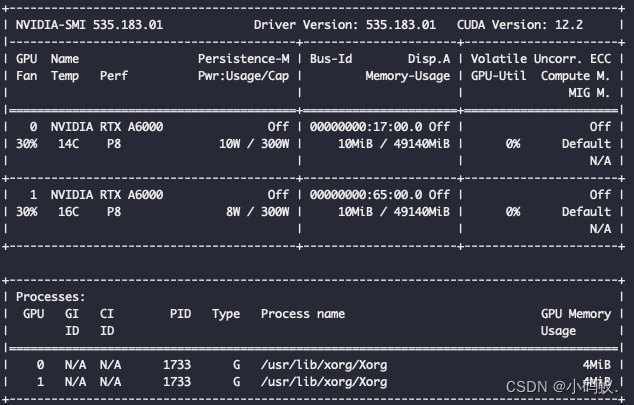

modprobe -r nvidia-drm# unload 显卡驱动。$ sudo sh ./NVIDIA-Linux-x86_64-390.48.run# 执行升级脚本。应该是你的桌面显示器在使用显卡驱动关闭即可。就可以升级显卡驱动和CUDA啦。

A: 随着AI技术的发展,提示词工程将变得更加专业化和系统化。未来可能会出现更多专门的工具和框架来辅助提示词设计,同时也会有更多针对特定领域的提示词最佳实践出现。A: 大部分技巧适用于基于大语言模型的AI助手,如ChatGPT、Claude、Bard等。本文件提供了ChatGPT提示词编写系列教程的详细内容概述,帮助你了解每个教程的核心内容、学习目标和适用场景。提示词的质量比长度更重要。清晰、具体

摘要: 本文系统解析Transformer架构的核心机制及其在小型语言模型中的应用。首先阐明语言模型的本质是上下文预测工具,通过对比传统RNN与Transformer的注意力机制,揭示后者如何通过自注意力实现高效上下文关联。重点剖析多头注意力、分组查询注意力(GQA)等优化技术如何平衡性能与效率,使小型模型(如Phi-3、Llama-3)在特定任务上媲美大模型。最后提出关键决策框架:需权衡专业场景

**,专注于人工智领域与AI工具、前沿技术解读。***距离一个重要的产品截止日期还有大约两周时,我的智能体原型出现了最严重的故障。它表面上看起来没什么问题:能获取数据、调用工具,甚至还能解释自身的操作步骤。但实际上,它只是在“装样子”——没有真实的状态、没有记忆功能、也没有推理能力,仅仅是通过循环提示来伪装成智能的样子。直到一个边缘案例让它彻底失控,我才意识到问题所在:我根本没有构建出真正的智能体

本文介绍了构建企业级AI智能体系统的核心架构设计。系统采用分层架构,包含智能体编排、内存管理、安全控制等模块,确保高可靠性和可观测性。文章详细讲解了模块化代码库的组织结构,包括API路由、核心逻辑、评估框架等目录划分,并展示了基于pyproject.toml的依赖管理策略,涵盖Web框架、AI工具链、监控系统等关键组件。该架构支持大规模多智能体协作,兼顾性能与安全性要求,适用于生产环境部署。

例如,如果你的完整需求说明书有一个关于“安全要求”的部分,长达500字,你可以让智能体将其总结为:“安全:使用HTTPS,保护API密钥,实现输入验证(参见完整需求说明书§4.2)”。许多使用多智能体设置的开发者甚至为每个部分创建单独的智能体或子进程——例如,一个智能体处理数据库/模式,另一个处理API逻辑,另一个处理前端——每个都有相关的需求说明书片段。如果你的公司标准化了某些技术,就在这里说明

积极的一面是,团队报告在某些情况下捕获了95%以上的错误——空指针异常、缺失的测试覆盖率、反模式。消极的一面是,一些开发者认为AI审查评论是“文本噪音”——没有增加任何价值的通用观察。尽管快速推进,但看到丑陋的代码时要修复它,而不是让混乱累积。在AI时代,最好的代码审查者将拥抱这一转变——让AI加速机械性工作,同时坚守问责制。代码不一定糟糕,但没有人有精力审查如此巨大的变更,而且审查AI生成的代码