简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

AI时代普通人增收的7大路径 当前AI技术已从娱乐工具转变为提升收入的强力杠杆。普通人无需背景或大量资金,通过以下7种方式可实现日入千元目标: AI内容代写:垂直领域+AI流水线写作,日入300-1500元 AI短视频制作:全流程自动化产出,日入500-2000元 AI代部署服务:基础技术调试安装,日入500-1500元 AI客服外包:为企业提供自动化解决方案,日入800-2000元 AI设计接单

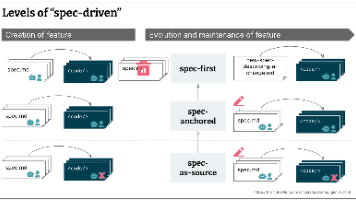

规范驱动开发(SDD)正成为AI原生开发的主流模式,但Martin Fowler团队警告其可能陷入"越改越坏"的陷阱。通过实践发现12个反直觉真相: 规范设计:200行规范比2000行更有效;可执行命令优于描述性文字;约束比指令更重要;高层模糊指令有时优于精确指令。 工作流程:测试比规范更重要;Vibe Coding不应被完全抛弃;审查规范比代码更累;AI第一版代码通常最佳。

摘要:本文探讨如何在阿里云灵码中集成Claude Skills机制,提升代码审核效率。Claude Skills通过动态加载领域专业知识,实现AI从通用助手到领域专家的无缝切换。文章首先解析Skill机制的核心原理,包括文件结构(SKILL.md为核心提示模板)和调用流程(基于纯LLM推理的匹配)。随后提出在灵码中的实现方案:使用开源工具openskills安装Skill库,通过同步生成agent

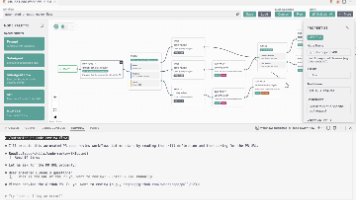

《Claude Code Workflow Studio:无代码AI工作流可视化工具》 摘要:Claude Code Workflow Studio是一款基于VS Code的开源插件,通过拖拽式操作实现AI工作流的无代码搭建。其核心优势包括:1)可视化界面支持Prompt模板、Sub-Agent等丰富节点,覆盖多数AI自动化场景;2)一键导出为Claude CLI可执行文件,无需额外配置;3)独创

摘要: 针对大模型驱动策略下A/B实验评估的低效问题,本文提出一套六层优先级Prompt决策系统,通过自动化推理解决人工巡检失效、打包实验收益恶化等痛点。系统将判断逻辑按风险等级分层(P0-P5),实现精准下线决策,上线后策略下线准确率提升至68%,人工耗时从6小时压缩至30分钟。文章详细拆解了生产级Prompt设计原则、分层决策逻辑及优化方法论,为A/B实验自动化提供可落地的解决方案。

OpenClaw和它的34个实战场景,给整个AI行业带来了一个重要启示,AI的价值从来不是陪人聊天,而是替代人类完成重复、繁琐、标准化的工作。过去我们把AI当成“嘴替”,帮我们写文案、说话、表达,而现在,我们可以把AI变成“数字牛马”,帮我们处理邮件、运维服务器、生产内容、管理项目、收集信息。awesome-openclaw-usecases之所以被称为用例圣经,就是因为它把高大上的AI Agen

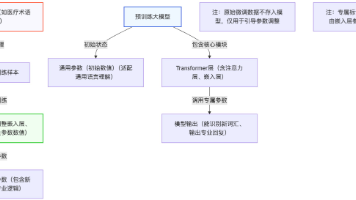

本文系统解析了大模型微调的核心逻辑与常见误区。微调并非将数据直接存入模型,而是通过调整模型参数(如Transformer层、注意力层等)来适配特定场景。预训练模型虽不具备专业词汇(如医学术语),但能通过微调学习新词汇的关联逻辑。微调的本质是利用模型原有语言理解能力,通过参数数值调整建立"词汇-含义-逻辑"的映射关系,而非记忆原始数据。整个过程如同修改字典模板的排版逻辑,而非直接

阿里开源桌面AI助手CoPaw:本地优先的智能Agent新选择 2月28日,阿里开源的全新桌面Agent工具CoPaw引发行业关注。这款基于Python开发的工具采用本地优先策略,支持钉钉、飞书等多渠道接入,允许用户自由接入本地模型和开发插件。相比同类产品,CoPaw具有三大差异化优势:极简部署(3条命令即可完成)、Markdown驱动的零代码扩展能力,以及完整的本地运行路径保障数据隐私。其采用统

AI编程的狂欢与反思:从Vibe Coding到规范驱动开发 随着AI编程工具的普及,Vibe Coding凭借其快速生成代码的能力风靡一时。然而数据显示,90%-95%的AI编码项目无法进入生产环境,主要原因是缺乏可维护性和扩展性。规范驱动开发(SDD)应运而生,通过预先定义详细规范,引导AI生成更健壮的代码。目前主流SDD框架包括GitHub Spec Kit、OpenSpec、Superpo

摘要:本文探讨了当前AI Agent开发中TypeScript工具链的兴起及其潜在隐患,提出了一种将LLM作为Runtime而非Library的三层架构新范式。文章指出,TS主导的AI工具链虽在开发效率上优势显著,但存在性能瓶颈和协议污染等深层问题。作者建议采用后端服务层、LLM Runtime层和Skill描述层的分离架构,让模型自主决策而非依赖框架硬编码。这种"没有框架"的