简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

PandasAI 是一个 Python 库,它让您可以轻松地使用自然语言向数据提问。除了查询功能外,PandasAI 还提供了通过图表可视化数据、通过处理缺失值来清理数据集以及通过特征生成来提高数据质量的功能,使其成为数据科学家和分析师的综合工具

PandaAI 是一个开源框架,将智能数据处理和自然语言分析相结合。无论您是处理复杂的数据集,还是刚刚开始数据之旅,PandaAI 都提供了定义、处理和高效分析数据的工具。通过其强大的数据准备层和直观的自然语言界面,您可以在不编写复杂代码的情况下将原始数据转化为可操作的见解。对于之前版本的用户来说,PandaAI 3.0 (目前处于测试阶段)标志着一个重要的发展,它不仅超越了对话分析,还引入了一个

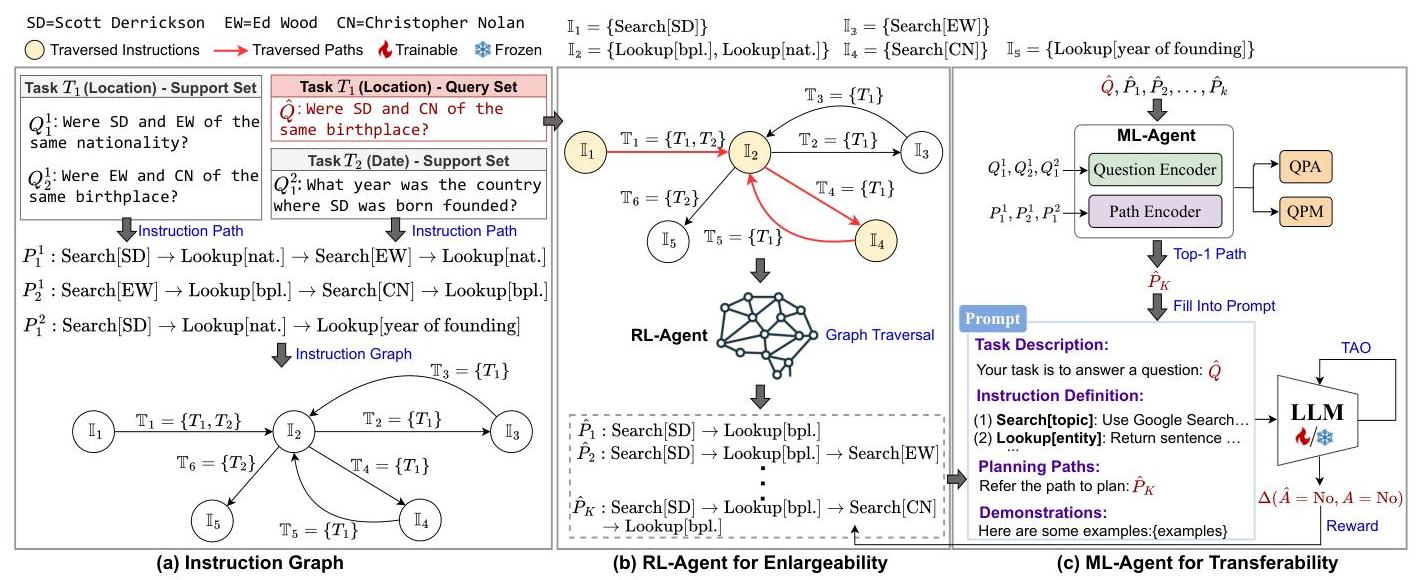

大型语言模型(LLMs)的最新进展使其能够作为智能体用于复杂任务的规划。现有方法通常依赖于思考-行动-观察(TAO)过程来增强LLMs的表现,但这些方法往往受到LLMs对复杂任务有限知识的限制。检索增强生成(RAG)通过利用外部数据库为生成提供依据,提供了新的机会。本文中,我们确定了将RAG应用于任务规划中的两个关键挑战(可扩展性和迁移性)。我们提出了InstructRAG,这是一种在多智能体元强

● AI代理是能够进行高级决策和任务执行的自主实体。● 代理式 AI 系统结合大型语言模型(LLMs)、工具和提示来管理复杂任务。● AI 代理框架通过预构建的组件和工具简化开发流程。● 核心组件包括代理架构、环境接口、任务管理、通信协议和学习机制。● 这些框架加速了开发进程,促进了标准化,并增强了 AI 的可扩展性和可访问性。●顶级框架包括 Langchain、LangGraph、Crew AI

由视觉-语言模型(VLMs)驱动的自主代理AI系统正迅速向实际部署迈进,然而其跨模态推理能力引入了新的对抗性操作攻击面,这些攻击利用跨模态的语义推理。现有的对抗攻击通常依赖于可见像素扰动或需要对模型或环境的特权访问,这使得它们在隐秘、现实世界的利用中不切实际。我们提出了TRAP,一种生成性的对抗框架,通过基于扩散的语义注入操纵代理的决策制定。我们的方法结合了基于负面提示的降级与正面语义优化,由双胞

GPT几乎成为了大型语言模型(LLMs)的代名词,这一术语在AIED会议记录中越来越流行。简单的关键词搜索显示,在AIED 2024展示的76篇长篇和短篇论文中,有61%描述了利用LLMs解决教育领域长期挑战的新颖解决方案,其中43%明确提到了GPT。尽管由GPT开创的LLMs为增强AI对教育的影响提供了令人兴奋的机会,我们认为,领域内对GPT和其他资源密集型LLMs(参数超过10亿)的过度关注可

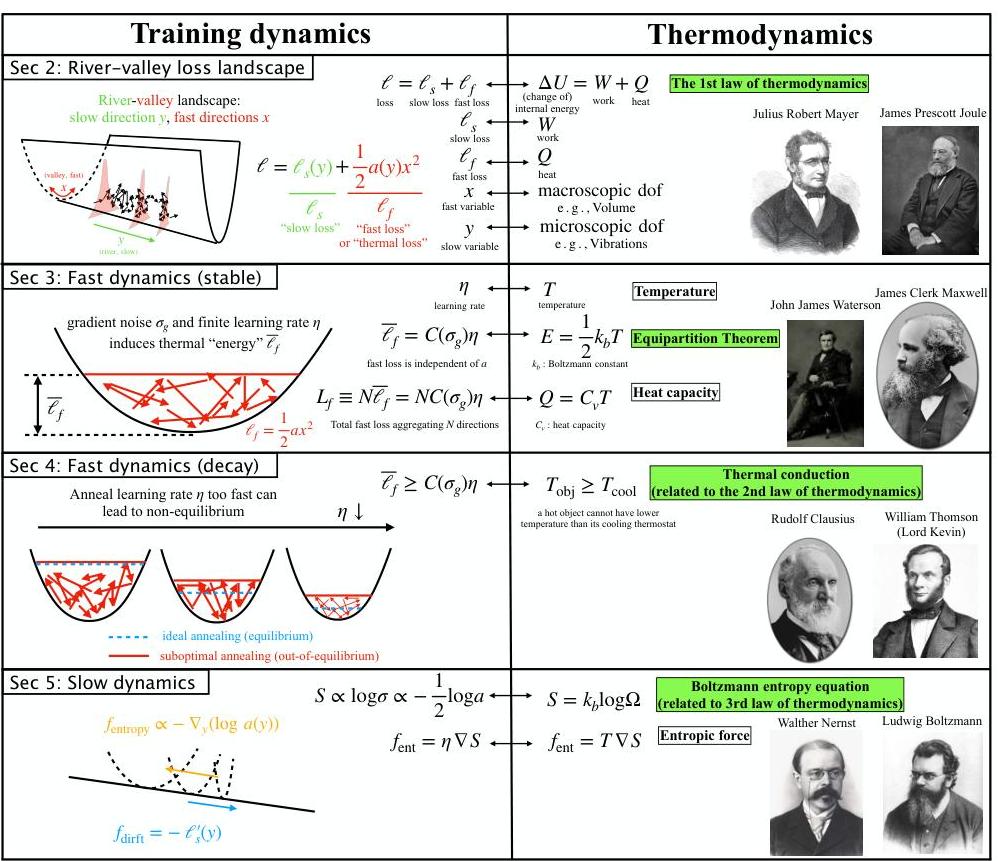

本文提出了神经热力学定律(NTL),通过热力学视角分析大规模语言模型(LLM)的训练动态。研究发现,LLM的损失景观具有“河谷”结构,快速动态在谷内平衡,慢速动态沿河演变。通过引入河谷景观的玩具模型,研究展示了热力学量(如温度、熵)和经典热力学原理如何自然地从LLM训练中涌现。这一理论框架不仅为理解LLM训练提供了新视角,还为学习率调度设计提供了直观指导,特别是升温-稳定-衰减(WSD)调度。研究

本文提出FinDebate多智能体框架,结合领域专用RAG技术与安全辩论协议,用于生成高质量财务分析报告。系统包含收益、市场、情感、估值和风险五个专业智能体,通过并行分析和协同辩论机制,在保持观点一致性的同时提升内容覆盖度与可验证性。实验表明,该方法在文本质量和财务专业性上均优于传统方案,能生成具备校准置信度、多时间维度的可执行投资建议。该框架为复杂财务分析任务提供了可靠解决方案,未来可扩展至更广

近年来,大型语言模型(LLMs)取得了显著进展,吸引了研究界的广泛关注。其能力主要归功于大规模架构,这需要在海量数据集上进行广泛训练。然而,这些数据集通常包含从公共互联网获取的敏感或受版权保护的内容,引发了对数据隐私和所有权的关注。监管框架,如《通用数据保护条例》(GDPR),赋予个人要求删除此类敏感信息的权利。这促使了机器遗忘算法的发展,旨在无需昂贵的重新训练即可从模型中移除特定知识。尽管有这些

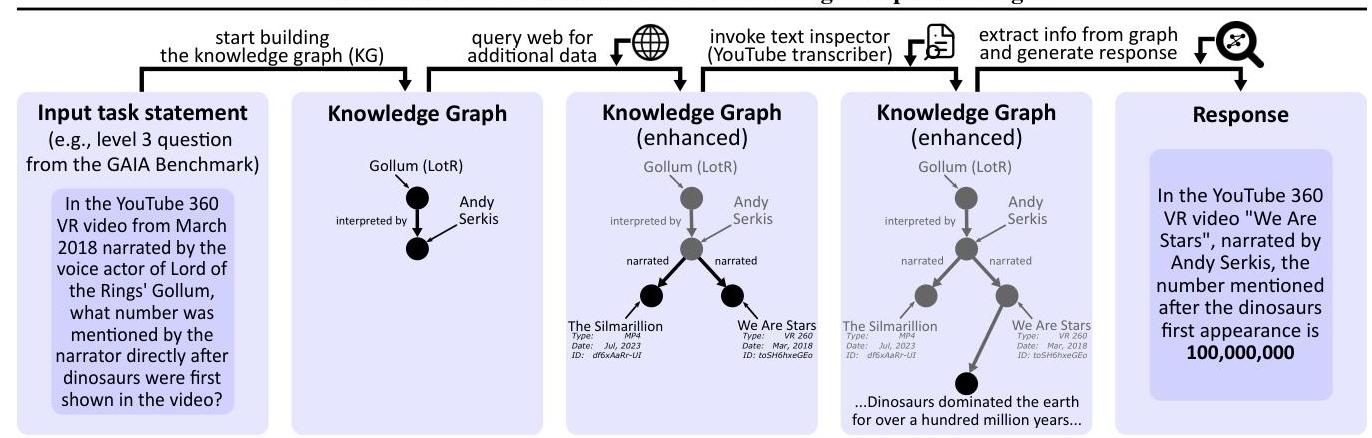

摘要大型语言模型(LLMs)正在革新能够跨领域执行多样化任务的AI助手开发。然而,当前最先进的LLM驱动型代理面临着重大挑战,包括高昂的运营成本和在复杂基准测试如GAIA上的成功率有限。为了解决这些问题,我们提出了思维知识图(KGoT),一种创新的AI助手架构,将LLM推理与动态构建的知识图谱(KGs)集成在一起。KGoT将任务相关知识提取并结构化为动态KG表示,并通过数学求解器、网络爬虫和Pyt