简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

前言RoBERTa没霸榜几天,这不Google爸爸就又放大招,这次的新模型不再是简单的的升级,而是采用了全新的参数共享机制,反观其他升级版BERT模型,基本都是添加了更多的预训练任务,增大数据量等轻微的改动。这次ALBERT的改进,不仅提升了模型的整体效果再一次拿下来各项榜单的榜首,而且参数量相比BERT来说少了很多。对于预训练模型来说,提升模型的大小是能对下游任务的效果有一定提升,然而如果进..

Spectral Graph Theory首先我们定义一下几个符号图 G=(V,E),N=∣V∣G=(V,E),N=|V|G=(V,E),N=∣V∣邻接矩阵 A∈RN×NA \in R^{N×N}A∈RN×N度矩阵D∈RN×ND \in R^{N×N}D∈RN×N节点的信号 f:V→RNf:V \to R^Nf:V→RN 其中fif_ifi表示的是iii节点的信号拉普拉斯矩阵 L=D−AL=D-

keras最优雅的地方还是在于其fit函数,自动验证,灵活的callback,batch_size、epochs的简单设置,相比于tensorflow需要自己编写验证代码,自己编写循环模块来实现多个epoch的训练,可谓是简单了太多。那么fit函数到底做了些什么呢,本文将会带领大家一起探讨其中的原理。代码分析首先,fit函数会对batch_size进行一个验证,这里调用了另外一个函数batc...

转载请注明出处,原文地址简介Attention Is All You Need是一篇Google提出的将Attention思想发挥到极致的论文。这篇论文中提出一个全新的模型,叫 Transformer,抛弃了以往深度学习任务里面使用到的 CNN 和 RNN ,目前大热的Bert就是基于Transformer构建的,这个模型广泛应用于NLP领域,例如机器翻译,问答系统,文本摘要和语音识别等等方向..

1、从一副52张扑克牌中随机抽两张,颜色相等的概率2C262C522\frac{2 C_{26}^2}{C_{52}^2}C5222C2622、54张牌,分成6份,每份9张牌,大小王在一起的概率C61C527C549\frac{C_{6}^1C_{52}^7}{C_{54}^9}C549C61C5273、52张牌去掉大小王,分成26*2两堆,从其中一堆取4张牌为4个a的概率2C482

前言说到PCA你是不是第一时间想到的是对协方差矩阵做特征值分解,但是为什么这么做呢?之前看过的大部分PCA博文也都是只简单介绍了PCA的流程,对其中的推导过程与原理并没有详细介绍,这篇文章的目的是从数学的角度,手推PCA每一个步骤,帮助读者了解PCA的工作机制是什么。文中的某些数学公式,可能会对某些读者产生不适,我会尽可能的用白话把其中原理讲解的通俗易懂。PCA简介PCA(Prin......

在图谱当中,有一项很重要的任务,节点分类。该任务通常是给定图中某些节点对应的类别,从而预测出生于没有标签的节点属于哪一个类别,该任务也被称为半监督节点分类。本文主要要解决的问题就是如何做节点分类。图中的相互关系在图谱中,存在着两种重要的相互关系homophily亲和性(我自己的翻译成,不一定准确),具体意思就是指人以群分物以类聚,例如在社交网络中,喜欢蔡徐坤的人通常都会有同样的喜好。influen

简介最近Google推出了NLP大杀器BERT,BERT(Transformer双向编码器表示)是Google AI语言研究人员最近发表的一篇论文。它通过在各种NLP任务中呈现最先进的结果,包括问答系统、自然语言推理等,引起了机器学习社区的轰动。本文不会去讲解BERT的原理,如果您还不清楚什么是BERT建议先参阅Google的论文或者其他博文,本文主要目的在于教会大家怎么使用BERT的预训练模..

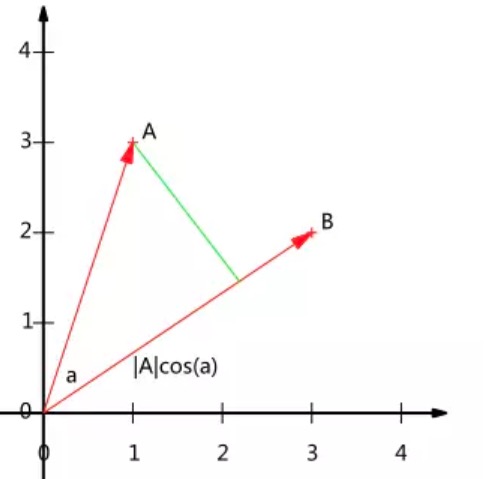

转载请注明出处,原文地址简介相信做NLP的同学对这个机制不会很陌生,它在Attention is all you need可以说是大放异彩,在machine translation任务中,帮助深度模型在性能上有了很大的提升,输出了当时最好的state-of-art model。当然该模型除了attention机制外,还用了很多有用的trick,以帮助提升模型性能。但是不能否认的时,这个模型的核..

转载请注明出处,原文地址简介Attention Is All You Need是一篇Google提出的将Attention思想发挥到极致的论文。这篇论文中提出一个全新的模型,叫 Transformer,抛弃了以往深度学习任务里面使用到的 CNN 和 RNN ,目前大热的Bert就是基于Transformer构建的,这个模型广泛应用于NLP领域,例如机器翻译,问答系统,文本摘要和语音识别等等方向..