简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

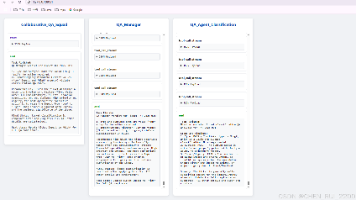

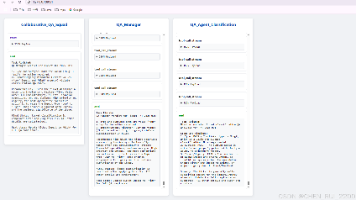

《AI代理协作系统:客户支持票据的智能QA解决方案》 本文提出了一种基于多代理协作系统的客户支持票据质量保障方案。针对传统手动QA效率低、错误率高(15%错误率)的问题,该系统利用Azure OpenAI和Agenticle框架构建了一个智能QA网络: 核心技术: 采用多代理并行处理架构,不同代理专注特定规则域(分类、时间、账单等) 动态代理生成机制,根据规则域自动创建专业代理 冲突解决机制,通过

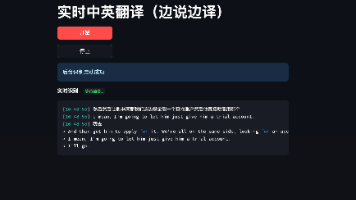

本文介绍了一个本地化部署的中文实时转英语口语工具的开发过程。该工具采用模块化设计,包含语音识别(Azure Speech SDK)、机器翻译(Hugging Face MarianMT本地模型)和语音合成(Azure TTS)三个核心模块,通过多线程并行处理实现低延迟(<2秒)。系统运用Python的queue.Queue实现线程间通信,采用Streamlit构建简易UI,并针对实时性需求设

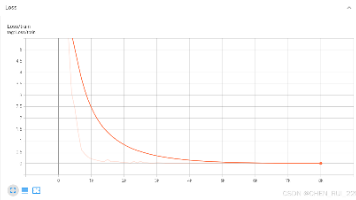

在qwen3-8B模型微调过程中出现vLLM报错,提示"base_model.model.model.embed_tokens.weight is unsupported LoRA weight"。原因是训练时先注入LoRA后调整embedding层大小,导致LoRA权重包含不支持的embedding层。解决方法包括:1)检查并过滤safetensors文件中含"lm

deepseek 被誉为榨干中低端英伟达显卡的利器, 论文地址论文提出了DeepGEMM,这是一种在CPU架构上加速超低精度推理的新方法,使用查找表。关键思想是预先计算所有可能的权重和激活的乘积,将它们存储在查找表中,并在推理时高效地访问它们,以避免昂贵的乘法累加操作。试验证明在x86平台上的性能优于QNNPACK框架中相应的8位整数内核,最高可达1.74倍。本文深入探讨了DeepGEMM算法,包

是一种注意力机制优化技术,最初在论文《》(2022)中提出。它通过在 Transformer 的注意力机制中引入线性偏置,取代传统的基于绝对位置嵌入(Positional Embedding)的编码方式,从而提高模型对长序列的泛化能力。使用线性形式的偏置,使得不同位置之间的关系可以通过简单的线性函数建模。这种方式不仅简化了位置编码的复杂性,还提高了模型的灵活性。也因为 ALiBi 不需要显式地计算

因为本人gpu卡的机器系统是centos 7, 直接使用ollama会报所以ollama使用镜像方式进行部署, 拉取镜像ollama/ollama启动命令查看ollama 是否启动成功,Ollama 没有用户界面,在后台运行。打开浏览器,输入 “http://xx:11434/”,显示 “Ollama is running”。deepseek-r1 目前有7b, 32b, 70b, 671b 多个

最近长沙跑了半个多月,跟甲方客户对了下项目指标,许久没更新回来后继续研究如何实现 grafana实现HAMi vgpu虚拟化监控,毕竟合同里写了需要体现gpu资源限制和算力共享以及体现算力卡资源共享监控先说下为啥要用HAMi吧, 一个重要原因是公司有人引见了这个工具的作者, 很多问题我都可以直接向作者提问。

因为本人gpu卡的机器系统是centos 7, 直接使用ollama会报所以ollama使用镜像方式进行部署, 拉取镜像ollama/ollama启动命令查看ollama 是否启动成功,Ollama 没有用户界面,在后台运行。打开浏览器,输入 “http://xx:11434/”,显示 “Ollama is running”。deepseek-r1 目前有7b, 32b, 70b, 671b 多个

《AI代理协作系统:客户支持票据的智能QA解决方案》 本文提出了一种基于多代理协作系统的客户支持票据质量保障方案。针对传统手动QA效率低、错误率高(15%错误率)的问题,该系统利用Azure OpenAI和Agenticle框架构建了一个智能QA网络: 核心技术: 采用多代理并行处理架构,不同代理专注特定规则域(分类、时间、账单等) 动态代理生成机制,根据规则域自动创建专业代理 冲突解决机制,通过

在qwen3-8B模型微调过程中出现vLLM报错,提示"base_model.model.model.embed_tokens.weight is unsupported LoRA weight"。原因是训练时先注入LoRA后调整embedding层大小,导致LoRA权重包含不支持的embedding层。解决方法包括:1)检查并过滤safetensors文件中含"lm