简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

转置卷积是实现上采样的重要方法,可调节 kernel、padding、stride。可以通过稀疏矩阵建模,作为标准卷积的“反操作”。适用于图像生成、语义分割、autoencoder 解码等任务中。字节、百度、腾讯等厂商普遍将转置卷积用于分割模型 decoder 部分,或用于可微上采样;NVIDIA GAN 系列将其作为高质量生成网络核心模块;DeepSeek 等 AI+金融企业在构建视觉 AI 模

DenseNet的主要特点:每一层都和之前所有层相连(通过拼接)特征重用率高,参数量较少特征传递和梯度传播都更容易缺点是内存占用较大(需要拼接所有历史特征)为了控制模型规模,DenseNet引入了过渡层,在每个密集块之间减少特征数量和尺寸。NVIDIAGoogleOpenAI等在大模型探索时,曾用DenseNet作为中间过渡结构。DenseNet思想也影响了后续很多模型设计,比如 Efficien

其实,在真实的企业开发中,接口设计过程其实是一个非常漫长的过程,可能需要多次开会讨论调整,甚至在开发的过程中才会发现某些接口定义还需要再调整,这种情况其实是非常常见的,但是由于项目时间原因,所以选择一次性导入所有的接口,在开发业务功能过程当中,也会带着大家一起来分析一下对应的接口是怎么确定下来的,为什么要这样定义,从而培养同学们的接口设计能力。作为一名软件开发工程师,我们需要了解在软件开发过程中的

本节深入探讨了BERT(Bidirectional Encoder Representations from Transformers)的核心思想与设计理念,从理论背景、模型架构、PyTorch实现到工程应用等多个角度进行全面解析。BERT通过双向编码器、掩码语言建模(MLM)和下一句预测(NSP)三大技术突破,实现了上下文相关的词表示,显著提升了多义词和语境依赖的处理能力。与传统词向量模型(如W

几乎所有头部厂商(Google、OpenAI、NVIDIA、字节)都对风格迁移方法进行了扩展或应用;风格迁移作为早期视觉生成的重要技术之一,在 AIGC、虚拟人、艺术创作、滤镜引擎等场景持续应用;目前已有部分公司(如 DeepSeek)将其与语言模型联动,实现「文生图 + 风格控制」融合方案。

作者:夏驰和徐策标签:GPT、Transformer、深度学习、自然语言处理、视觉讲解在人工智能领域,“GPT”已经成为一个家喻户晓的词汇。从GPT-2到ChatGPT,再到最近发布的GPT-4o,每一代都在刷新人们对AI语言理解与生成能力的认知。那么,GPT到底是什么?它的核心——又是怎么运作的?今天,我们通过一组直观有趣的图示,带你理解GPT背后的关键概念。

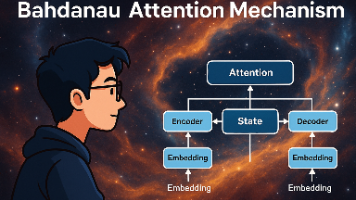

摘要:Bahdanau注意力机制是解决传统Seq2Seq模型固定长度上下文瓶颈的关键创新。该机制通过在每个解码时间步动态计算注意力权重,使模型能够聚焦源序列中最相关的部分。相比固定上下文向量,Bahdanau注意力显著提升了长序列处理能力,特别是在机器翻译任务中BLEU分数的表现。其核心是加法注意力评分函数,通过MLP处理拼接后的query和key,再经softmax归一化。该机制具有良好可解释性

视觉Transformer(ViT)将Transformer架构引入计算机视觉领域,通过图像分块(PatchEmbedding)将图片转换为类似NLP的token序列,配合位置编码和分类标记(<cls>)处理。ViT的核心优势在于全局建模能力,特别适合大规模数据场景,但小数据集表现弱于传统CNN。企业应用中,Google、NVIDIA等公司利用ViT处理医疗影像、商品识别等高精度任务。

..语义分割关注像素级别的图像内容解析;VOC2012 是经典入门数据集;标签使用颜色编码,训练前需转换为索引;图像与标签裁剪应同步处理;可通过 Dataset 封装 + DataLoader 组织训练流程。语义分割是众多应用(自动驾驶、医学、视觉智能剪辑)的核心技术;数据组织、增强、标签映射规范化,是大厂模型可复用的关键;主流工业系统都采用标准数据结构(如 VOC、COCO 格式)作为底层训练格

本文系统介绍了深度学习多GPU训练的三种主要方法:网络分区、分层分区和数据并行。重点阐述了数据并行的实现原理,包括数据分发、梯度同步等核心流程,并通过LeNet实验验证了多GPU训练效果。文章还提供了工程实践建议,如使用DistributedDataParallel框架、处理BatchNorm同步问题等。最后从面试角度总结了分布式训练的关键概念和常见问题解决方案,涵盖数据并行与模型并行的对比、al