简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

神经网络预测推理---TensorRT: (比Tensorflow的推理快20倍)1. Kernel融合: 横向融合(例如1*1卷积等), 纵向融合(卷积+bias+Relu),消除concatenate层(预分配输出缓存,跳跃式的写入);2. 量化成FP16或者INT8: 减少显存占用,加快推理速度;3. Auto-Tuning:例如,对于卷积计算有若干种算法,TensorRT会...

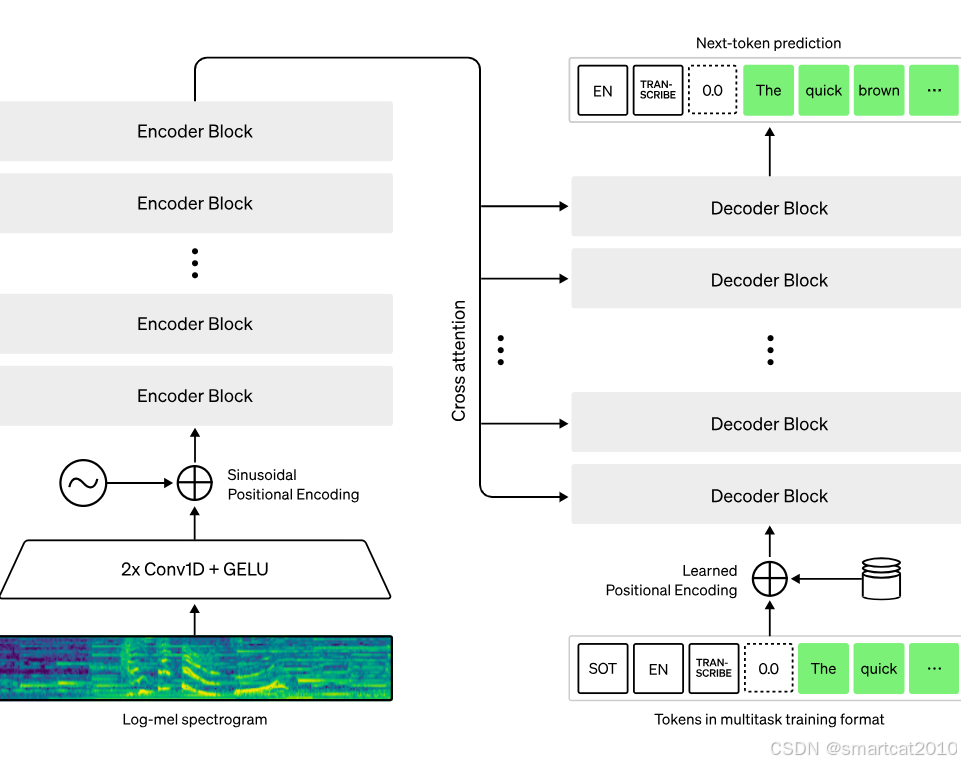

Encoder-Decoder结构。68万小时的监督数据,做的训练。

APC技术,遇到新prompt和老prompt前缀完全相等的,则复用老prompt的KV cache,避免重新计算。3. 只要前面有1个字符不同,后面完全相同的部分,也不能被视为公共前缀。2. prefill公共前缀较长,且decode output较短时,KV cache复用的威力才能发挥出来。则把长文档放到前面,可以复用KV cache。enable_prefix_caching,prompt

多模态上做了很多新功能。

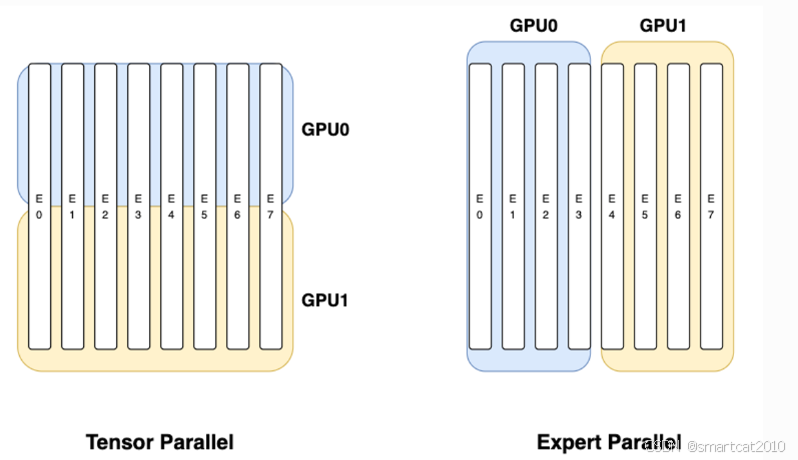

限制:二者的乘积,必须等于模型并行(不是指moe_tp_size,而是整个模型的tp_size)的卡数。moe_ep_size:按照Expert切分,每个GPU有用一部分Expert的所有权重。moe_tp_size:按照维度切分,每个GPU拥有所有Expert的一部分权重。二者可以搭配一起使用。

每个SM block上的Q,负责和所有K和所有V进行计算,得到对应的结果。但是,在decoding阶段,因为Query的seqLength=1,且batchSize=1,因此SM block数目无法都利用上。缺点:最后需要将不同SM block上的中间结果,进行通信,进行归一化的softmax和结果Reduce。在prefill阶段,seqLength*batchSize*Heads足够多,所以每

SmoothQuant是W8A8,GPTQ是W8A16,两者一起使用,可以得到精度损失更小的W8A8量化。

4.MoE的load-balance:训练中,边训练,边调整每个MoE的路由权重。负载高的减少权重,负载低的增加权重。缺点是影响模型训练的主目标)。可以一次推理多个tokens。3.基础架构:MoE,同等参数量(模型的”能力“)下,训练、推理的计算量大幅减少。2.基础架构:MLA,大幅减少了KVcache大小。训练的时候就是一次预测多个tokens,推理时也这样,所以效果更好。限制每个token最