简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

GLM-4.7-Flash最新模型采用30B总参数/3B激活参数的混合架构,在开源模型中表现最优。该模型在SWE-bench等基准测试中超越同类产品,编程能力突出,适合开发者使用。实际部署时速度略慢于7B模型,但回答质量较高,能详细解释"天空为什么是蓝色"等科学问题,考虑瑞利散射、人眼感知等多方面因素。提供魔搭社区和Ollama两种部署方式,尽管存在速度问题,仍因其出色性能值得

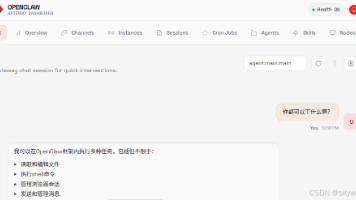

摘要:百度云推出0.01元体验OpenClaw活动,用户可低价获取预装OpenClaw的轻量服务器。开通后需配置千帆大模型API并选择模型(如ERNIE-Lite-Pro等),按token计费。虽然支持修改配置文件接入其他模型,但实测存在配置不生效或响应失败问题。文章详细介绍了从购买部署到模型选择的完整流程,并分享了SSH登录和配置文件修改的尝试,最终建议直接使用官方提供的稳定模型服务。(149字

摘要:本文记录了使用老款Quadro K4200显卡配置PyTorch GPU环境的过程。通过安装适配CUDA 11.4的PyTorch cu118版本,成功识别出GPU设备。关键步骤包括卸载CPU版PyTorch、安装GPU版本,并验证torch.cuda.is_available()返回True。结果表明,尽管K4200是较老的Kepler架构(Compute Capability 3.0),

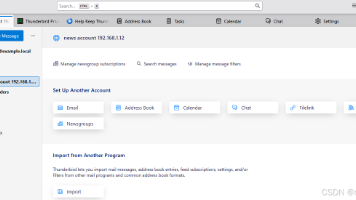

INN的安装,真的是太有趣了!还是挺怀念当前的新帆新闻组啊!INN新闻组,在AI爆发的2026年,估计会迎来新的应用机会!

技术的升级真是让人感叹啊!现在邮箱系统比以前要复杂很多,但是安装却简单了很多。尤其是有不懂的地方,都可以问AI。尽管我用了好几天才搞定开源邮箱系统的安装这件事,也已经很开心了。

本文介绍了在FreeBSD系统上配置Fail2Ban安全工具的完整流程。Fail2Ban通过分析日志文件,自动封禁多次认证失败的IP地址,支持IPFW、PF和IPF三种防火墙。主要内容包括:1) 安装方法(pkg或ports);2) 配置要点(需创建.local文件而非修改原配置);3) 针对不同防火墙(IPFW/PF/IPF)的具体设置步骤;4) 测试方法(手动封禁/解禁IP)及状态查看;5)

文章摘要:本文对比三款AI编程辅助工具,重点推荐Auto-Coder在代码生成效果与控制台体验上的优势,同时分析国产工具Trae和iFlow的特点。Auto-Coder虽需自配大模型API且部分闭源,但其智能自动化表现突出;Trae专注IDE开发但无Web/Linux版;iFlow操作简易但稳定性待验证。建议个人开发者首选Auto-Coder控制台版,企业用户可考虑Trae或持续关注iFlow发展

在FreeBSD系统安装过程中出现多个软件包的警告信息:db5端口已废弃且无维护者,建议改用b18;UUCP服务需要配置/etc/periodic.conf.local文件;freetype2字体渲染引擎更新了默认子像素提示模式;Python 3.11部分标准模块需单独安装。安装INN新闻服务器时遇到目录权限问题,通过创建/usr/local/news/db/history.dir目录并设置new

本文介绍了如何在V100 GPU上适配ERNIE-4.5-0.3B模型的微调任务。主要内容包括:1) 下载安装华为云CodeArts开发工具;2) 分析H100/A100与V100的硬件差异(FlashAttention、BF16精度、GQA支持等);3) 提供三种适配方案(全量微调、LoRA微调、单卡微调)及详细配置参数;4) 常见问题排查方法;5) 性能预期与训练监控建议。项目包含完整的微调脚

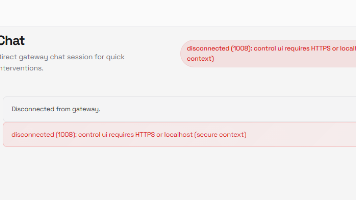

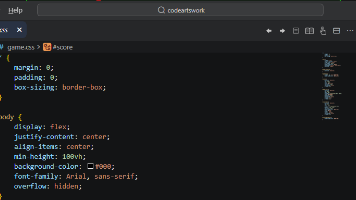

OpenClaw是一款快速迭代的AI助手项目,三天内经历了多次更名。它支持多平台安装,通过npm或bash脚本即可快速部署,但需配置PATH环境变量。启动后会显示一个带安全警告的ASCII艺术界面,提示该工具仍处于测试阶段,可能存在安全风险。项目建议用户设置沙盒环境、最小权限和定期安全审计。安装后可通过18789端口启动网关服务,但目前消息发送功能依赖其他通讯软件支持,存在一定使用限制。整体来看,