简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

大模型时代,agent的使用已经常态化了,不管是AI coding,还是manus这种通用agent。有些场景,人们希望agent可以一直工作,不要经常停下来,直到完成目标,比较常见的是AI coding。而有些场景,人们希望大模型没有把握的时候,能够问一下人类,这种场景就属于human in the loop,今天介绍下。Human-in-the-Loop(HITL) 指的是一种混合的 AI 系

当前AI coding领域里面,最强的应该是claude code了,但是它并不开源,妨碍了人们对它的理解和使用。当前比较火的,开源的,和claude code很像的是opencode,今天简要介绍下。和claude code类似,本质上其是一个ai agent,用于代码提效。OpenCode Agents 是一套用于构建自主化、多阶段、可恢复(self-healing)的文档生成 / 代码自动化

现在大模型依旧如火如荼,大模型训练和推理都少不了AI服务器,常见的就是英伟达GPU服务器,比如A100等。国产AI服务器也有很多,比如华为昇腾,这些服务器的算力如何,和英伟达的对比怎么样,作为大模型应用开发人员,需要有个了解,这样对部署的大模型性能有个大致判断。作为一个大模型应用工程师,了解国产AI服务器的指标,有利于掌握AI服务器的选型,也有利于在部署模型时,清楚模型运行的性能,知道优化模型性能

现在大模型依旧如火如荼,大模型训练和推理都少不了AI服务器,常见的就是英伟达GPU服务器,比如A100等。国产AI服务器也有很多,比如华为昇腾,这些服务器的算力如何,和英伟达的对比怎么样,作为大模型应用开发人员,需要有个了解,这样对部署的大模型性能有个大致判断。作为一个大模型应用工程师,了解国产AI服务器的指标,有利于掌握AI服务器的选型,也有利于在部署模型时,清楚模型运行的性能,知道优化模型性能

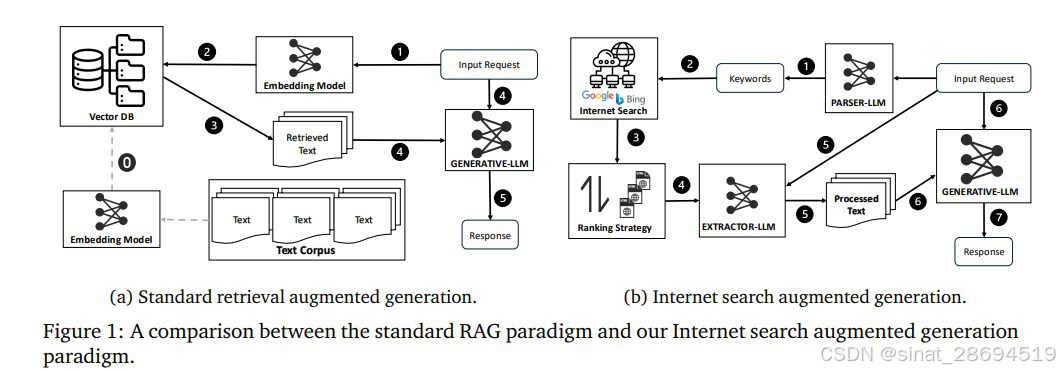

Search-Augmented Generation,即搜索增强生成,它强调通过实时搜索增强生成过程,但与 RAG 不同,SAG 可能会依赖实时的搜索引擎(如Google或专用的API)来获取信息,而不仅仅是依赖预先索引的数据。SAG 的检索阶段可能会更灵活,直接使用搜索引擎的结果。SAG是一种特殊的RAG,RAG 适用于基于预先索引的资料进行回答,能够根据内部的索引数据快速响应,但对实时信息更

大模型仍在以前所未有的速度进行发展,大模型的应用也在迅速发展,目前大模型使用mcp工具越来越多,比较特殊的一种是让大模型操作浏览器的mcp,因为目前人们接触互联网大多通过浏览器的方式,下面我们来介绍一下browser-use。browser-use 是一个开源的 Python 库,旨在让大型语言模型(LLM)直接控制真实浏览器,实现网页自动化任务。

在构建智能体 (AI Agent) 的过程中,“记忆系统”是核心能力之一。特别是当 Agent 需要跨会话、跨任务地长期维持对用户偏好、历史经历、目标进展等信息的认知时,长期记忆 (Long-term Memory) 就显得尤为重要。RAG(Retrieval-Augmented Generation):将外部知识库(如文档、手册、知识库)向量化存储,模型在推理时检索相关片段来辅助生成。这种机制与

自从ReAct论文发布以后,ReAct范式agent就受到了大家广泛的关注,它被证实可以用来提高大模型的推理能力。本文以ReAct范式为基础,没有使用任何框架,简单实现演示了ReAct的过程。ReAct它是一种基于prompt的范式,下面展示了几种prompt的差别,它们分别是(a)标准(b)思考链(c)只有Act(d)ReAct。

现在大模型依旧如火如荼,大模型训练和推理都少不了AI服务器,常见的就是英伟达GPU服务器,比如A100等。国产AI服务器也有很多,比如华为昇腾,这些服务器的算力如何,和英伟达的对比怎么样,作为大模型应用开发人员,需要有个了解,这样对部署的大模型性能有个大致判断。作为一个大模型应用工程师,了解国产AI服务器的指标,有利于掌握AI服务器的选型,也有利于在部署模型时,清楚模型运行的性能,知道优化模型性能

在rag流程中,经常会遇到大模型输出慢的问题,比较影响用户体验。在大模型应用中,如何优化大模型输出性能,减少延迟呢,一般有如下准则。以上是几种优化rag流程大模型输出延迟的方案,这些方案的使用成本不同,可以针对具体情况进行使用。参考。