简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

seedream这个就是即梦

如果你是初学者,这篇文章会像一个温柔的导游,带你一步步理解为什么它能“聪明”地找到函数的最优解;如果你有数学背景,你会发现这里藏着泰勒展开的精妙推导和一阶近似的深刻洞见。

LANA通过创新的两阶段框架和整数线性优化,显著提升了神经网络加速的效率和效果。其逐层操作、超大搜索空间支持以及快速搜索能力,为深度学习研究者提供了宝贵的参考。

reduce_scatter

From the 1867 Tourbillon with Three Gold Bridges to the modern Neo Bridges and Laureato collections, Girard-Perregaux continues to blend mechanical excellence, artistic design, and innovation, solidif

通过引入一个统一视角,我们可以将常见的后训练(强化学习)方法归结到同一个公式框架下,并关注三大关键:数据源(离线 vs. 在线)、奖励函数(规则 vs. 模型)以及算法/梯度系数(SFT、RFT、DPO、PPO、GRPO 等)

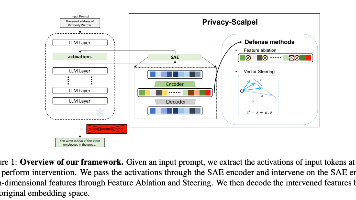

《PrivacyScalpel: Enhancing LLM Privacy via Interpretable Feature Intervention with Sparse Autoencoders》

只分区优化器状态(比如 Adam 的动量和方差)。这是入门级,适合模型参数和梯度还能塞下,但优化器状态吃太多内存的情况。