简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

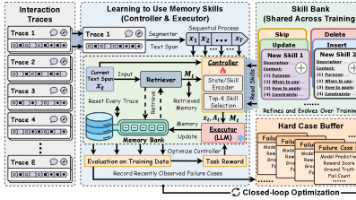

本文提出MemSkill框架,让AI智能体能够自主学习和进化记忆技能,而非依赖预设规则。该系统包含三个核心组件:Controller负责动态选择记忆技能,Executor执行多技能组合操作,Designer通过分析失败案例不断优化技能库。实验表明,在对话、问答和具身任务中,MemSkill均超越现有记忆系统。该研究突破了传统CRUD记忆模式的局限,使智能体能够根据不同场景需求自主发展专业化记忆策略

本文提出MemSkill框架,让AI智能体能够自主学习和进化记忆技能,而非依赖预设规则。该系统包含三个核心组件:Controller负责动态选择记忆技能,Executor执行多技能组合操作,Designer通过分析失败案例不断优化技能库。实验表明,在对话、问答和具身任务中,MemSkill均超越现有记忆系统。该研究突破了传统CRUD记忆模式的局限,使智能体能够根据不同场景需求自主发展专业化记忆策略

InternAgent-1.5:自主科学发现的新范式 上海人工智能实验室提出的InternAgent-1.5框架突破了传统AI智能体的局限,构建了一个"生成-验证-进化"的闭环系统,使AI能够像人类科学家一样进行长周期的自主研究。该框架包含三个核心子系统:生成子系统负责深度文献分析和假设构建;验证子系统实现实验设计与优化;进化子系统通过长视界记忆实现知识积累和经验迁移。在GPQ

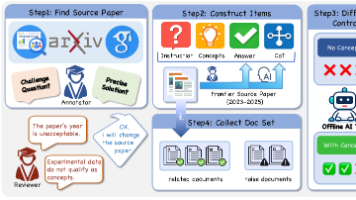

AI2和华盛顿大学团队推出How2Everything框架,系统评估大模型"教人做事"的能力。该研究从98万网页中自动化挖掘出35万份高质量操作指南,覆盖14个主题领域。创新性地提出"关键失败"评估标准,通过二元判定(可用/不可用)取代传统评分,更精准识别步骤遗漏、危险动作等致命错误。研究还训练出8B参数的How2Judge评估模型,与GPT-5评估一致性达

研究人员构建了GISA基准测试,通过结构化答案格式评估AI搜索助手的真实能力。测试发现,即使最先进的Claude 4.5 Sonnet模型准确率仅19.3%,远低于人类专家的78%。GISA揭示了AI在复杂信息搜寻任务中的主要瓶颈:搜索层级错误占比近50%,表现为浅层浏览习惯和深度信息挖掘能力的不足。该研究强调当前AI在整合深度推理与广度聚合、网页导航策略以及信息验证等方面仍存在显著差距,为改进搜

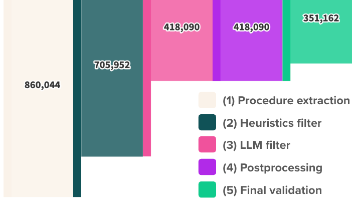

摘要 最新研究DeR2揭示了一个反直觉现象:当大语言模型在RAG(检索增强生成)场景下获得完整参考文档时,其推理表现反而比闭卷测试更差。通过构建包含16个学科领域、严格校准难度的评测数据集,研究发现: 在四种控制设定(仅指令/仅概念/仅相关文档/完整文档集)下,14个前沿模型的平均得分呈现"开卷不如闭卷"现象(完整文档51.1% vs 仅指令55.9%) 主要归因于两大问题:推

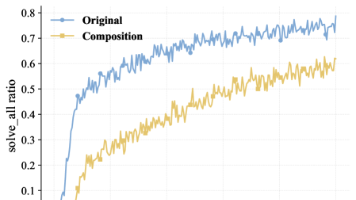

本文提出了一种名为Composition-RL的创新方法,通过将简单数学题拼接组合成复杂题目来提升大模型的推理能力。该方法利用顺序提示词组合(SPC)技术,自动将两道独立数学题合并为一道新题,并保持答案可验证性。实验表明,这种组合显著降低了"全对"样本比例,使训练数据更具挑战性。在多种模型规模(1.5B-30B)的测试中,该方法平均提升8.3个点,在AIME24竞赛题上准确率提

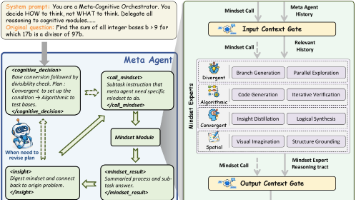

Chain of Mindset (CoM) 提出了一种新型AI推理框架,通过解耦四种思维模式(空间/收敛/发散/算法)并由元代理动态调度,实现了免训练的步级自适应推理。该框架采用三层架构:Meta-Agent作为决策中心,Context Gate进行信息过滤,四种思维专家模块并行工作。实验表明,CoM在6个高难度基准上平均准确率达63.28%,比最优基线提升4.96%,尤其在需要多模态推理的任务

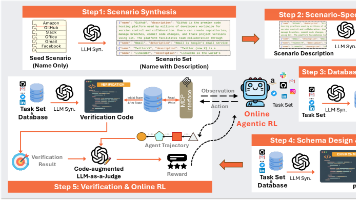

摘要(149字): AWM提出了一种自动化生成代码驱动合成环境的方法,通过四阶段流程(场景生成→任务生成→环境合成→智能体训练)构建了1000个状态一致的POMDP环境。每个环境包含SQLite数据库、Python工具接口和双重验证模块,采用GRPO算法训练智能体。实验表明,在合成环境训练的智能体能有效泛化至真实场景,在BFCLv3、τ²-bench和MCP-Universe基准上分别提升12.1

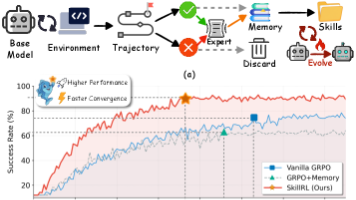

SkillRL框架摘要 SkillRL提出了一种递归技能增强的强化学习方法,通过将原始交互轨迹蒸馏为可复用的技能卡片(10-20倍压缩率),构建分层技能库(通用+特定任务技能),并与GRPO强化学习协同进化。在ALFWorld和WebShop任务中,该方法超越GPT-4o达41.9%,关键创新在于:(1) 教师模型差异化处理成功/失败轨迹生成技能;(2) 冷启动SFT教会模型使用技能;(3) 训练