简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

2025年2月22日,RWKV在上海漕河泾举办了主题为《RWKV-7与未来趋势》的开发者大会。来自全国各地的开发者、行业专家和技术创新者齐聚一堂——从知名高校实验室到前沿创业团队,现场涌动的创新能量印证了RWKV-7的优秀性能和深远意义。在RWKV开发者大会期间,有多位来自学界、企业及RWKV开源社区的嘉宾为开发者带来深度分享,现场观众与嘉宾热烈互动。

近日 RWKV 生态新增来自海外名校的两项工作:Stanford(斯坦福大学)团队的 RWKV 多智能体研究,和 UVa(弗吉尼亚大学) 团队的 RWKV 端侧优化研究。

Ollama现已支持RWKV7-G1和RWKV-7-World模型系列,用户可通过简单命令安装并运行这些模型。操作步骤包括下载Ollama、安装后运行指定模型命令,支持对话模式切换和上下文管理。推荐使用RWKV7-G1系列模型,还提供了RWKV Chat应用作为替代选择。用户可访问RWKV中文官网和社区获取更多资源与支持。

PENG Bo发表关于大模型的认知的观点,同月发布RWKV7+ROSA完成数字颠倒任务Demo

在 Uncheatable Eval 超越 Qwen3 14B。近期也更新了 1B 和 3B 模型。

2025年8月,RWKV社区迎来多项重要进展:模型方面,开源发布RWKV-7s 0.1B版本,并启动了13.3B大模型的训练,在三分之一进度时MMLU测试已达63.21%。学术研究取得突破,5篇新论文发表于IEEE TCCN、Interspeech等顶级期刊会议,涵盖4G/5G服务预测、语音识别、骨签匹配、图像超分辨率等多个领域。社区还参与了全球互联网大会,展示了RWKV技术的最新应用成果。这些进

欢迎大家收看《RWKV 社区最新动态》,本期内容收录了 RWKV 社区 2025 年 1 月的最新动态。只需 3 分钟,快速了解 RWKV 社区 1 月都有哪些新鲜事!

RWKV7 G1c 仅需 3B 参数量,即可配合 state-tuning 可轻松完成复杂 agent 角色扮演

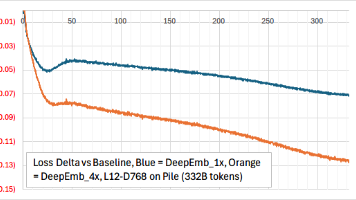

RWKV-8 "Heron" 是我们的下一代架构,具有多个全新技术。在此我们首先公布其中的 DeepEmbed 技术,它可以实现类似 MoE 的优秀推理性能,同时无需占用显存,甚至无需占用内存,可以让稀疏的大模型真正部署到所有端侧设备。

2025 年 3 月 10 日,RWKV 基金会发布第一个0.1B。RWKV7-G1 系列模型拥有,且原生支持世界 100+ 种语言和代码。即使是最小的 0.1B 也能回答。RWKV7-G1(“GooseOne”)系列推理模型是基于 World v3.5 数据集RWKV-7 “Goose” World 系列模型。World v3.5 数据集包含更多小说、网页、数学、代码和 reasoning 数据