简介

该用户还未填写简介

擅长的技术栈

未填写擅长的技术栈

可提供的服务

暂无可提供的服务

Datawhale AI夏令营- 讯飞机器翻译挑战赛baseline解析

本文介绍了训练机器翻译挑战赛的赛题,以及基于datawhale的baseline写了一篇解析。通过seq2seq完成了一个机器翻译模型的搭建

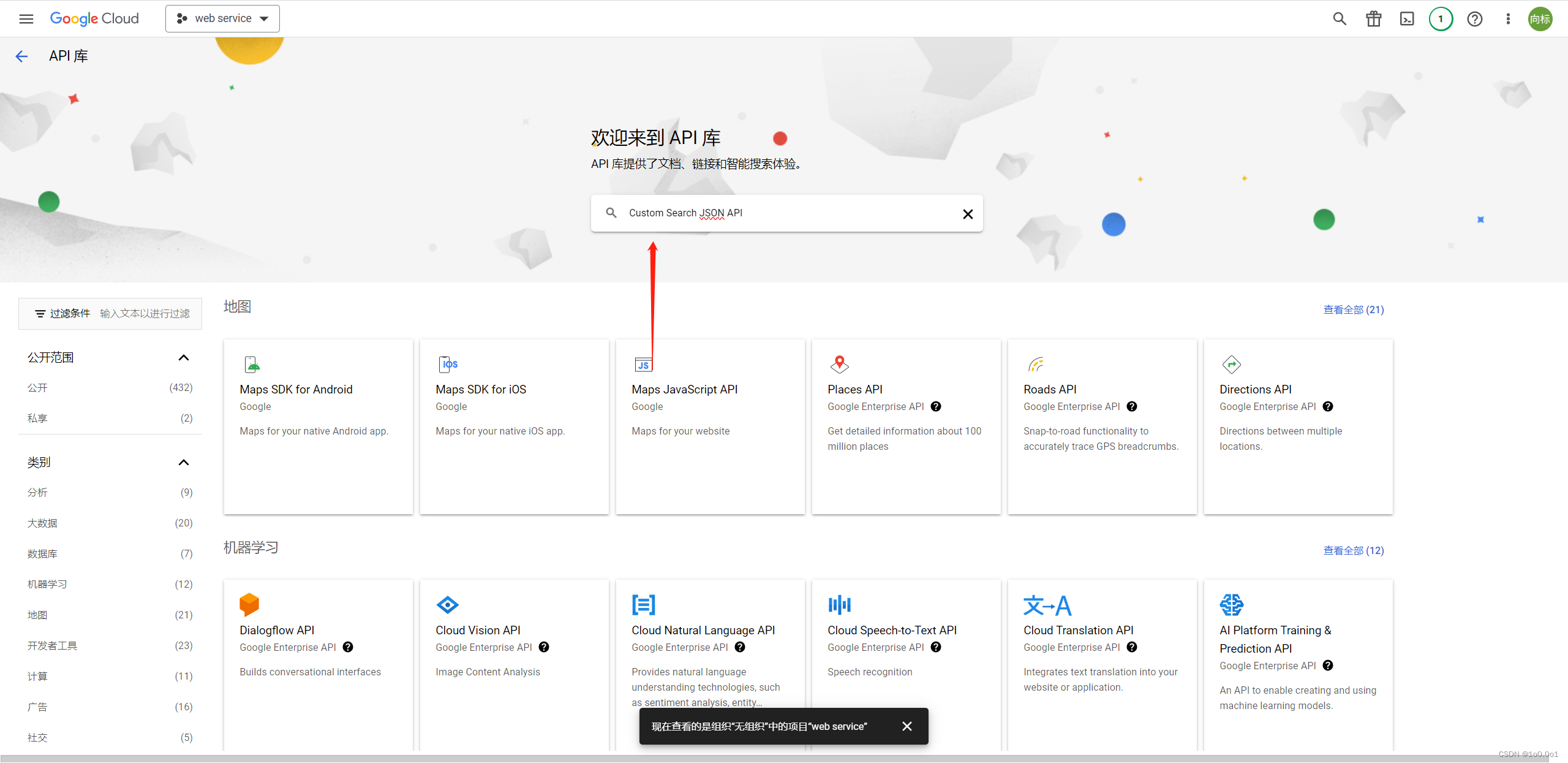

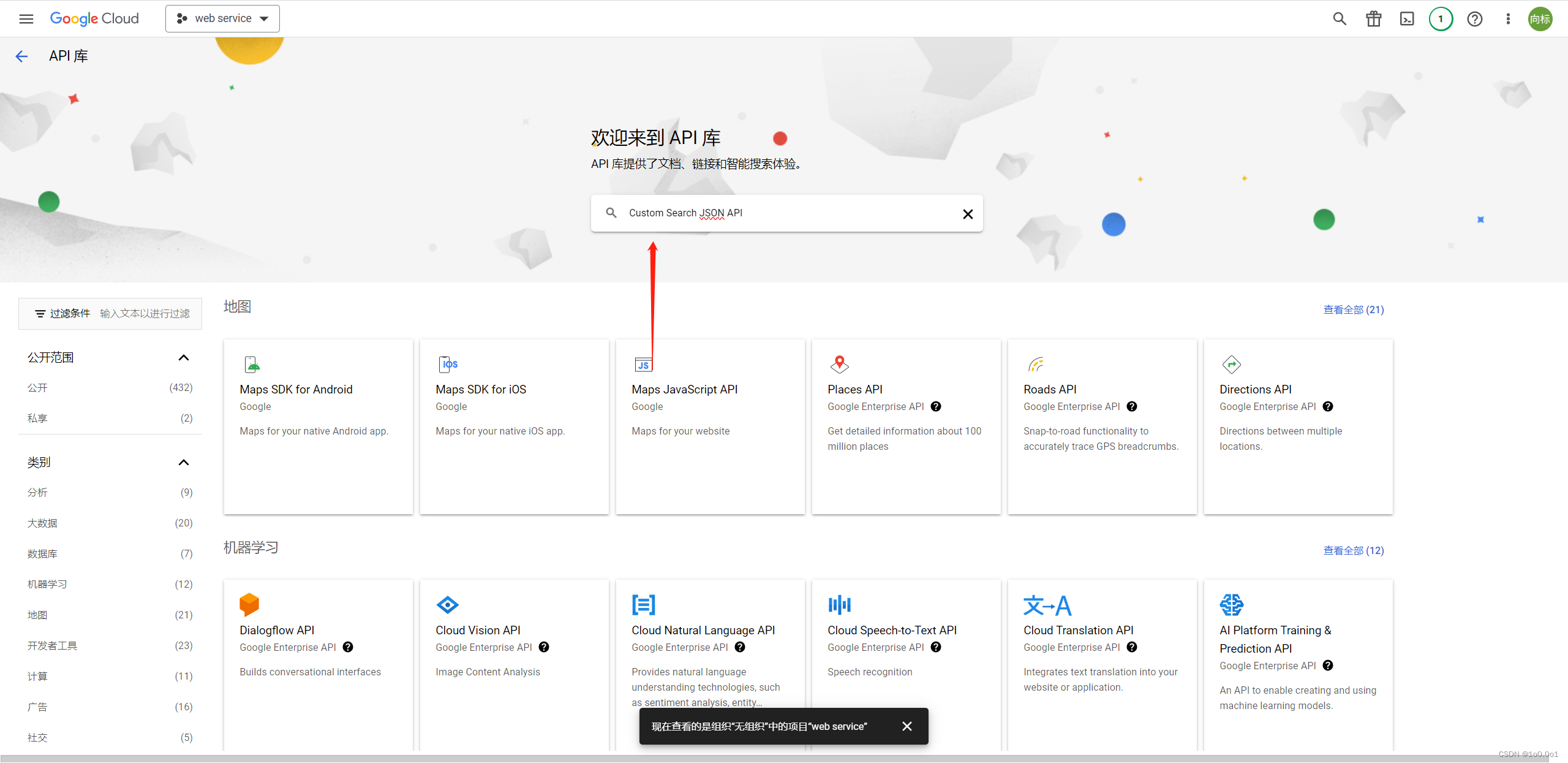

用python实现chatgpt的联网功能

本文主要提供了如果获取谷歌API和搜索引擎ID,以及利用langchain和爬虫结合实现联网功能

到底了

该用户还未填写简介

暂无可提供的服务

本文介绍了训练机器翻译挑战赛的赛题,以及基于datawhale的baseline写了一篇解析。通过seq2seq完成了一个机器翻译模型的搭建

本文主要提供了如果获取谷歌API和搜索引擎ID,以及利用langchain和爬虫结合实现联网功能