简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

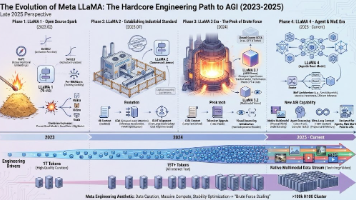

LLaMA 1到3的飞跃,主要不是靠改模型结构(一直都是Decoder-only Transformer),而是靠更高质量的数据清洗(Data Curation)和更暴力的Scaling。Meta证明了:即便模型参数不大(如7B, 13B),只要用足够多、足够高质量的数据(1T tokens)去“过饱和”训练,性能可以吊打比它大得多的模型(如GPT-3 175B)。:模仿了OpenAI o1系列的

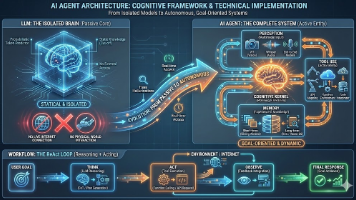

LLM(如 GPT-4, Llama 3, Qwen)本质上是一个概率预测机器。输入一段文本,根据海量训练数据,概率性地预测下一个 Token 是什么。它是静态的、被动的。它没有身体,无法联网(除非外挂),无法直接操作数据库,且它的知识截止于训练结束的那一刻。它就像一个被锁在密室里、读过人类所有书籍的“天才”,但他瘫痪在床,且与外界完全隔绝。Agent 指的是一个能够感知环境、进行推理决策,并采取

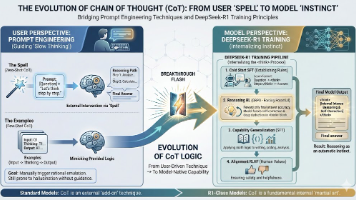

本文深入探讨思维链(CoT)从用户技巧到模型本能的演变过程。在用户层面,CoT通过"一步步思考"的提示词引导AI展示推理过程,分为零样本和少样本两种应用方式。在模型层面,以DeepSeek-R1为例,详细解析了CoT内化的四个阶段:冷启动SFT建立格式、强化学习逼出推理能力、泛化训练扩展应用场景、RLHF对齐人类价值观。文章指出,新一代模型已内化CoT能力,自动进行深度思考,而

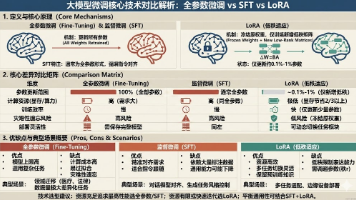

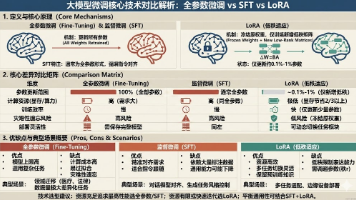

本文对比分析了三种大模型微调技术:全参数微调(更新所有参数)、监督微调(SFT,侧重指令对齐)和LoRA(低秩适应,仅训练少量参数)。全参数微调适合领域重构但成本高,SFT擅长指令对齐,LoRA则资源友好但表达能力受限。建议资源充足时采用全参数微调或SFT,资源有限时选择LoRA,或结合SFT与LoRA实现通用性与专业性的平衡。技术选择应基于具体任务需求、数据特点和算力条件。

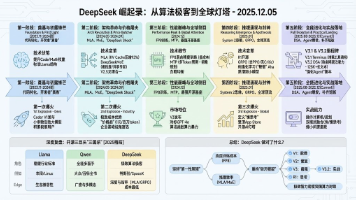

摘要: DeepSeek(深度求索)从2023年至今完成了从追赶者到AGI领跑者的蜕变,其发展分为五个阶段: V1阶段(2023-2024初):聚焦代码与数学能力,以DeepSeek Coder V1在开发者圈层引爆,击败千亿参数模型。 V2阶段(2024年中):通过MLA(多头潜在注意力)和MoE架构实现极致成本优势,发动“价格战”成为企业首选。 V3阶段(2024年底):采用FP8训练和MTP

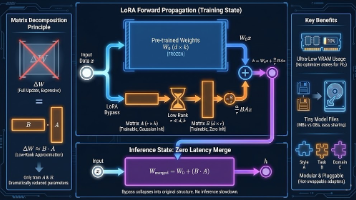

LoRA (Low-Rank Adaptation) 是一种非常高效的微调(Fine-tuning)技术,目前广泛应用于大语言模型(LLM)和图像生成模型(如 Stable Diffusion)的定制化训练中。

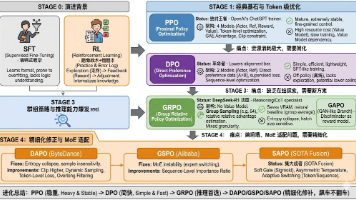

摘要:大模型对齐技术经历了从PPO到SAPO的四阶段演进。PPO作为传统强化学习方法稳定但资源消耗大;DPO简化流程但缺乏探索性;GRPO通过组采样优化实现高效推理训练;最新DAPO/GSPO/SAPO方案则针对长文本和MoE模型进行优化,通过动态采样、序列级约束和软门控等创新解决熵坍塌和稳定性问题。这一演进路径展现了从复杂到精简再到精细化的发展趋势,使大模型在保持性能的同时显著提升了训练效率。

本文对比分析了三种大模型微调技术:全参数微调(更新所有参数)、监督微调(SFT,侧重指令对齐)和LoRA(低秩适应,仅训练少量参数)。全参数微调适合领域重构但成本高,SFT擅长指令对齐,LoRA则资源友好但表达能力受限。建议资源充足时采用全参数微调或SFT,资源有限时选择LoRA,或结合SFT与LoRA实现通用性与专业性的平衡。技术选择应基于具体任务需求、数据特点和算力条件。

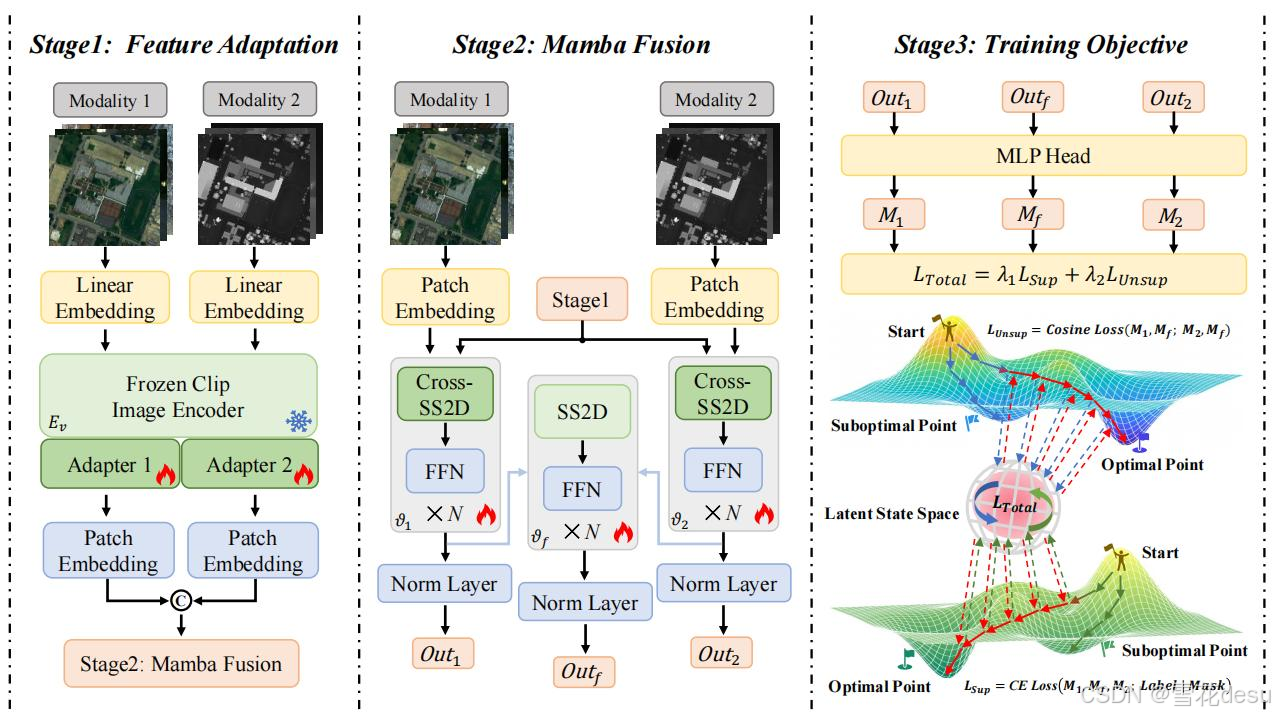

4.融合特征:多张特征输入输出一个融合特征,用attention,若是有顺序,加上position embedding。使用CLIP(ViT-B/16)图像编码器提取多模态图像的语义特征,并通过模态特定适配器增强模态感知能力。C:无监督一致性损失:移除后,模型性能显著下降,表明其对模态一致性的增强效果。kappa (κ):模型生成的分类图与地面真相之间的一致性的统计度量。结合CLIP的语义提取和M

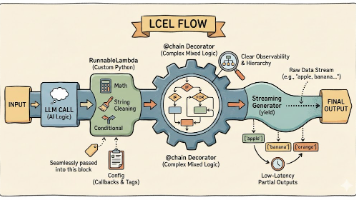

摘要:LangChain表达式语言(LCEL)是AI应用开发的重要工具,提供了10个核心特性解决生产级问题:1)数据流控制(RunnablePassthrough、RunnableParallel);2)运行时参数绑定;3)自定义逻辑嵌入;4)混合开发装饰器;5)流式处理支持;6)容错回退机制;7)记忆管理;8)动态路由决策;9)可视化调试工具。LCEL实现了从脚本开发到声明式编排的转变,通过标准