简介

该用户还未填写简介

擅长的技术栈

未填写擅长的技术栈

可提供的服务

暂无可提供的服务

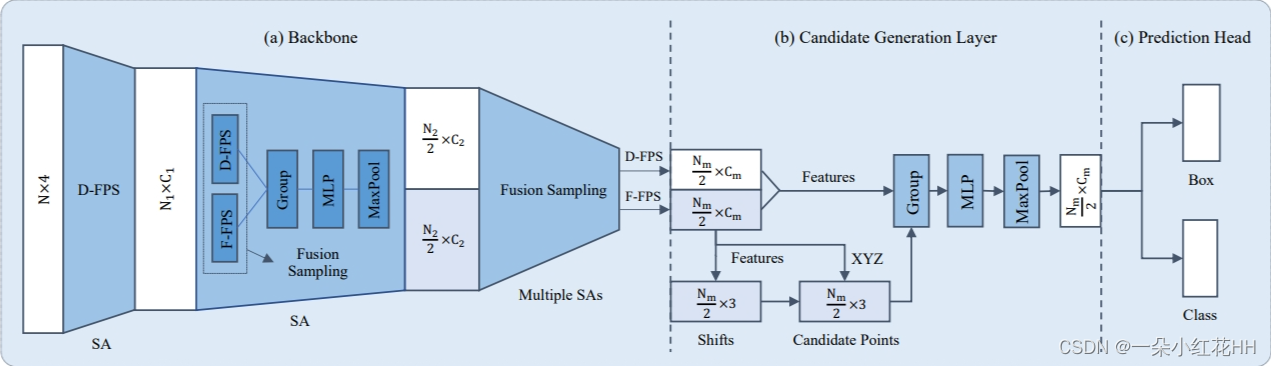

[论文阅读]3DSSD——基于Point的三维单阶段目标检测器

3DSSD论文阅读

[论文阅读]KD——神经网络中的知识提取(知识蒸馏)

提高几乎任何机器学习算法性能的一个非常简单的方法是在相同的数据上训练许多不同的模型,然后对它们的预测进行平均[Ensemble methods in machine learning]。不幸的是,使用整个模型集合进行预测是很麻烦的,而且计算开销太大,不允许部署到大量用户,尤其是如果单个模型是大型神经网络。[Model compression]已经表明,将集合中的知识压缩到一个更容易部署的单一模型是

[论文阅读]KD——神经网络中的知识提取(知识蒸馏)

提高几乎任何机器学习算法性能的一个非常简单的方法是在相同的数据上训练许多不同的模型,然后对它们的预测进行平均[Ensemble methods in machine learning]。不幸的是,使用整个模型集合进行预测是很麻烦的,而且计算开销太大,不允许部署到大量用户,尤其是如果单个模型是大型神经网络。[Model compression]已经表明,将集合中的知识压缩到一个更容易部署的单一模型是

到底了