简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

以上就是两种混音方式的对比,综合来看在端侧进行混音效果应该会更好一些,因为腾讯会议以及ZOOM都是采用端侧混音的方式进行的实现。

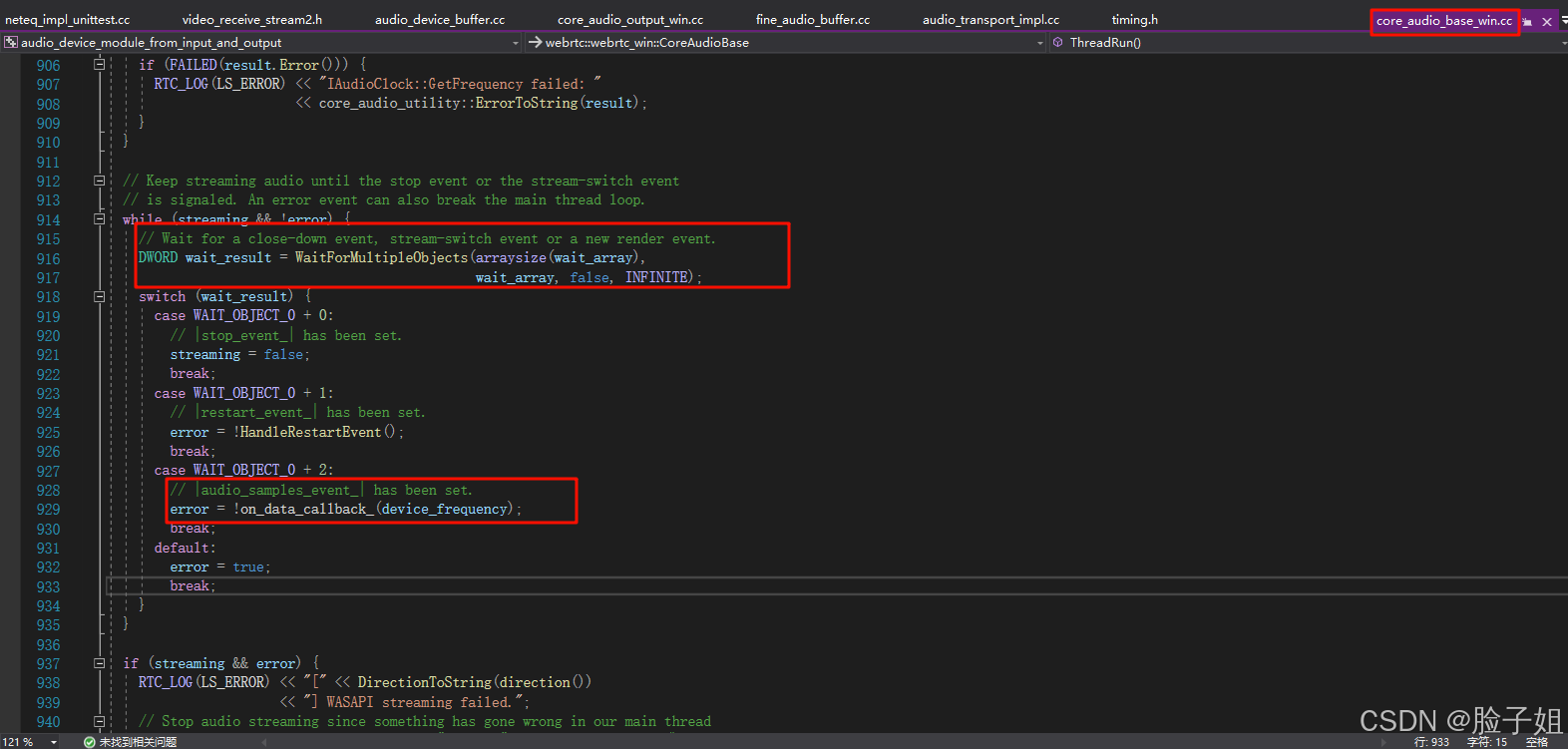

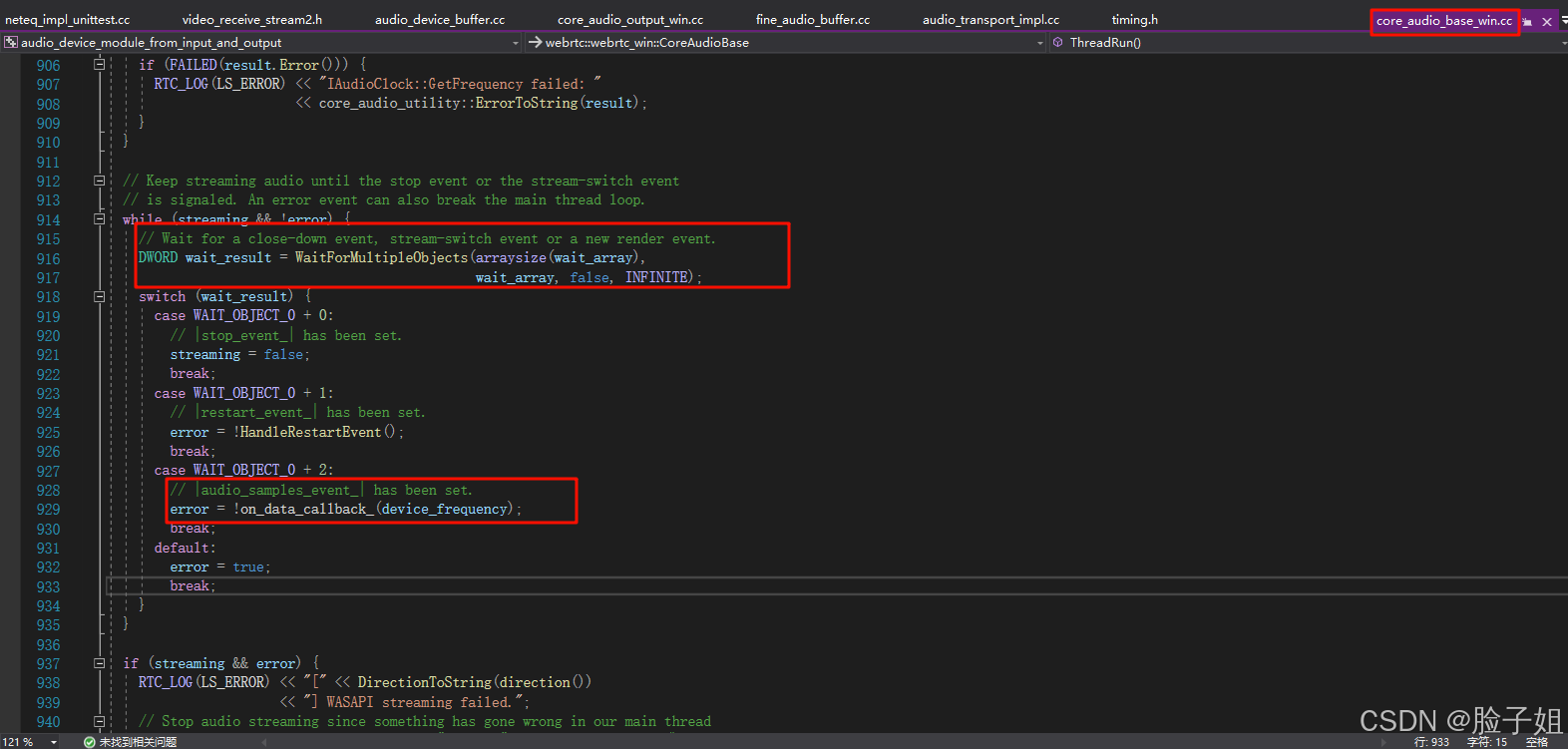

正是由于webrtc中是播放事件驱动音频的获取,当系统负载过高实际播放一帧20ms的音频消耗的时间超过20ms的情况下,pcm数据会堆积在neteq内部,neteq感知的内部pcm数据堆积过多时会通过相关的算法对音频pcm数据进行加速融合,比如将1000个音频采样点压缩为900个采样点而不改变声调,做到不增加延时也不丢pcm数据。以win平台的音频播放为例,在core_audio_base_win

本文介绍了如何在VSCode中通过图形化界面远程调试嵌入式Linux开发板程序。主要步骤

正是由于webrtc中是播放事件驱动音频的获取,当系统负载过高实际播放一帧20ms的音频消耗的时间超过20ms的情况下,pcm数据会堆积在neteq内部,neteq感知的内部pcm数据堆积过多时会通过相关的算法对音频pcm数据进行加速融合,比如将1000个音频采样点压缩为900个采样点而不改变声调,做到不增加延时也不丢pcm数据。以win平台的音频播放为例,在core_audio_base_win

在实时通信(RTC)场景下,视频时间戳的设置通常是基于采集时间(系统时间),而不是按照帧率固定递增。这种设置方式能够:准确反映每一帧的实际采集时间,确保音视频同步。适应帧率波动和网络抖动,支持接收端更好的去抖。满足RTC对实时性和低延迟的高要求。如果采用固定递增的时间戳设置方式,可能会因为帧率波动或网络抖动导致时间戳偏差,从而影响音视频的同步和延迟控制。因此,在RTC场景下,基于采集时间的时间戳是

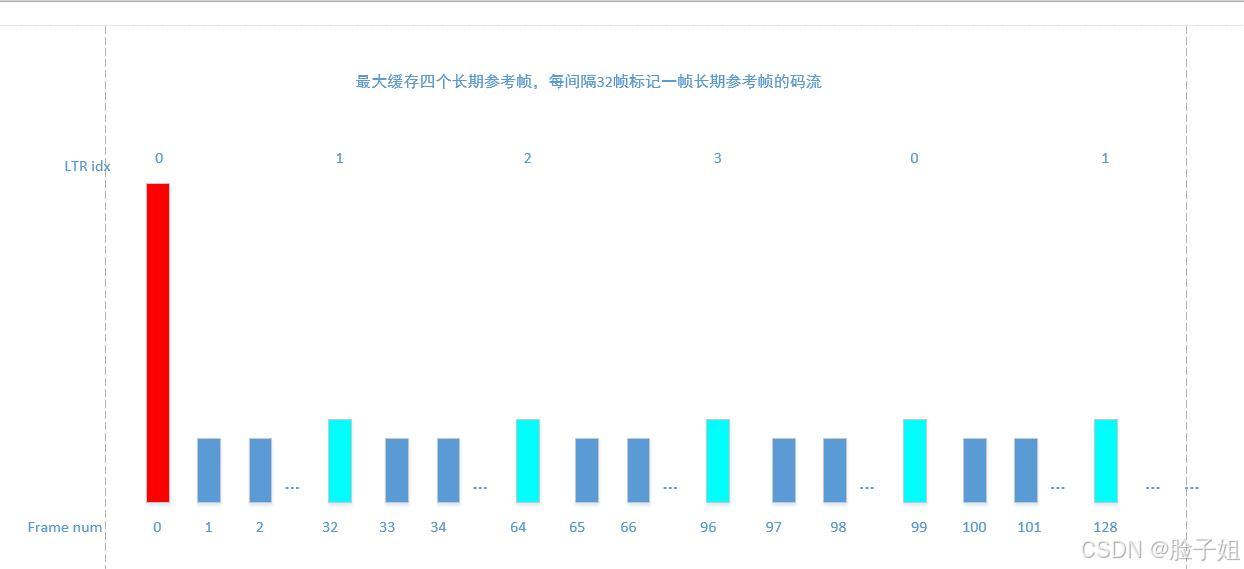

首先要说明一点,长期参考帧和普通的编码帧实际内部编码负载数据没有什么不同,只是编码器将某些P帧标记为长期参考帧,那么被标记的帧内部会带有少许标记信息,实际帧大小和普通P帧几乎没有差别,在编码器内部将某个P帧标记为长期参考帧之后,会长期保存该帧对应的YUV数据,直到出现相同索引的长期参考帧时,才会过期之前的长期参考帧。通常的视频编解码使用短期参考帧,在编码器内部保留上一帧的YUV数据,编码下一帧时通

以上就是两种混音方式的对比,综合来看在端侧进行混音效果应该会更好一些,因为腾讯会议以及ZOOM都是采用端侧混音的方式进行的实现。

7.由于AppRTCMobile中代码默认写死的访问的是https://appr.tc,代码程序还需要进行修改为localhost才能实现正常的点对点通信,搜索所有带https://appr.tc的地方,将相应的代码进行替换,参见我下方图片的替换,不止一个文件有,其他文件有要替换。9.以上操作之后,实际呼叫时还会出现ice建联报错的情况,需修复ARDTURNClient.m文件,我是将报错信息发给

本文介绍了如何在VSCode中通过图形化界面远程调试嵌入式Linux开发板程序。主要步骤

上图横轴为每一帧的时间戳,纵轴为每帧完整时进行处理通过系统接口获取的当前时间now_ms(也可以理解为一帧在接收端接收的时间),其中绿色的点为每帧实际的时间戳对应的实际接收时间now_ms,最下方黑色虚线为结合所有帧的时间戳和now_ms经过卡尔曼滤波之后拟合出来的一个直线,红色点为最后这一帧根据其自身时间戳在拟合的线性关系上预测出的点,其纵轴对应的为预测出的本地时间Localtime,红色点上方