简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

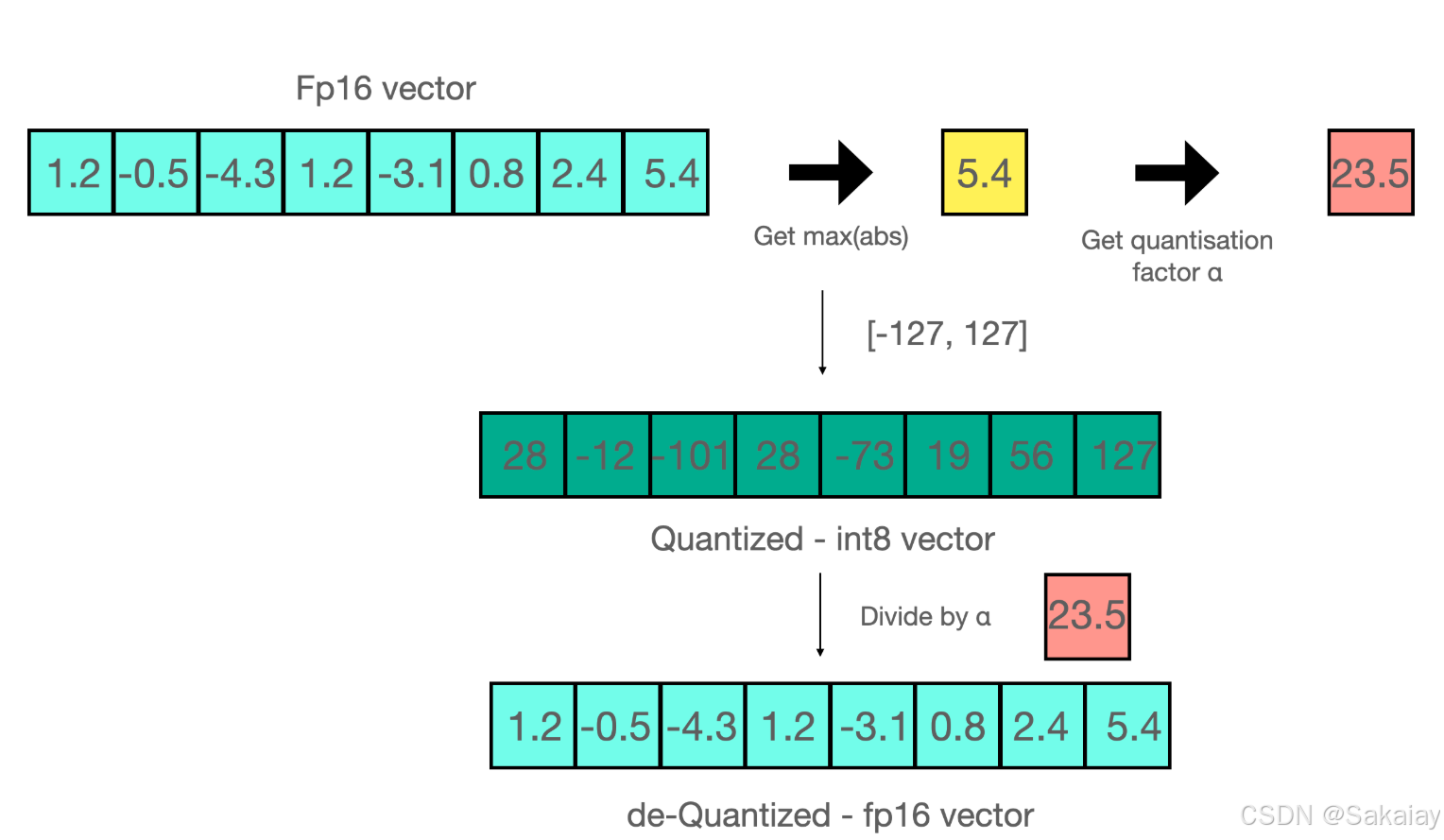

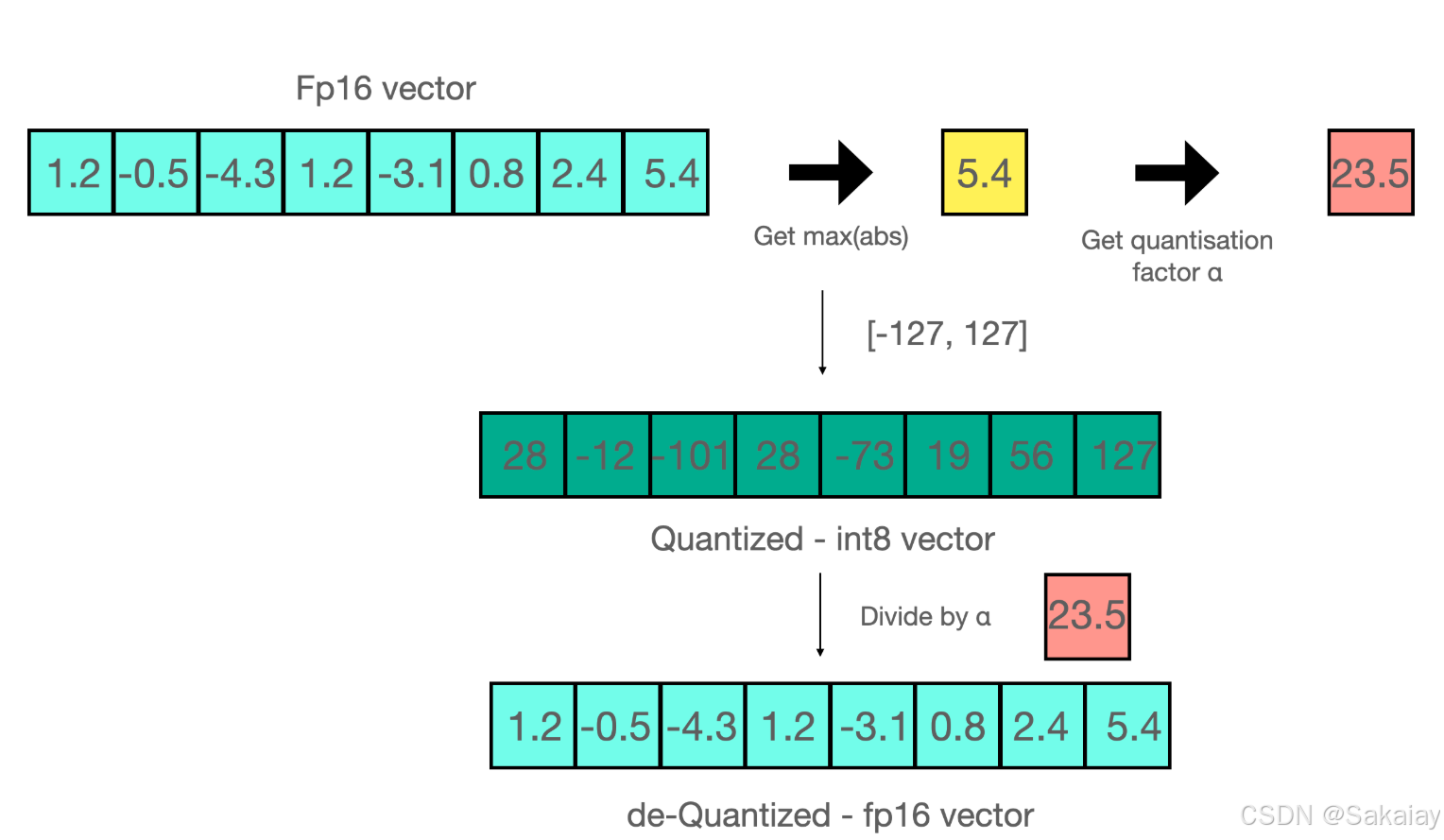

QLoRA的工作有三个,第一个工作是结合了分位数量化和分块量化的4位标准浮点数量化第二个工作是对模型进行两次量化的双重量化(Double Quantization),它的第二次量化只作用在第一次量化产生的量化常数上,可以进一步节约显存占用。第三个工作是分页优化(Paged Optimizer),使用CPU内存代替GPU显存保存部分梯度参数。下面我们来详细介绍它们。这个图很好的展示了全量微调,LoR

(如数据库、硬件设备、业务系统)交互,从而实现更复杂的任务。。当然大模型本身无法调用函数,还得通过程序实现。用户问:北京今天天气怎么样?这个问题是需要的,但是众所周知,大模型裸推的话是无法获取实时信息的。。大模型回答问题的时候发现需要调用函数,并提取参数。整理流程如下所示:name:函数的名字(具体的函数需要自己定义)。:函数的描述。parameters:函数的入参,该例子中只需要一个"locat

统计学习方法——感知机文章目录统计学习方法——感知机什么是感知机函数间隔几何间隔感知机的原始形式感知机的对偶性质什么是感知机参考用书是统计学习方法(李航)感知机是一个二分类线性判别模型,假设输入x∈Rnx\in \mathbb{R}^nx∈Rn,输出y∈−1,+1y\in{-1,+1}y∈−1,+1,感知机为如下函数:f(x)=sign(wTx+b),sign(z)={1z≥0−1z<0f(

QLoRA的工作有三个,第一个工作是结合了分位数量化和分块量化的4位标准浮点数量化第二个工作是对模型进行两次量化的双重量化(Double Quantization),它的第二次量化只作用在第一次量化产生的量化常数上,可以进一步节约显存占用。第三个工作是分页优化(Paged Optimizer),使用CPU内存代替GPU显存保存部分梯度参数。下面我们来详细介绍它们。这个图很好的展示了全量微调,LoR

值范围在 0 到 1 之间,其中分数越高表示精度越高。它是根据ground truth和检索到的Context计算出来的,取值范围在 0 到 1 之间,值越高表示性能越好。**来计算,范围为(0~1),得分越高越说明生成的答案与真实的答案更接近,也就意味着准确性越高。)是否相关,然后计算指标,如果大模型判断相关,并且该上下文的排名靠前,那么分数较高。如果列表为[1,1,0,0]那么最终的分数就是1

(如数据库、硬件设备、业务系统)交互,从而实现更复杂的任务。。当然大模型本身无法调用函数,还得通过程序实现。用户问:北京今天天气怎么样?这个问题是需要的,但是众所周知,大模型裸推的话是无法获取实时信息的。。大模型回答问题的时候发现需要调用函数,并提取参数。整理流程如下所示:name:函数的名字(具体的函数需要自己定义)。:函数的描述。parameters:函数的入参,该例子中只需要一个"locat