简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

有时候,我们会出现,虚拟机先删除了,然后才想起来rancher里还有个集群没删掉,这个时候,再通过rancher的界面去删除托管集群,往往会一直卡在“当前集群Removing中” 那么这种情况下,该如何处理呢?输入命令kubectl get clusters.management.cattle.io 就可以看到我们卡住的集群。1.点击待删除集群的名字,进入集群的详情页,复制URL中C/后面的字符,

为什么配置trunk:在linux下配置trunk的主要作用是服务器与交换机相连时,一个网卡上配置多个IP/VLAN ID来通信。这时就要用到trunk 了配置trunk:1、首先确认是否支持VLAN功能lsmod |grep 8021q2、配置物理网卡(物理网卡不配置IP)BOOTPROTO=noneDEVICE=eth0ONBOOT=yes3、临时配置vlanvconfig add eth01

descheduler当k8s将pod过多的调度到同一个worker节点会导致资源使用过高服务运行异常,可以使用descheduler对集群pod进行调度https://github.com/kubernetes-sigs/descheduler具体的部署方式详见github策略已实现的调度策略:RemoveDuplicates 移除重复 podLowNodeUtilization 节点低度使用R

k8s-nacos部署相关问题在github上查看nacos-k8s中的介绍如果使用外部mysql需要自己创建数据库和表(在release包中conf下的nacos-mysql.sql并非schema.sql)一、具体的文件如下`—apiVersion: v1kind: Servicemetadata:name: nacos-headlessnamespace: pro-nacoslabels:a

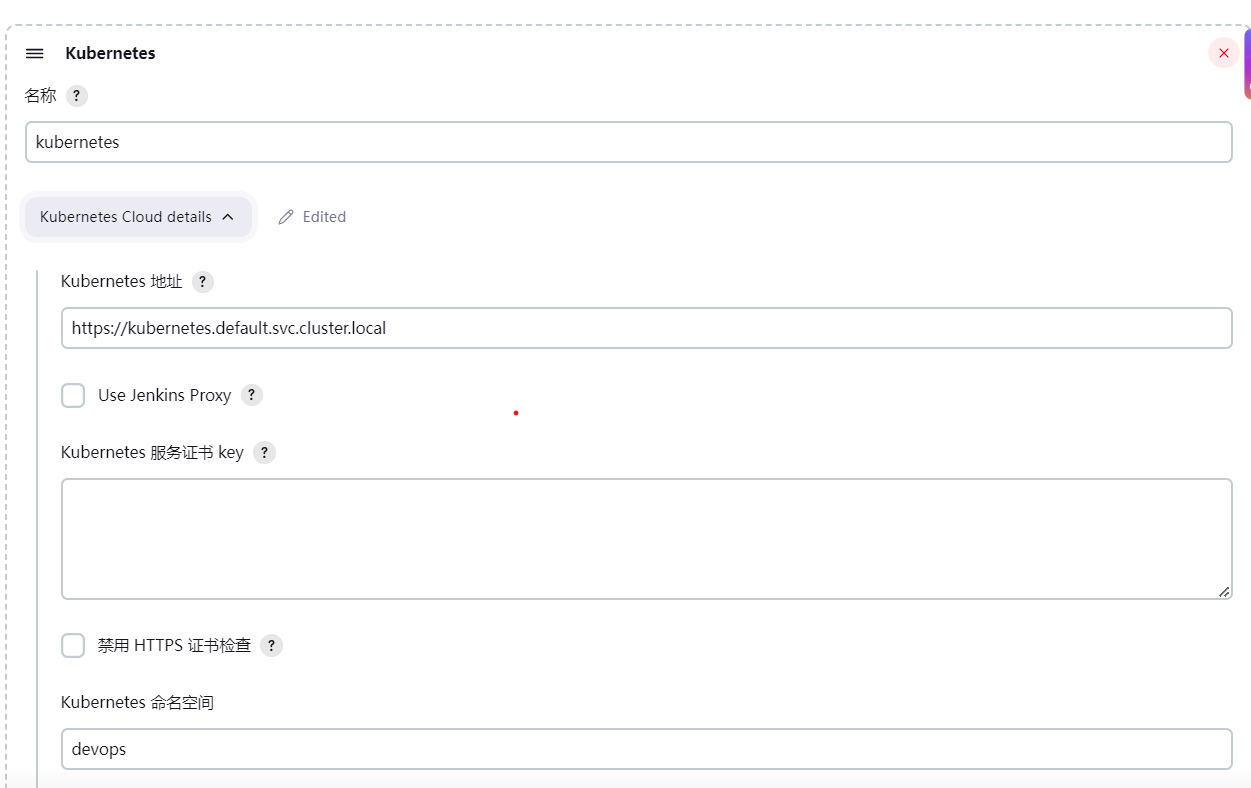

openssl pkcs12 -export -out cert.pfx -inkey client.key -in client.crt -certfile ca.crt(必须输入密码不然会jenkins验证报错)echo ‘certificate-authority-data-value’ | base64 -d > ./ca.crt(在kube_config中能找到对应的值)在tools中将

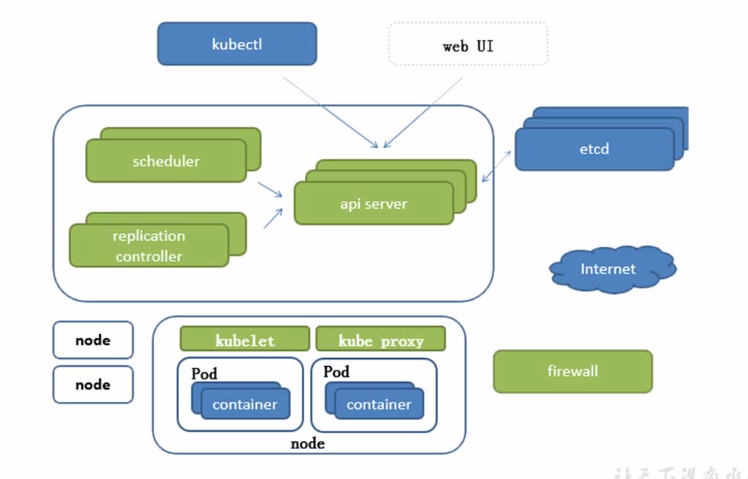

k8s架构图master:apiserver: 所有访问的入口replication controller:维持期望副本数scheduler: 调度任务到合适的节点etcd:存储有用的持久化信息worker:kebelet: 直接和容器引擎交互实现容器生命周期的管理kube proxy: 负责写入iptables实现服务映射访问(类似代理)coredns:为svc ip和域名的创建对应解析k8s集

Taints污点的组成使用kubectl taint命令可以给某个Node节点设置污点,Node被设置污点之后就和Pod之间存在一种相斥的关系,可以让Node拒绝Pod的调度执行,甚至将Node上已经存在的Pod驱逐出去。每个污点的组成如下:key=value:effect每个污点有一个key和value作为污点的标签,effect描述污点的作用。当前taint effect支持如下选项:NoSc

deploymentapiVersion: apps/v1kind: Deploymentmetadata:labels:app: {{ (datasource "config").name }}name: {{ (datasource "config").name }}namespace: {{ (datasource "config").namespace }}spec:replicas: {

apiVersion: v1kind: ConfigMapmetadata:name: filebeat-confignamespace: kube-systemlabels:k8s-app: filebeatdata:filebeat.yml: |-filebeat.config:# inputs:## Mounted filebeat-inputs configmap:#path: ${pat