简介

该用户还未填写简介

擅长的技术栈

未填写擅长的技术栈

可提供的服务

暂无可提供的服务

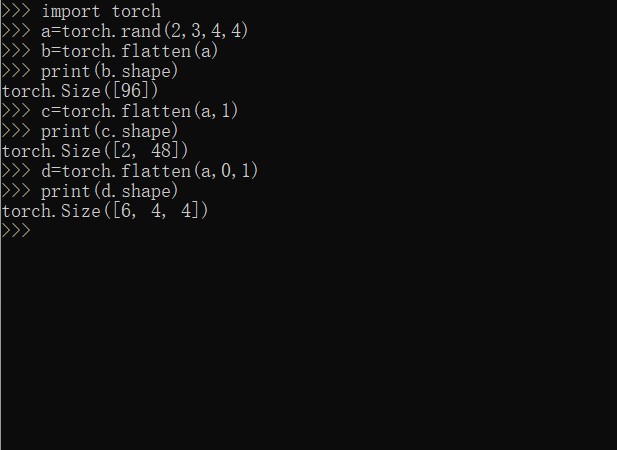

torch.flatten()函数

torch.flatten()函数讲解-个人总结

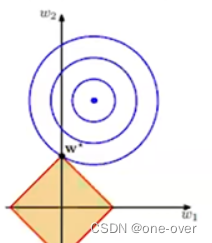

一文了解L1正则化与L2正则化

其中,L(w)是加了L2正则化的损失函数,Loss(y, y_pred)是模型的原始损失函数(例如,均方误差或交叉熵),w是模型的权重向量,||w||^2是权重向量的L2范数的平方,λ是正则化参数,用于控制正则化的强度。其中,L(w)是加了L1正则化的损失函数,Loss(y, y_pred)是模型的原始损失函数(例如,均方误差或交叉熵),w是模型的权重向量,||w||1是权重向量的L1范数,λ是正

torch.softmax()

是三维tensor的推广,其实三维tensor也可以是batchsize=1的四维tensor,只是dim的索引需要加1.:先随机生成一个(2,2,5,4)矩阵。其实随着dim增加(从0到3),相当于一层层剥开。:先随机生成一个(2,5,4)的矩阵,即两个维度的(5,4)矩阵。)对应位置(相同BHW)求softmax。)对应位置(相同BCW)求Softmax。)对应元素(相同BCH)求softma

到底了