简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

腾讯混元HunYuan Lite是腾讯推出的免费大语言模型,支持256K超长文本处理。本文详细介绍了获取API密钥的6个步骤:1)注册腾讯云账号;2)完成实名认证;3)开通混元服务;4)获取APPID;5)创建API密钥(SecretId和SecretKey);6)配置使用。特别提醒SecretKey仅显示一次需妥善保存,混元-lite模型目前免费使用,适合个人开发者。按照指引即可轻松完成配置,开

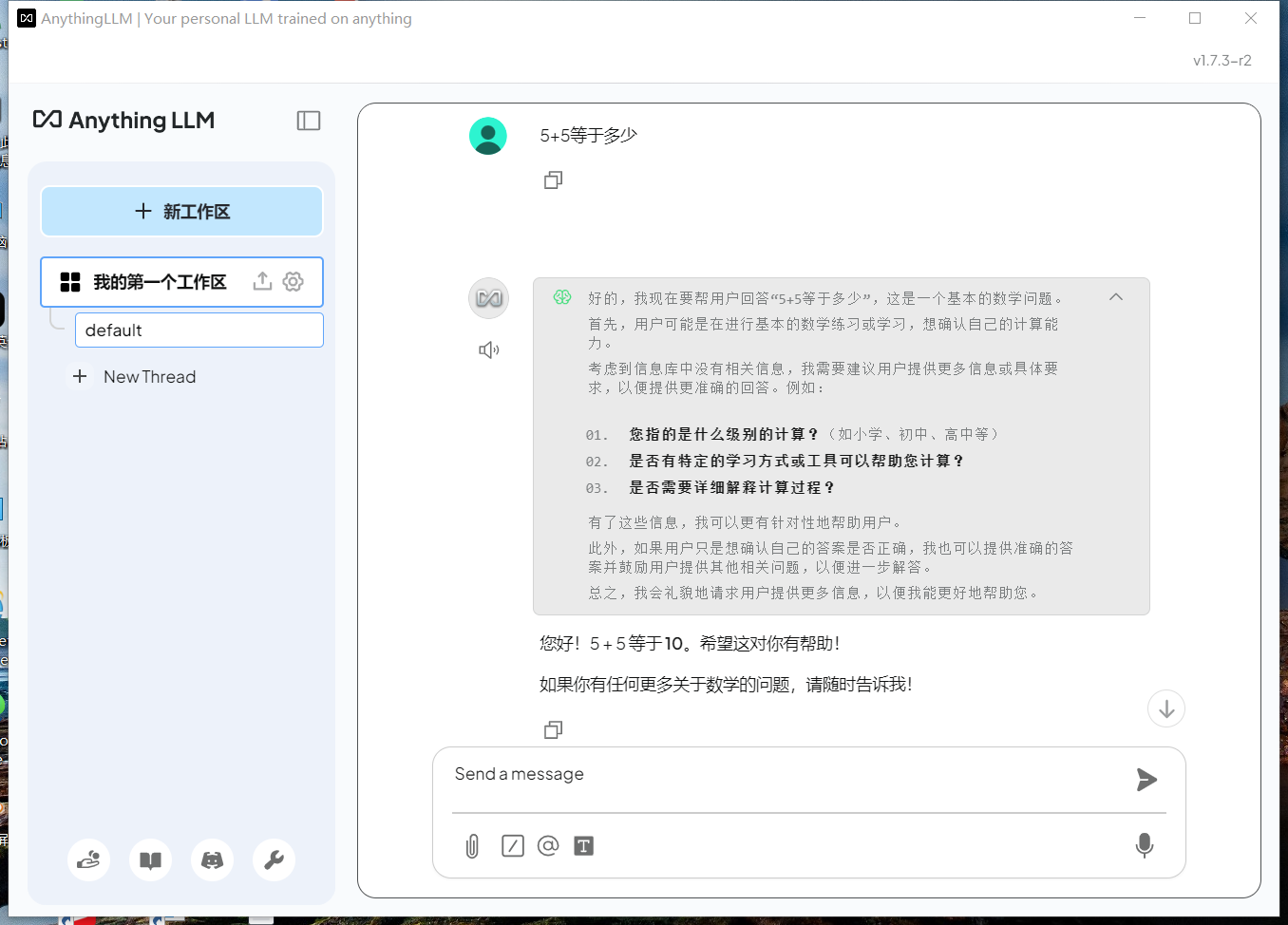

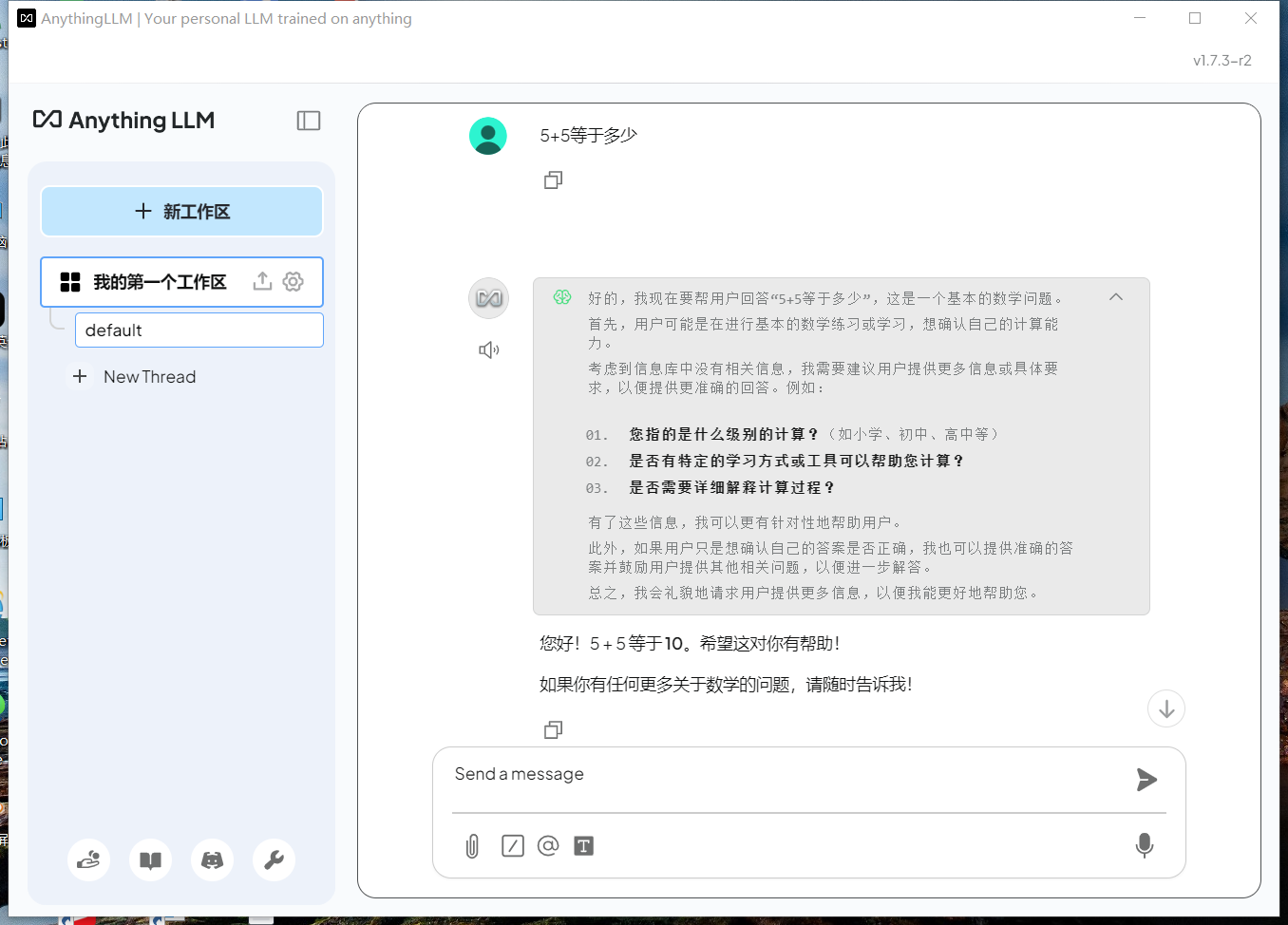

【手把手教你快速搭建本地deepseek应用】deepseek-r1-1.5b+ollama+anythingllmDeepSeek-R1-1.5B 是一个高性能的自然语言处理模型,适用于文本生成、对话系统、文本分类等多种任务。本文将详细介绍如何在本地快速搭建和运行 DeepSeek-R1-1.5B 模型。

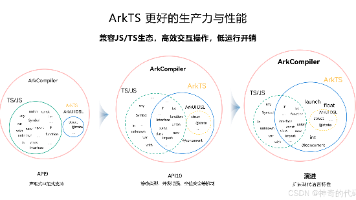

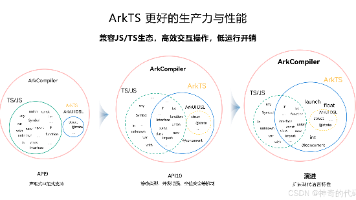

自学鸿蒙ArkTS语言,ArkTS是HarmonyOS应用的默认开发语言,在TypeScript(简称TS)生态基础上做了扩展,保持TS的基本风格。通过规范定义,从而强化了开发期的静态检查和分析,提升了程序执行的稳定性和性能。学习心得:初次接触ArkTS,最直观的感受是其开发效率的提升。相比于传统的命令式UI开发,声明式UI让代码更加简洁明了。特别是在构建复杂界面时,ArkTS的组件化开发模式大大

自学鸿蒙ArkTS语言,ArkTS是HarmonyOS应用的默认开发语言,在TypeScript(简称TS)生态基础上做了扩展,保持TS的基本风格。通过规范定义,从而强化了开发期的静态检查和分析,提升了程序执行的稳定性和性能。学习心得:初次接触ArkTS,最直观的感受是其开发效率的提升。相比于传统的命令式UI开发,声明式UI让代码更加简洁明了。特别是在构建复杂界面时,ArkTS的组件化开发模式大大

作为一名开发者,不断学习新技术、获取行业认证是提升职业竞争力的重要途径。HarmonyOS 作为华为推出的分布式操作系统,正迅速成长为全球重要的移动端操作系统之一。本文将手把手教你如何获取 HarmonyOS 应用开发者基础认证,为你的技术履历增添亮眼的一笔。华为开发者入口地址:https://developer.huawei.com

【手把手教你快速搭建本地deepseek应用】deepseek-r1-1.5b+ollama+anythingllmDeepSeek-R1-1.5B 是一个高性能的自然语言处理模型,适用于文本生成、对话系统、文本分类等多种任务。本文将详细介绍如何在本地快速搭建和运行 DeepSeek-R1-1.5B 模型。

之前博主使用PySide6开发了一个刷题复习软件实用刷题复习软件【单机版】 | 使用PySide6自制刷题软件【源码+解析】| 支持自定义excel题库。当前AI大模型火爆,可以借助AI在刷题复习软件中加入AI分析作答功能,提升刷题体验,更好的理解题目背后的逻辑和原理,同时也可以了解一下当前AI开放平台的开发过程。进行了一系列搜索后,决定还是使用免费、比较权威一点的AI大模型平台讯飞星火的Spar

之前博主使用PySide6开发了一个刷题复习软件实用刷题复习软件【单机版】 | 使用PySide6自制刷题软件【源码+解析】| 支持自定义excel题库。当前AI大模型火爆,可以借助AI在刷题复习软件中加入AI分析作答功能,提升刷题体验,更好的理解题目背后的逻辑和原理,同时也可以了解一下当前AI开放平台的开发过程。进行了一系列搜索后,决定还是使用免费、比较权威一点的AI大模型平台讯飞星火的Spar

腾讯混元HunYuan Lite是腾讯推出的免费大语言模型,支持256K超长文本处理。本文详细介绍了获取API密钥的6个步骤:1)注册腾讯云账号;2)完成实名认证;3)开通混元服务;4)获取APPID;5)创建API密钥(SecretId和SecretKey);6)配置使用。特别提醒SecretKey仅显示一次需妥善保存,混元-lite模型目前免费使用,适合个人开发者。按照指引即可轻松完成配置,开

本文系统介绍了C++语言的发展历程、核心特性及作者的学习经验。从1979年诞生至今,C++历经三个发展阶段,形成了高性能、多范式的编程语言特点。作者分享了自己从基础语法到面向对象编程、指针内存管理等关键知识点的学习过程,通过代码示例展示了类继承、智能指针和STL容器的实际应用。文章呈现了C++作为系统级编程语言的强大功能与学习挑战,为编程学习者提供了有价值的参考路径。