简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

本文综述了多智能体强化学习(MARL)在无人机控制领域的应用。首先介绍了强化学习的基本概念,包括单智能体强化学习(SARL)和多智能体强化学习(MARL)的区别,重点分析了MARL面临的挑战如信用分配问题、计算复杂度增加等。然后详细阐述了MARL的理论基础马尔可夫博弈,以及三类主要算法:基于价值、基于策略和演员-评论家方法。特别对基于价值的QMIX算法进行了深入解析,包括其集中式训练分散式执行的架

方面,随着深度强化学习理论和应用研究不断深入,其在游戏、机器人控制、对话系统、自动驾驶等领域发挥重要作用;另一方面,深度强化学习受到探索-利用困境、奖励稀疏、样本采集困难、稳定性较差等问题的限制,存在很多不足. 面对这些问题,研究者们提出各种各样的解决方法,新的理论进一步推动深度强化学习的发展,在弥补缺陷的同时扩展强化学习的研究领域,延伸出模仿学习、分层强化学习、元学习等新的研究方向. 文中从深度

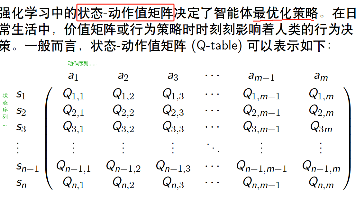

Q表格、Q网络与策略函数Q表格是有限的离散的,而神经网络可以是无限的。对于动作有限的智能体来说,使用Q网络获得当下状态的对于每个动作的状态-动作值。那么arg maxQas;θabest,那么我们对当前的状态s,会有一个最佳的选择abesta_{best}abest,选择的依据是策略θ\thetaθ. 我们的目标是获得最优的策略θ∗\theta^*θ∗.即优化θ\thetaθ。

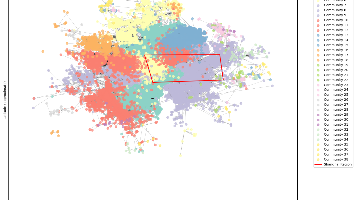

文章摘要 本文介绍共享单车数据分析的两个关键部分:站点流量统计和社区检测。首先通过3D柱状图可视化站点借还车频次,筛选特定区域数据展示地理分布。其次应用Louvain算法进行社区检测,包括数据预处理、图构建、社区分析和优化过程,最终识别出具有高内聚性的地理区域。文章详细展示了数据处理流程,包括孤立节点移除、异常数据处理,以及各阶段图结构的对比分析。完整代码见配套文件,实现了从原始数据到社区聚类可视

参考链接:https://blog.csdn.net/liweibin1994/article/details/79093453一、动态规划求Q和V我们的目标是要得到最优策略,使得累积回报函数最大。因此我们的强化学习的优化方法有两种:基于策略的优化(类似于上一篇chap2中的Q*(s,a)的优化)基于累积回报函数的优化(类似于上一篇chap2中V*(s)的优化)1.1 策略评估(迭代法)问题:评估

摘要:本文介绍了马尔可夫决策过程(MDP)在医疗决策中的应用,通过比较MDP与传统决策分析方法在活体肝移植最佳时机问题上的表现。研究表明,MDP不仅能更高效地求解最优策略(计算时间显著少于传统方法),还能处理序列决策中的不确定性。文章阐述了MDP的核心概念、求解方法(后向归纳法、价值迭代和策略迭代)及其在医疗领域的潜力,强调其在处理复杂临床决策问题时的优势。案例显示MDP与传统方法得出的最优移植策

摘要:本文介绍了马尔可夫决策过程(MDP)在医疗决策中的应用,通过比较MDP与传统决策分析方法在活体肝移植最佳时机问题上的表现。研究表明,MDP不仅能更高效地求解最优策略(计算时间显著少于传统方法),还能处理序列决策中的不确定性。文章阐述了MDP的核心概念、求解方法(后向归纳法、价值迭代和策略迭代)及其在医疗领域的潜力,强调其在处理复杂临床决策问题时的优势。案例显示MDP与传统方法得出的最优移植策

本手册是使用 Caltrans 绩效测量系统 (PeMS) 作为支持车道关闭活动的工具的综合指南。 它旨在成为 Caltrans 车道关闭工作人员(包括区域交通经理 (DTM) 和交通管理计划 (TMP) 工程师)进行关闭前设计阶段分析、实时监控车道关闭和评估拥堵情况的资源 以及关闭发生后的安全影响。 虽然本手册确实介绍了基本的 PeMS 报告和导航,但读者可以参考 PeMS 手册简介以更全面地概

[报错】 ‘numpy.float64’ object cannot be interpreted as an integer

数据结构分析与预处理一、原始数据结构shape:(时间点长度,节点个数,特征个数)1.1 案例示意选取6月20日早上8点到9点数据,网络的站点(网格划分)是5个,每个站点具有3个特征。8:00-8:05[ 特征1, 特征2,特征3]----节点1的特征[4,5,6]-----节点2的特征[7,8,9]-----节点3的特征[10,1