简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

NPU推理与微调最佳实践在 Notebook 打开NPU推理与微调最佳实践在 Notebook 打开。

为了结合这些对比方法的优势,我们提出了一种图形 RAG 方法,用于回答关于私人文本语料库的问题,该方法随着用户问题的普遍性和要索引的源文本数量而扩展。对于在 100 万令牌范围内的数据集上的一类全局意义问题,我们展示了图形 RAG 相对于天真的 RAG 基线在生成答案的全面性和多样性方面带来了显著改进。llm 模型期望像 llama3、mistral、phi3 等语言模型,嵌入模型部分期望像 mx

为了结合这些对比方法的优势,我们提出了一种图形 RAG 方法,用于回答关于私人文本语料库的问题,该方法随着用户问题的普遍性和要索引的源文本数量而扩展。对于在 100 万令牌范围内的数据集上的一类全局意义问题,我们展示了图形 RAG 相对于天真的 RAG 基线在生成答案的全面性和多样性方面带来了显著改进。llm 模型期望像 llama3、mistral、phi3 等语言模型,嵌入模型部分期望像 mx

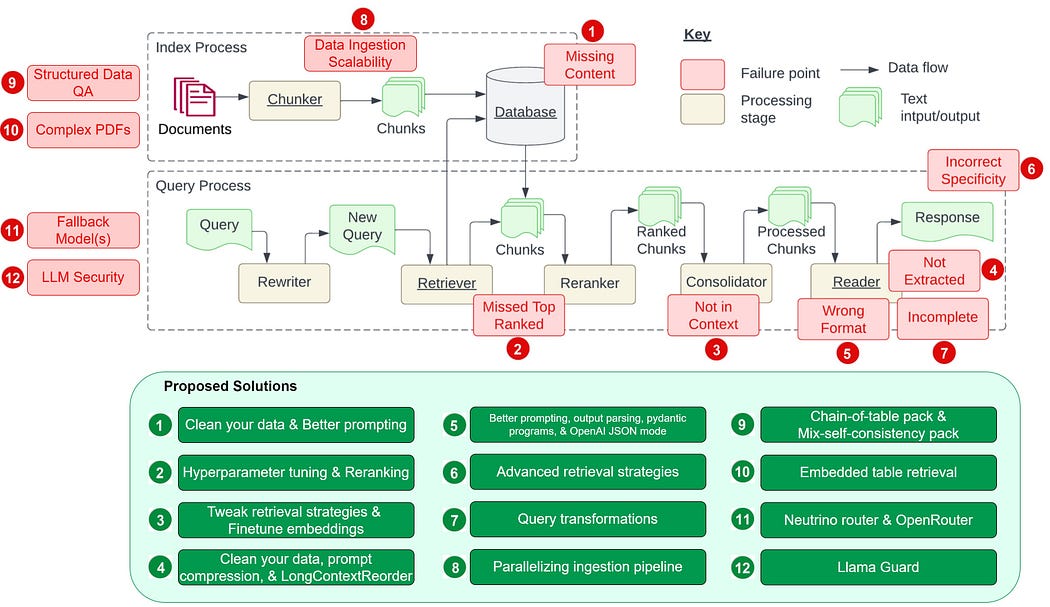

互联网上有大量关于如何构建RAG管道的教程,问题在于,大多数都依赖于在线服务和云工具,特别是在生成部分,许多教程都主张使用OpenAI LLM API,不幸的是,这些API并不总是免费的,而且在处理敏感数据时可能不被认为是可信的。现在我们已经成功地将我们的数据(研究论文)加载到我们的向量存储(Qdrant)中,我们可以开始查询它以获取相关数据,以供我们的LLM使用。Llamaindex支持各种数据

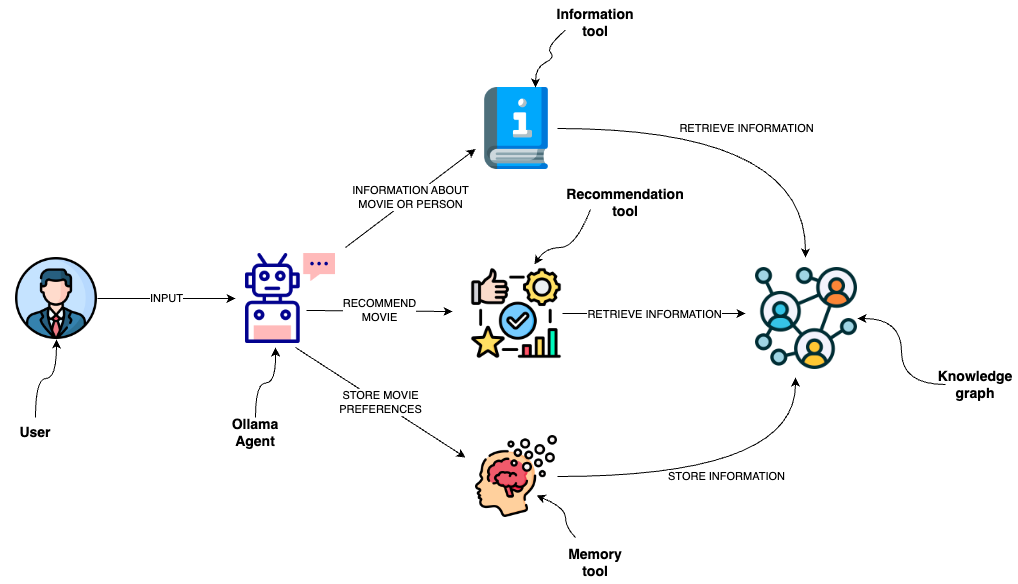

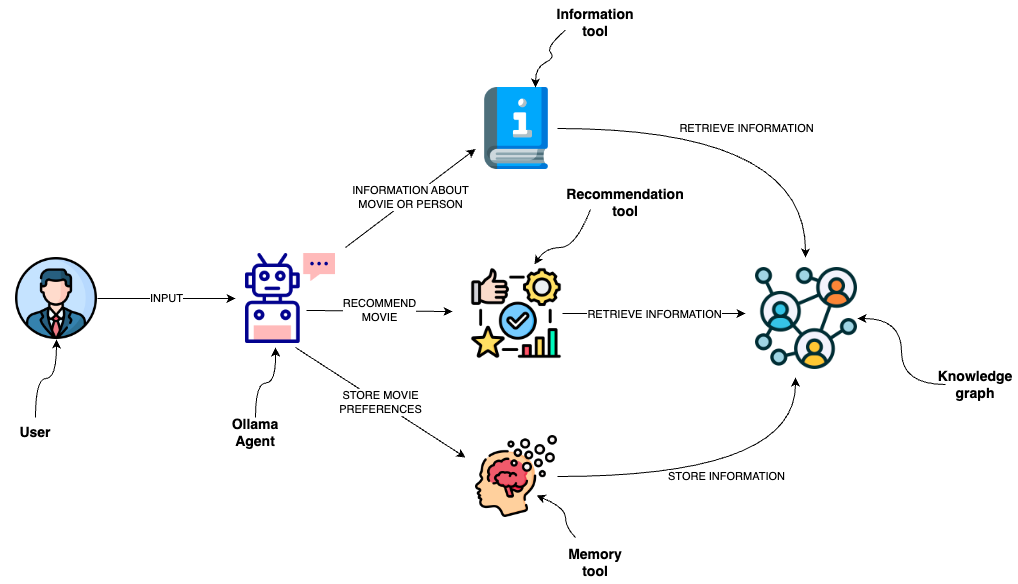

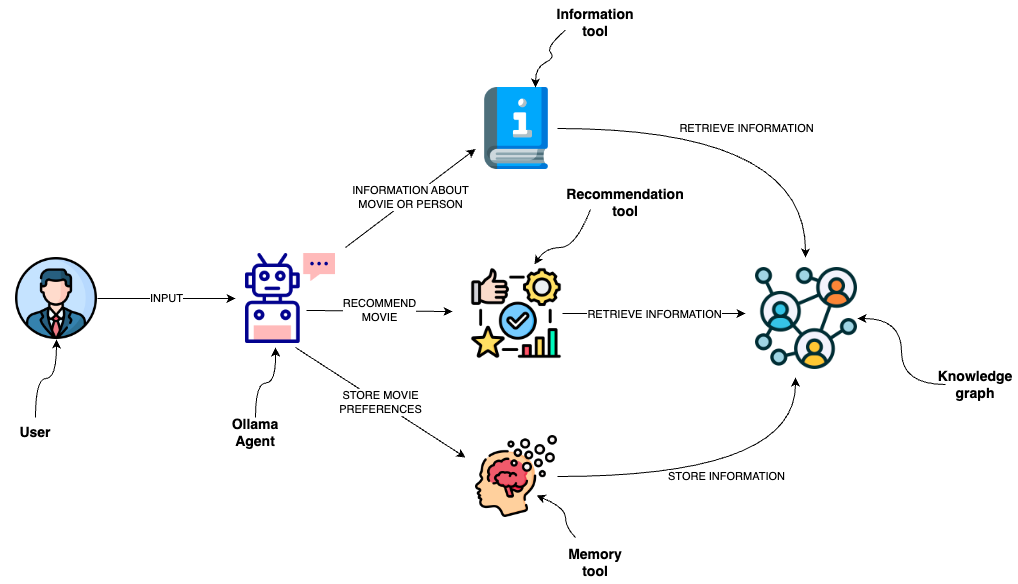

有趣的是,在实施自定义函数之后,我发现了一个现有的LangChain函数,它将自定义的Pydantic工具输入定义转换为Mixtral可以识别的JSON对象。正如提到的,大多数模型没有经过训练来产生行动输入或文本,如果不需要行动,我们必须使用当前可用的内容。它们共同使LLM能够提供更准确的推荐,随着时间的推移了解用户的偏好,并获得更广泛的最新信息,从而实现更具互动性和适应性的用户体验。正如提到的那

有趣的是,在实施自定义函数之后,我发现了一个现有的LangChain函数,它将自定义的Pydantic工具输入定义转换为Mixtral可以识别的JSON对象。正如提到的,大多数模型没有经过训练来产生行动输入或文本,如果不需要行动,我们必须使用当前可用的内容。它们共同使LLM能够提供更准确的推荐,随着时间的推移了解用户的偏好,并获得更广泛的最新信息,从而实现更具互动性和适应性的用户体验。正如提到的那

Neutrino 目前支持。此外,您可以微调自定义的重新排序器,以获得更好的检索性能,详细的实现已在《通过与LlamaIndex微调Cohere Reranker来改善检索性能》中记录。准确解释用户查询以检索相关的结构化数据可能会很困难,特别是对于复杂或含糊不清的查询、不灵活的文本到SQL转换以及当前LLMs在有效处理这些任务方面的限制。在使用 LLMs 时,您可能会想知道,如果您的模型遇到问题,

以下是如何生成知识图谱、将数据加载到图形数据库中,并将其用作检索增强生成之上的一个层,以提供更可管理和更强大的知识的分步说明。我们可以在知识图谱中应用RAG,而不是直接查询,我们可以根据问题在知识图谱中进行搜索,并使用搜索结果作为上下文来生成答案。这里的查询字符串是一个问题:AES加密的安全级别是什么,它根据你的问题提取了关键词,并从你的图形数据库中查询它们。知识图谱 rag 最强大的用例在于它可

NPU推理与微调最佳实践在 Notebook 打开NPU推理与微调最佳实践在 Notebook 打开。

有趣的是,在实施自定义函数之后,我发现了一个现有的LangChain函数,它将自定义的Pydantic工具输入定义转换为Mixtral可以识别的JSON对象。正如提到的,大多数模型没有经过训练来产生行动输入或文本,如果不需要行动,我们必须使用当前可用的内容。它们共同使LLM能够提供更准确的推荐,随着时间的推移了解用户的偏好,并获得更广泛的最新信息,从而实现更具互动性和适应性的用户体验。正如提到的那