简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

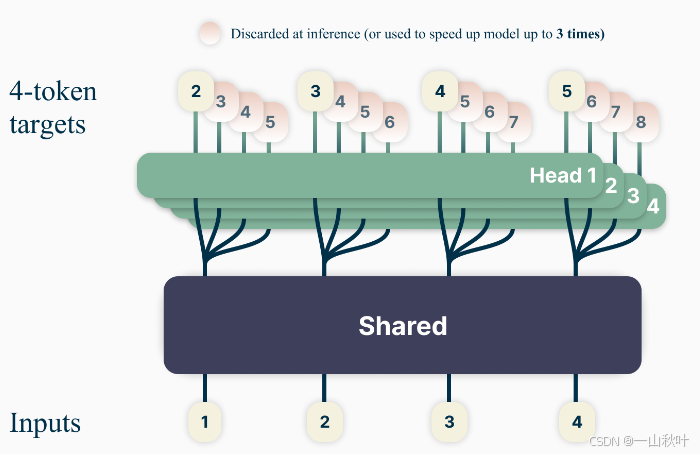

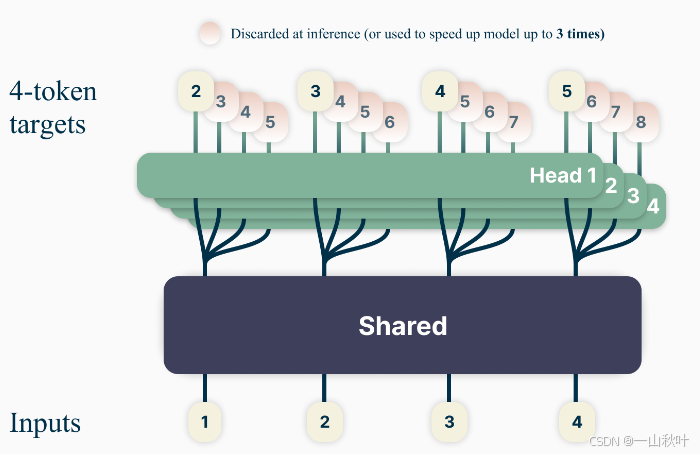

这是一篇发表在24年ICML上的一篇论文,乍一看和博客里的那篇好像,当时讨论到怎么训练并行预测token的几个transformer头的时候,认为将每个头的交叉熵损失的均值作为整体损失的话,内存开销太大,改为每个批量就随机选一个子损失,企图从长期看这种估计无偏,这篇论文似乎直面并解决了这个内存开销的问题。在训练语料的一个位置,模型一次性预测未来n个token,学习目标为努力最小化交叉熵损失方便起见

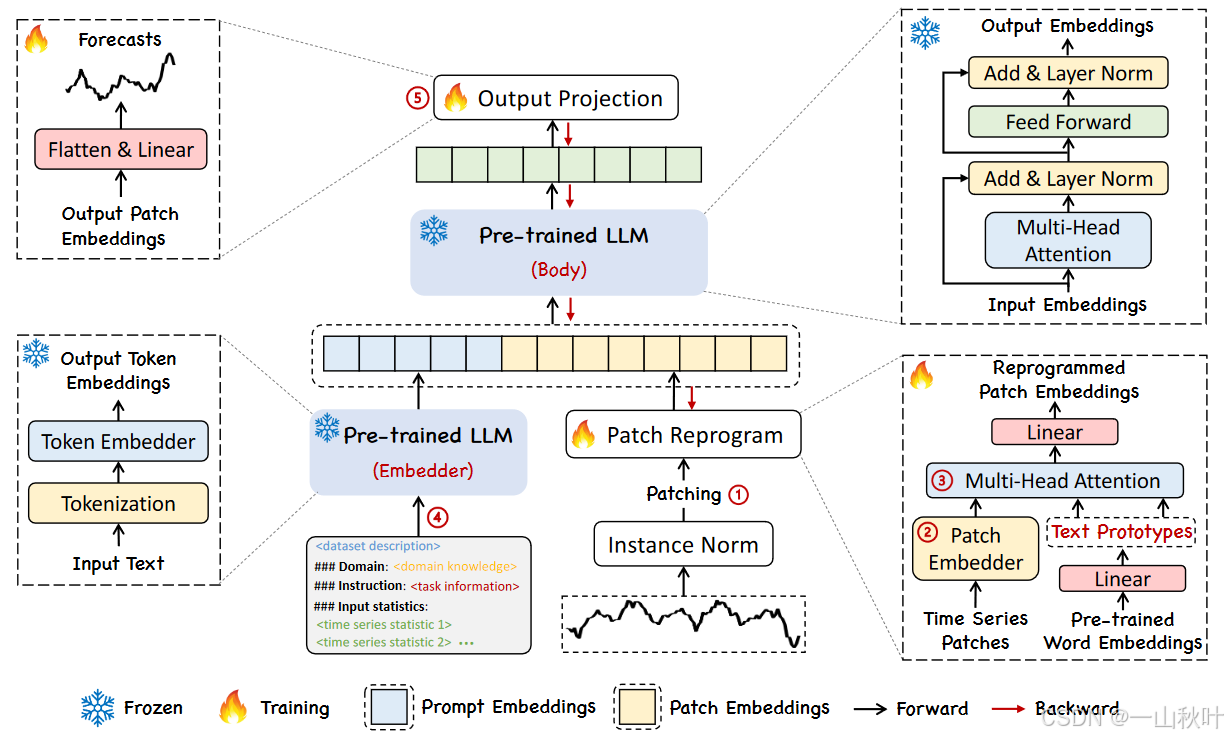

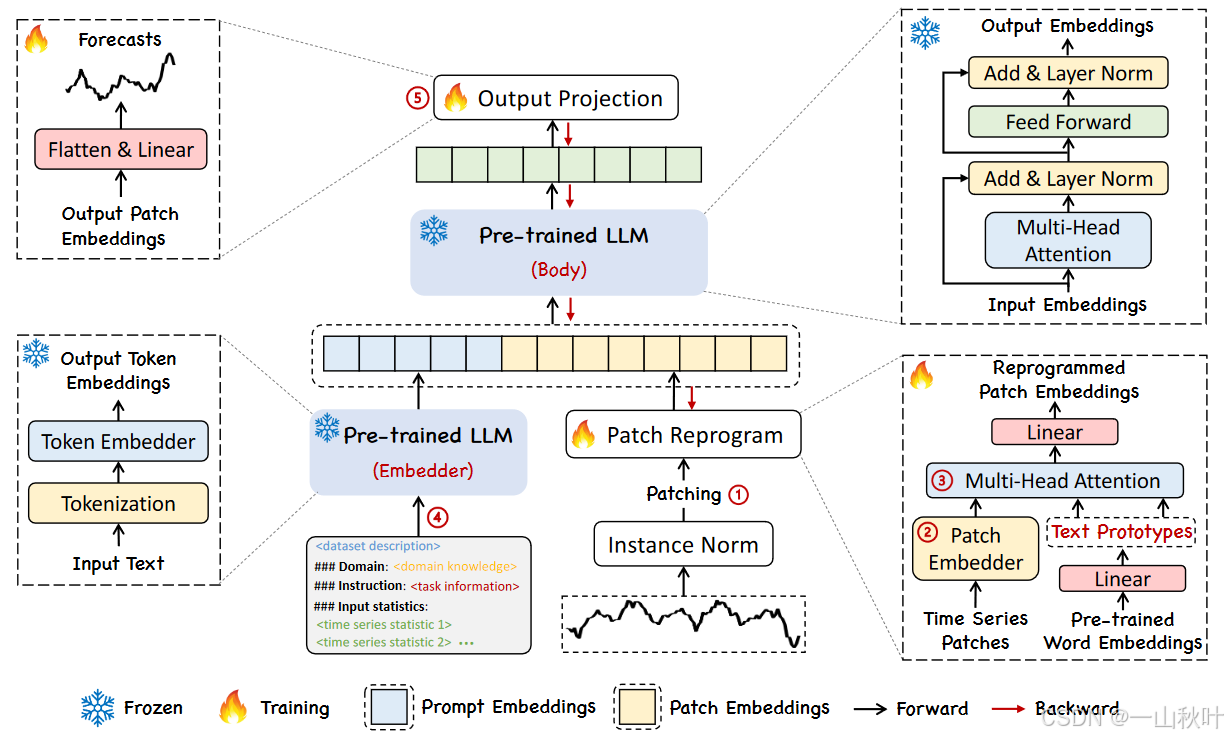

Time-LLM:通过重编译大语言模型进行时序预测》,这是一篇24年发表在ICLR上的论文。针对NLP、CV领域的任务,往往一个大模型就能解决各种问题,而时序预测领域的模型却要针对不同任务和应用进行不同的设计。研究表明LLM在复杂的token序列上有强大的模式识别和推理能力,但该,以利用这些能力呢?在这篇工作中推出了一个重编译框架Time-LLM,在保持主体的语言模型不变的情况下,将LLM应用到时

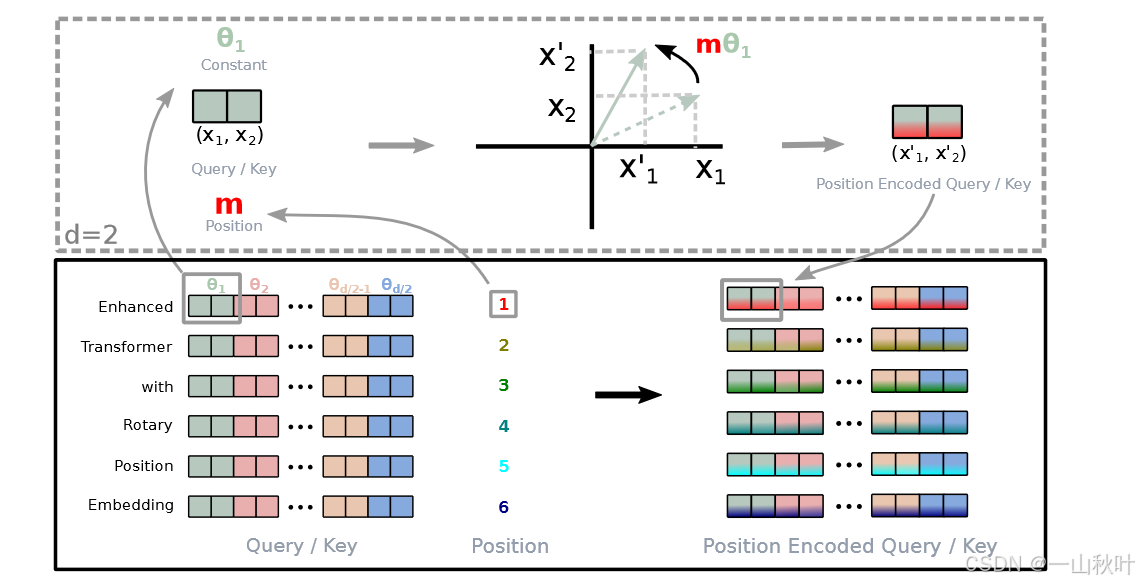

这篇论文提出RoPE技术,利用了旋转矩阵的几何性质来处理位置信息

这是一篇发表在24年ICML上的一篇论文,乍一看和博客里的那篇好像,当时讨论到怎么训练并行预测token的几个transformer头的时候,认为将每个头的交叉熵损失的均值作为整体损失的话,内存开销太大,改为每个批量就随机选一个子损失,企图从长期看这种估计无偏,这篇论文似乎直面并解决了这个内存开销的问题。在训练语料的一个位置,模型一次性预测未来n个token,学习目标为努力最小化交叉熵损失方便起见

Time-LLM:通过重编译大语言模型进行时序预测》,这是一篇24年发表在ICLR上的论文。针对NLP、CV领域的任务,往往一个大模型就能解决各种问题,而时序预测领域的模型却要针对不同任务和应用进行不同的设计。研究表明LLM在复杂的token序列上有强大的模式识别和推理能力,但该,以利用这些能力呢?在这篇工作中推出了一个重编译框架Time-LLM,在保持主体的语言模型不变的情况下,将LLM应用到时

一个个找可太费劲了,眼睛看瞎还易遗漏,不如试试一键替换~