简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

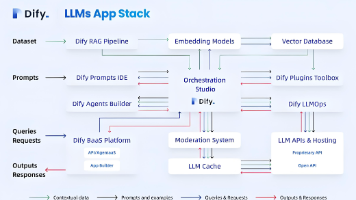

Dify凭借其完整的UI解决方案和无缝的集成能力而出众,而Langchain则以其简洁和专注的功能脱颖而出。这两个平台各自有独特的优势,能够满足AI应用开发的不同需求。

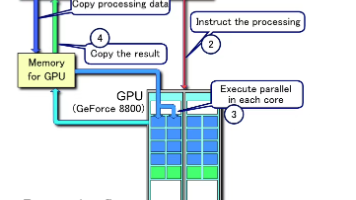

除了大众熟悉的中央处理器(CPU)外,神经网络处理器(NPU)、图形处理器(GPU)与张量处理器(TPU)也已加入处理器阵营。

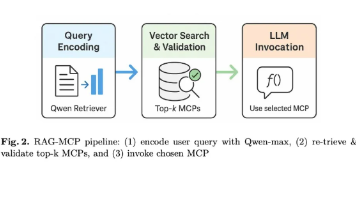

给 MCP(管理控制平台)集成 RAG,优先采用 “基础流水线 + 增强检索” 混合架构,核心是嵌入 “运维知识检索 + 故障案例匹配” 能力,解决 MCP 的运维问答、故障排查、配置咨询等场景痛点,且不侵入原有 MCP 核心控制逻辑。

Agent 的算力要求无固定标准,核心取决于其任务复杂度、依赖的大模型规模及主流框架的架构设计,从消费级 GPU 到企业级集群均可覆盖。这个问题切中了 Agent 落地的关键瓶颈,理解算力需求能帮你更合理地规划硬件或云资源投入。

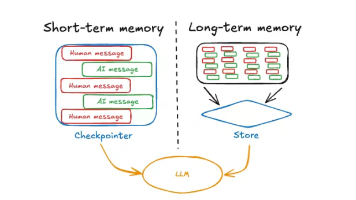

若需求是 “快速搭简单 LLM 应用”(如 RAG、单轮工具调用),直接用LangChain 1.0,开发快、复杂度低;若需求是 “构建复杂 Agent 系统”(多步骤、循环、多角色),用LangGraph 1.0,基于 LangChain 1.0 的组件,聚焦工作流编排,避免重复造轮子;实际开发中,二者常结合使用:用 LangChain 1.0 封装工具、模型、记忆模块,用 LangGraph

基于大语言模型(LLM)的智能体(Agent)系统中,记忆机制是实现持续、连贯和个性化交互的核心基石,通过记忆,可以让Agent记住过往的交互,保持上下文的一致性,并能从反馈中学习,适应用户的偏好。

在不影响画质的前提下优化 AI 短视频制作的算力,核心在于针对视频 “时间连续性” 的特性减少冗余计算,同时保持单帧画质与帧间连贯性。以下是结合视频生成特点的针对性策略:

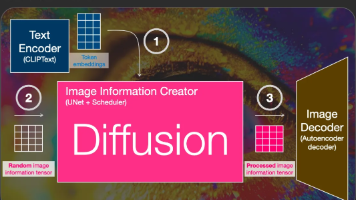

Stable Diffusion 的算力优化核心是,通过软件参数调整、硬件适配、模型优化三大方向,可显著降低显存占用、提升生成效率,无需盲目升级硬件。

随着生成式 AI 技术的快速发展,Stable Diffusion 已成为 AIGC 视频制作领域的核心技术平台。然而,视频生成相比静态图像对算力提出了更高要求,算力消耗与硬件成本成为制约技术普及的关键瓶颈。本研究旨在深入分析 Stable Diffusion 在短视频制作场景下的算力需求规律,系统评估不同硬件配置的性能表现,并提供针对性的优化策略,为企业和个人创作者的硬件投资决策提供科学依据。

MCP与其他大语言模型工具调用流程的核心不同在于:MCP是一个标准化协议层,而传统工具调用是模型与宿主应用的直接交互机制。传统工具调用像是直接操作自家打印机,而MCP则像是通过统一标准的外卖平台订购服务,省去了为每个工具单独开发适配器的复杂性。