简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

题目大意:有n棵树,m种颜料,要求现在要给这些树涂上颜料,最后涂成k段(连续颜色相同划为一段如2, 1, 1, 1, 3, 2, 2, 3, 1, 3是7段),有些树已经涂了,则不涂了只能涂一次,输入n个数(每个数为0~m),0表示还没有涂,1~m表示已经涂了哪种颜料。接下来输入n行m列,表示每棵树涂成每种颜色所要的颜料量。现在要把所有树都涂上颜料涂成k段,求最少要用的颜料量; 题解:看...

在linux中watch -n 0.5 -d nvidia-smi#每隔0.5秒刷新一次

介绍一个完完整整的,与我们实际使用一摸一样的多层感知机的反向传播方式多层感知机MLP & 反向传播2D函数优化实例

torch.cuda.empty_cache()写代码的好习惯是在程序最后执行以下这句话

LSTM——long short-term memoryLSTM能够解决梯度弥散的情况。LSTM还解决了记忆长度的问题以前RNN只能记住比较短的时间序列,LSTM就把短的short-term给你延长了,所以才叫long short-term memory我们之前学的RNN就是最基本的RNN版本,它也就是short-term memory我们换一种画法Wxh也叫Wih这就是原始的RNN的表达结构设计

之前那个多分类问题实战是手写了每个层其实我们可以使用nn.Linear,就不用手写了

Batch Size是一次训练所选取的样本数。Batch Size的大小影响模型的优化程度和速度。同时其直接影响到GPU内存的使用情况,假如你GPU内存不大,该数值最好设置小一点。epoch是训练轮数...

node物理节点,可以是一台机器也可以是一个容器,节点内部可以有多个GPU。rank & local_rank用于表示进程的编号/序号(在一些结构图中rank指的是软节点,rank可以看成一个计算单位),每一个进程对应了一个rank的进程,整个分布式由许多rank完成。local_rank: rank是指在整个分布式任务中进程的序号;local_rank是指在一个node上进程的相对序号,

LMDB 全称为 Lightning Memory-Mapped Database,就是非常快的内存映射型数据库,LMDB使用内存映射文件,可以提供更好的输入/输出性能,对于用于神经网络的大型数据集( 比如 ImageNet ),可以将其存储在 LMDB 中...

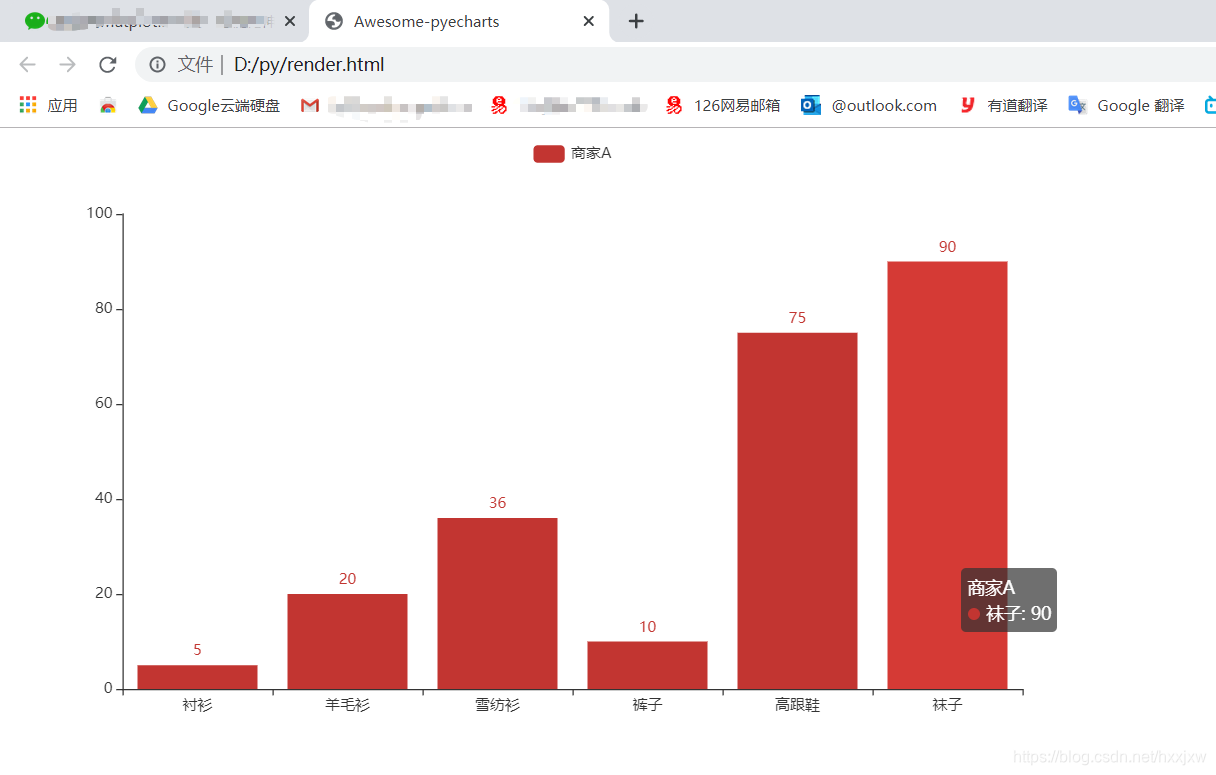

与基本的Matplotlib绘图相比,pyecharts的交互以及可视化更为友好,更适合于项目开发、商业报告。github.com/pyecharts/pyechartspyecharts 分为 v0.5.X 和 v1 两个大版本,v0.5.X 和 v1 间不兼容,v1 是一个全新的版本,很多函数的用法出现了变更第一个pyecharts程序bar.add_x/ya...