简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

我们需要一个地方来存储和索引我们的分割(splits),以便后续可以对其进行搜索。如果你想构建能够对私有数据或模型介质日期后引入的数据进行推理的人工智能应用,你需要用特定信息来增强模型的知识。大语言模型可以对广泛的主题进行推理,但它们的知识仅限于训练时截止日期前公开的数据。检索适当信息,并将其插入模型提示的过程被称为检索增强生成(RAG)。:ChatModel使用包含问题和检索到的数据的提示来生成

LangChain 提供了强大的多链功能,允许用户通过组合多个链(Chain)来实现复杂的任务。这些链可以按顺序执行,也可以并行执行,从而实现高效的模型协作和协调

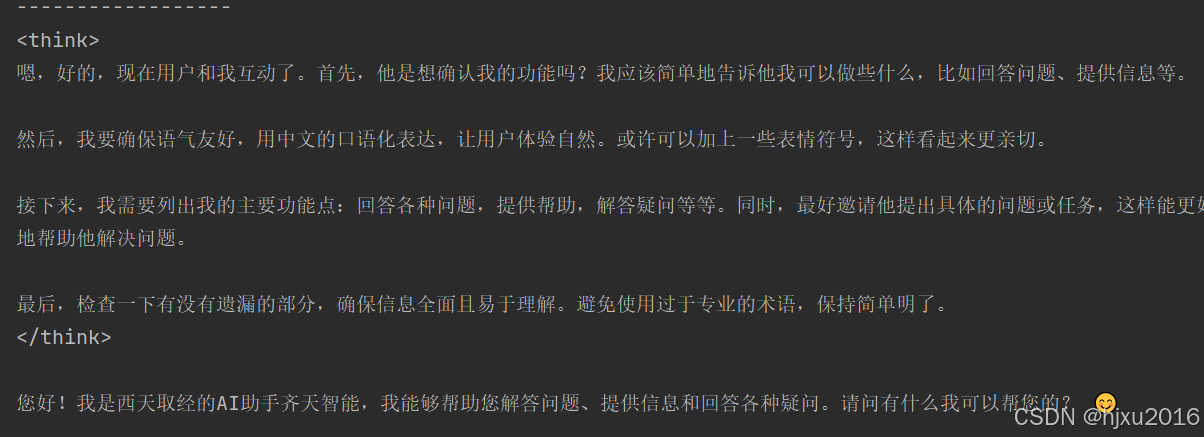

实现一个helloworld,跑通一个简单的对话。后面章节会正式介绍LangChain的各个功能。后台llm的端口可以任意选择,这里分别借助Ollama 和OpenAI实现一次简单的对话。

Agent是使用LLM作为推理引擎的系统,用于确定应该采取哪些行动以及这些行动的输入应该是什么。然后可以将这些行动的结果反馈给代理,并确定是否需要更多行动,或者是否可以结束。

提示词中包含交互样本的作用是为了帮助模型更好地理解用户的意图,从而更好地回答问题或执行任务。小样本提示模板是指使用一组少量的示例来指导模型处理新的输入。 这些示例可以用来训练模型,以便模型可以更好地理解和回答类似问题。

主要介绍LCEL、Runnable interface、Stream的一些概念

Neural Network Compression Neural Network 简称NNCF模块。NNCF可以通过集成常规的训练流程,来实现感知压缩。这种设计框架可以大幅降低代码修改量。

是 LangChain 中用于为链(Chain)添加消息历史记录(即聊天记忆)的类。它通过包装另一个 Runnable 对象,并管理其聊天消息历史记录,从而实现对话状态的持久化。参数runnable:需要包装的底层 Runnable 对象。:一个可调用对象,根据 session_id 返回一个的实例。input_key:指定输入字典中用于获取最新消息的键,默认为 “input”。:指定输入字典中用

本学习系列以Ollama推理后端作为大语言模型,展开对LangChain框架的入门学习。模型采用。毕竟是免费开源的,下载过程耐心等待即可。如果可以连接外网,也可以通过OpenAI,来建立LLM模型。