简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

本文介绍了如何利用Dify智能体和MCP工具构建基于数据库的查询问答系统。首先以PostgreSQL数据库为例,展示了从GitHub获取音乐商店示例数据并创建数据库的过程。然后详细说明了两种数据库结构描述方式:SQL格式和M-Schema规范。接着演示了如何使用fastmcp库构建安全的MCP查询服务,该服务通过安全校验后执行SQL查询。最后展示了在Dify中配置MCP服务并创建智能体工作流的完整

摘要:本文探讨了国产昇腾服务器部署大模型的精度测试问题。针对华为Mindie工具测试集有限且不支持vllm-ascend部署的问题,作者选择使用OpenCompass测试工具。由于企业服务器为Arm64架构且无法联网,作者在阿里云搭建Arm64云主机(成本<0.1元/小时),安装Docker并配置Python3.10环境,创建OpenCompass测试镜像。详细说明了测试流程,包括模型API

我搭建的深度学习的服务器中,配置了1块NVIDIA 1070Ti和1块2080Ti的显卡,系统是Ubuntu 16.04,通过NVIDIA-SMI命令查看,其中的1070Ti的风扇转速为0, 另一块的转速平时是26%,即使在GPU温度很高,例如到80度时,风扇转速仍然不超过75%,导致在做深度学习训练时,GPU温度一直降不下来。网上有很多资料关于如何用nvidia-settings来设置风扇转..

详细讲述了如何根据InstructGPT论文来实现一个奖励模型

本文介绍了阿里通义千问的多模态图像生成模型QwenImage系列(包括20B参数的Qwen-Image和7B参数的Qwen-Image-2.0),重点阐述了其MMDiT架构特点和文生图/图生图一体化能力。针对企业级部署需求,详细说明了在华为昇腾算力平台上的部署方案:采用Docker Compose整合QwenImage模型实例、Nginx负载均衡和安全检测服务(QwenGuard模型),并通过Fa

本文介绍了阿里通义千问的多模态图像生成模型QwenImage系列(包括20B参数的Qwen-Image和7B参数的Qwen-Image-2.0),重点阐述了其MMDiT架构特点和文生图/图生图一体化能力。针对企业级部署需求,详细说明了在华为昇腾算力平台上的部署方案:采用Docker Compose整合QwenImage模型实例、Nginx负载均衡和安全检测服务(QwenGuard模型),并通过Fa

本文介绍了阿里通义千问的多模态图像生成模型QwenImage系列(包括20B参数的Qwen-Image和7B参数的Qwen-Image-2.0),重点阐述了其MMDiT架构特点和文生图/图生图一体化能力。针对企业级部署需求,详细说明了在华为昇腾算力平台上的部署方案:采用Docker Compose整合QwenImage模型实例、Nginx负载均衡和安全检测服务(QwenGuard模型),并通过Fa

工作流可以实现业务流程的自动化,用户可以自己定义工作流程,通过流程来把常用的任务组织起来,而无需在程序中固化流程。这也符合当今微服务,低代码开发的趋势。Camunda是目前主流的一个工作流平台,遵循业界的标准(BPMN, DMN...),国内的很多低代码工作流平台也是基于Camunda来做进一步的定制开发的。Camunda目前有7和8两个版本,其中最新的8版本是采用SAAS的方式来提供服务,也可以

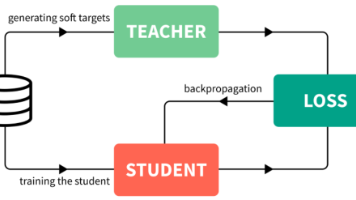

介绍了如何基于DeepSeek R1对Qwen进行蒸馏