简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

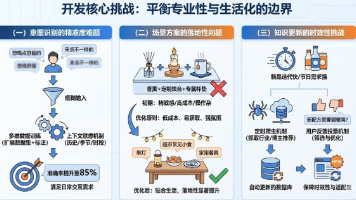

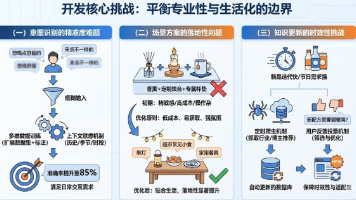

我们基于BERT模型进行微调,实现了“场景+口味”双维度的意图识别功能,能够精准提取用户输入中的关键信息,即使面对“冬天想喝杯热的,不要太甜”“加班后想喝点舒服的”这类模糊表述,也能快速捕捉核心需求。用户的输入往往充满模糊性与随机性,如“想喝点舒服的”“来点不一样的”这类表述,缺乏明确的关键词,单纯依靠字面意思难以精准判断需求。初期,我们设计的场景氛围布置方案过于追求“精致感”,如推荐“香薰+定制

我们基于BERT模型进行微调,实现了“场景+口味”双维度的意图识别功能,能够精准提取用户输入中的关键信息,即使面对“冬天想喝杯热的,不要太甜”“加班后想喝点舒服的”这类模糊表述,也能快速捕捉核心需求。用户的输入往往充满模糊性与随机性,如“想喝点舒服的”“来点不一样的”这类表述,缺乏明确的关键词,单纯依靠字面意思难以精准判断需求。初期,我们设计的场景氛围布置方案过于追求“精致感”,如推荐“香薰+定制

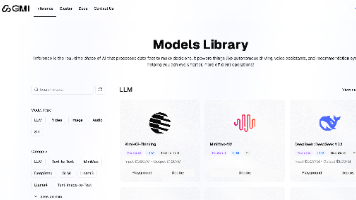

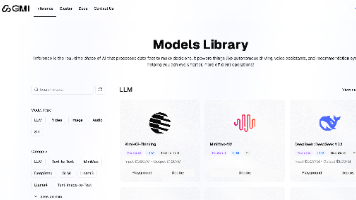

GMICloud作为新一代AI开发平台,通过统一API接口整合了97款主流AI模型,包括36款大语言模型和31款视频生成模型。平台采用H200/B200高性能GPU架构,提供标准化调用规范,开发者仅需单套认证凭证即可实现多模型无缝切换。其核心优势在于:1)开发效率提升,模型切换仅需修改参数;2)Token级精准计费,成本透明可控;3)前沿模型快速同步更新。实测显示,该平台可将模型推理延迟从150m

GMICloud作为新一代AI开发平台,通过统一API接口整合了97款主流AI模型,包括36款大语言模型和31款视频生成模型。平台采用H200/B200高性能GPU架构,提供标准化调用规范,开发者仅需单套认证凭证即可实现多模型无缝切换。其核心优势在于:1)开发效率提升,模型切换仅需修改参数;2)Token级精准计费,成本透明可控;3)前沿模型快速同步更新。实测显示,该平台可将模型推理延迟从150m

本文介绍了POSIX信号量在多线程同步中的应用。通过环形队列实现生产者-消费者模型,演示了信号量的初始化(sem_init)、销毁(sem_destroy)以及PV操作(sem_wait/sem_post)的使用方法。文章重点分析了单生产单消费场景下的并发控制,并扩展讨论多生产多消费时引入两把锁的解决方案,既保证线程安全又维持并发效率。最后通过代码实例展示了信号量在Linux环境下的具体应用。

文章通过图书馆钥匙管理的生动比喻,揭示了线程饥饿问题的成因,并详细讲解了pthread_cond_wait函数的两个关键特性:自动释放锁和重新竞争锁。在生产者消费者模型部分,作者提出了"321"原则(3种关系、2种角色、1个交易场所),并强调使用两个独立条件变量的必要性。通过阻塞队列的代码实现,展示了如何正确处理伪唤醒问题(使用while循环而非if判断)。最后,文章指出生产消费模型的高效性体现在

文章通过图书馆钥匙管理的生动比喻,揭示了线程饥饿问题的成因,并详细讲解了pthread_cond_wait函数的两个关键特性:自动释放锁和重新竞争锁。在生产者消费者模型部分,作者提出了"321"原则(3种关系、2种角色、1个交易场所),并强调使用两个独立条件变量的必要性。通过阻塞队列的代码实现,展示了如何正确处理伪唤醒问题(使用while循环而非if判断)。最后,文章指出生产消费模型的高效性体现在

本文深入探讨了Linux线程互斥机制及其底层实现原理。通过抢票Demo案例,分析了共享资源访问导致的数据不一致问题,提出临界资源与临界区的概念,解释了互斥锁如何通过原子性操作解决并发问题。文章详细介绍了互斥锁的初始化、加锁和解锁操作,阐述了RAII设计模式在锁封装中的应用,并对比了C++11原生mutex与pthread库的实现差异。最后,通过汇编层面分析++/--操作的非原子性,揭示了互斥锁的底

通过蓝耘平台搭建DeepSeek-R1模型

通过蓝耘平台搭建DeepSeek-R1模型