简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

在狄利克雷分布中,全 1 代表“完全无知”(Zero Evidence),而全 0 在数学上是未定义的(非法值)。证据与参数的关系:在证据深度学习(EDL)中,狄利克雷分布的参数α\alphaα与模型输出的“证据”eeeαkek1αkek1eke_kek(Evidence):模型在特征图中找到的支持第kkk类的证据量,必须≥0\ge 0≥0。完全无知状态:意味着模型什么证据都没找到,即ek0

MedGemma 1.5 (4B)是Google公司于2026年1月14日面向开发者的基础医疗多模态大模型(非临床诊断工具),本文对本地如何部署该模型进行详细说明,并开发了完整的web-UI界面方便使用,代码见下文,支持:1.纯文本问答2.单图提问3.多图连续追问。

第一章开篇介绍了人工智能 (AI) 和智能Agent的概念,并探讨了其在现代 AI 发展中的作用。1.1 AI Agent的崛起和发展Agent的定义:智能Agent是指能够感知环境、做出决策并采取行动以实现特定目标的系统。P12Agent范式的重要性:Agent范式是现代 AI 的基石,它推动着 AI 在各个领域的应用,例如对话助手、机器人和多智能体系统。LLM 时代的Agent。

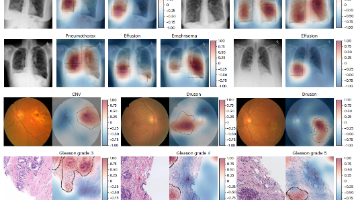

AFLoc:基于多模态对齐的医疗影像无监督病灶定位方法 摘要:Nature最新发表的AFLoc模型创新性地通过多层级语义对齐技术,实现了无需人工标注的医疗影像病灶定位。该模型将医学影像的局部特征与临床报告文本进行三级对齐(单词级、句子级、报告级),在胸部X光、眼底图像等多种模态上展现出卓越的跨场景泛化能力。实验证明,AFLoc不仅超越了现有自监督方法的定位精度,还能显著提升临床诊断效率(准确率+8

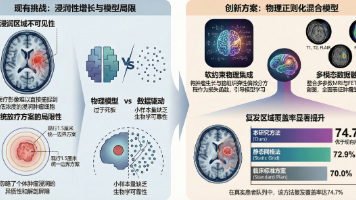

当 AI 掌握了物理规律,它就能穿透影像的迷雾,预见未来的复发风险。该方法不仅局限于脑肿瘤,还可以扩展到其他受刚性物理模型限制的现实世界问题中。目前,该项目的代码已在GitHub 开源,研究团队希望通过技术共享,加速这一工具向临床转化的进程。项目地址。

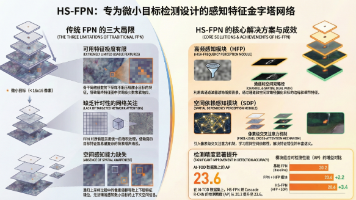

本文提出了一种名为HS-FPN的新型特征金字塔网络,用于解决微小目标检测中的特征匮乏和空间感知不足问题。该网络包含两个核心模块:高频感知模块(HFP)通过离散余弦变换滤除低频背景噪声,结合通道和空间注意力机制增强微小目标特征;空间依赖感知模块(SDP)采用跨注意力机制捕获像素级长程依赖关系。实验表明,HS-FPN能显著提升微小目标的信杂比,可作为插件模块集成到主流检测器中。作者还提供了关键模块的P

技术原理上,OWL 通过动态智能体交互实现高效的任务自动化,强调智能体之间的协作模式和通信协议,并基于 CAMEL-AI 框架开发,大语言模型(如 OpenAI 兼容模型)作为智能体的核心能力。实测一下,还是比较费Token的,而且如果遇到网站反爬之类的还会有问题,Manus没有用过没有发言权。至少对比了openManus和OWL,感觉这个是Agent的曙光,但是真的使用,速度慢,费用较高,还有很

发布背景:Gemma 3 是2025年3月12日谷歌在之前发布的 Gemma AI 模型基础上的升级之作,基于 Gemini 2.0 技术打造。模型规模:提供了四种不同尺寸的模型,分别是 1B、4B、12B 和 27B,以满足不同硬件性能的需求。

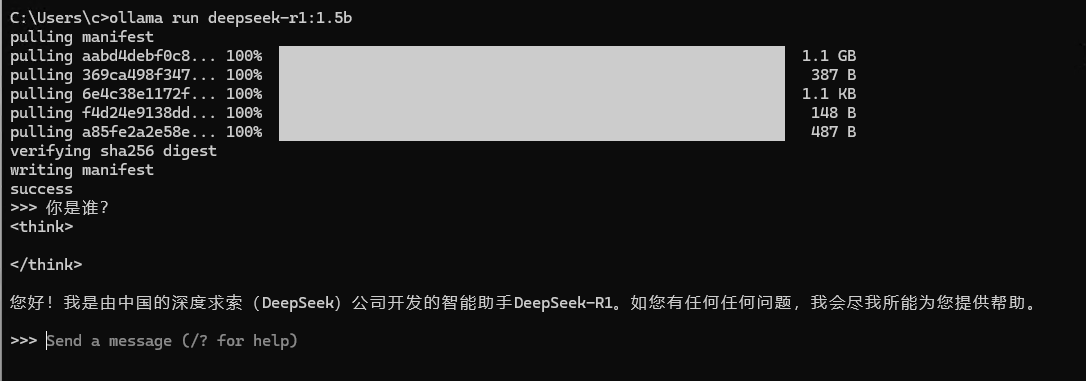

本文综合了网上的文章及本地自行实践踩坑的记录。

2025年3月4日由智谱发布的全网首个支持中文生成的开源模型CogView4开源地址https://github.com/THUDM/CogView4,CogView4遵循Apache 2.0协议,是首个以此协议开放的图像生成模型,为开发者提供了更灵活的使用空间,学生党做毕设再也不用跪求版权图。