简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

DeepseekR1大模型火了之后,我们专业AI应用开发者就用不上Deepseek了。。。接口天天崩,天天无法访问,这不闹嘛!然后同事就给推荐了硅基流动平台,我只想说:真香~~~~来看一下硅基流动平台的接口 文档:请求参数model,一眼看过去也快三十个了,挺好,有我们想用的R1大模型再研究下它的响应结构OK,通过字段获取思考内容。接下来开始扩展我们的,接上硅基流动平台,让小伙伴们可以用上它。

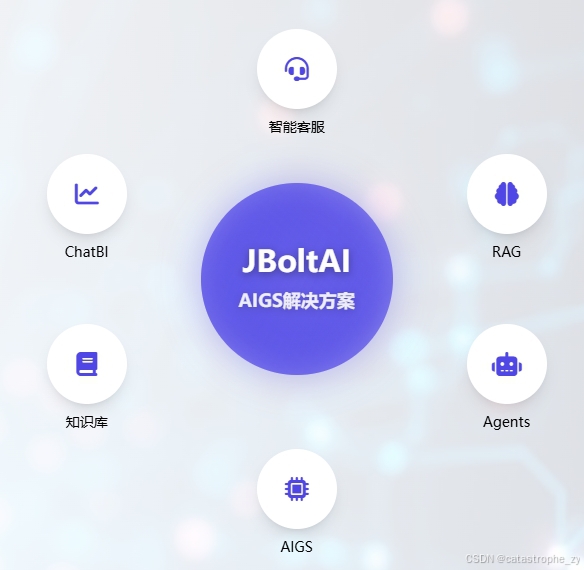

当然我们也可以控制事件的输出方式为非流式的,这一点,我们的JBoltAI 框架是非常灵活的,并且我们以统一的编码方式,让开发者可以非常容易的去使用近二十种主流的大模型、平台,开发者无需关心各个模型的参数差异,接口差异,无需更改代码就可以无缝切换不同的大模型。我们发起的AI聊天是以event事件的形式执行的,框架底层有一个事件调度器,会根据系统负载和ai资源的可用情况,自动分配资源给事件去执行。在上

DeepSeek、千问、Claude、OpenAI、Moonshot、硅基流动平台、Ollama、vLLM、百川、豆包、智谱清言、讯飞星火、文心大模型等等十多家主流厂商大模型支持,并且我们会一直跟随模型最新进展,不断对接新的大模型支持。AI Rewrite节点:让AI将你的问题重新加工一下,匹配到更精准的内容。:Vue3+NaiveUI打造的零代码编排界面,让AI应用开发像搭积木。AI Chat节

如果我们直接将Ollama的回复用于生产环境,肯定是不行的,对于不同的场景,前面输出的一堆内容,可能并不需要在客户端展示,对于用户体验来说,一个莫名其妙的标签包裹着一大堆文字,看起来也是不那么友好的。框架对于所有支持的大模型,都提供了统一的调用方式,不需要开发者关心底层逻辑,不需要关系不同大模型的接口差异和参数差异,极大的降低了开发者的开发难度。首先我们加载一下Ollama DeepSeek R1

最近大火的“深度思考”的模型——。它不仅能解数学题、写代码,甚至能像人类一样“一步步想问题”。这背后的技术到底是如何实现的?让我们用“煎饼果子”级别的比喻,剥开它的秘密!

maxToken(最大令牌数)是控制AI生成文本长度的核心参数。每个token约等于0.75个英文单词(中文约1-2个汉字)。.prompt("你了解JBoltAI这个Java 企业级 AI 数智化应用极速开发框架吗").setMaxTokens(2000) // <-- 这个就是魔法开关maxToken就像AI世界的交通警察,既要保证内容流畅通行,又要防止信息超载拥堵。掌握这个参数的开发者,才能

Temperature(温度参数)是控制AI生成文本随机性的关键参数,取值范围通常为0到1(部分模型支持更高)。低温度(接近0):AI变身严谨学霸,选择最可能的输出高温度(接近1):AI化身狂野艺术家,拥抱创造性随机。

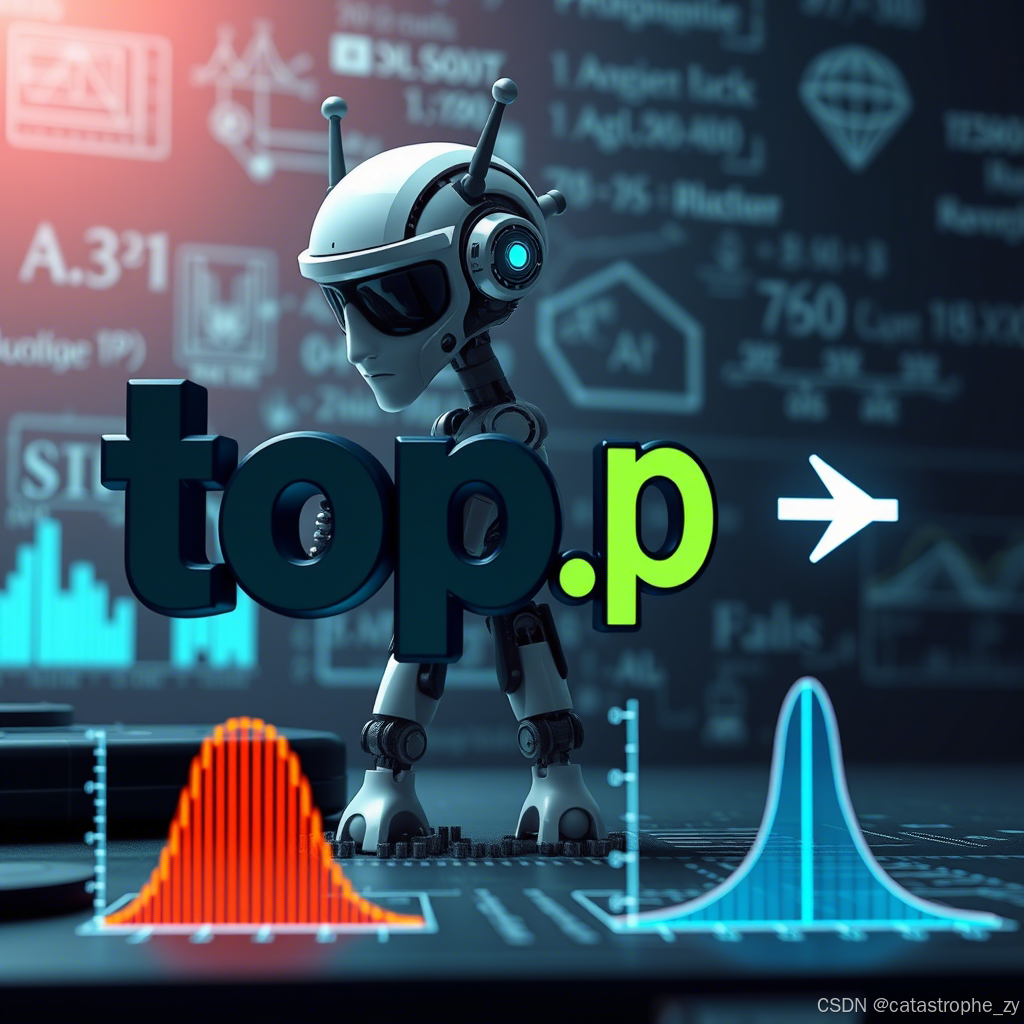

top_p参数(又称核采样/Nucleus Sampling)是控制AI生成文本多样性的关键参数,它像动态过滤器一样,决定每次预测时从多大范围的候选词中选择输出。其工作原理如下:每次生成token时,模型会输出所有可能词的概率分布。

maxToken(最大令牌数)是控制AI生成文本长度的核心参数。每个token约等于0.75个英文单词(中文约1-2个汉字)。.prompt("你了解JBoltAI这个Java 企业级 AI 数智化应用极速开发框架吗").setMaxTokens(2000) // <-- 这个就是魔法开关maxToken就像AI世界的交通警察,既要保证内容流畅通行,又要防止信息超载拥堵。掌握这个参数的开发者,才能

RAG, java,文档内容提取,OCR,word内容提取,excel内容提取,pdf内容提取