简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

《Cursor+ClaudeAI编程快速入门》课程简介 本课程系统讲解Cursor工具的使用,从基础安装到项目实战。重点介绍200K上下文窗口的技术原理与实用价值:1个token≈0.75个英文单词或2-3个中文字符,200K容量可处理约15-20万单词(相当于中型项目完整代码+文档)。课程包含Java/Python全栈项目实战(SpringBoot+Vue3/Flask+Vue3学生管理系统),

《Cursor+Claude AI编程快速入门》课程提供AI编程工具Cursor的全面教学,涵盖安装、模型选择到实战应用。课程重点讲解Cursor内置的8种AI模型(包括Auto模式、Opus4.6、GPT-5.2等)的特点与适用场景,指导学员根据任务复杂度选择合适的模型。通过两个实战项目(Java和Python版学生信息管理系统)演示AI编程流程,帮助学员1天内掌握基础技能。课程提供视频教程、课

《Cursor+Claude AI编程快速上手教程》介绍了一日速成课程,重点讲解Cursor工具的四大核心功能:Agent(智能开发助手)、Plan(项目规划)、Debug(错误诊断)和Ask(快速问答)。课程包含从安装到实战的全流程,通过SpringBoot和Flask两个学生管理系统项目演示AI编程应用。教学资料包含视频教程、课件和源码(百度网盘提取码1234)。课程后续将推出高级实战内容,帮

《Cursor+ClaudeAI编程1天快速上手》课程简介:本课程系统讲解智能代码编辑器Cursor的核心功能与应用,包括安装配置、模型会话、代码生成与调试等操作。重点演示如何利用Cursor Opus4.6快速开发Java/Python全栈项目(SpringBoot4/Vue3和Flask2/Vue3学生管理系统)。课程提供视频教程+课件+源码下载(百度网盘提取码1234),帮助开发者在1天内掌

摘要:本项目开发了一个基于Python的房屋数据分析预测系统,采用scikit-learn机器学习库构建预测模型,并通过Flask框架提供Web交互界面。系统支持从房屋销售数据中提取特征(如面积、位置等),运用多种算法(线性回归、随机森林等)进行训练和优化,最终通过可视化图表展示房价预测结果及影响因素分析。该系统为购房者和投资者提供科学决策支持,包含完整源码下载链接。

本教程详细介绍了基于BERT大模型的微博舆情分析系统开发过程。主要内容包括:1)使用8000条训练数据和2000条测试数据构建自定义数据集;2)通过BERT分词器对文本进行编码处理;3)在BERT模型基础上添加全连接层实现二分类任务;4)采用3轮训练微调模型,准确率从78%提升至92%;5)将训练好的模型封装成接口,替换原有snowNLP分析模块;6)优化批量处理逻辑提高系统响应速度。实验表明,基

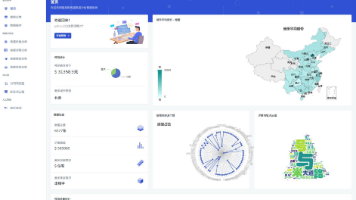

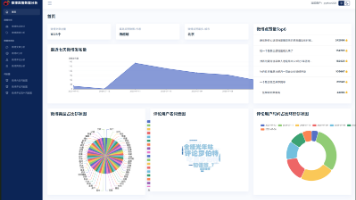

锋哥写一套【NLP舆情分析】基于python微博舆情分析可视化系统(flask+pandas+echarts) 视频教程,帅呆了~~

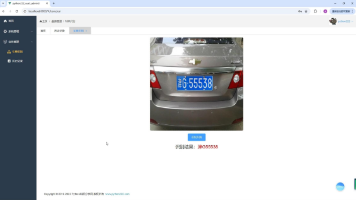

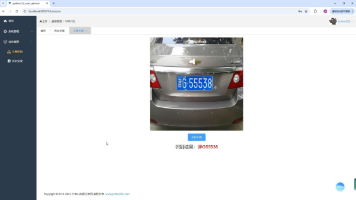

基于Python深度学习的车辆车牌识别系统(PyTorch2卷积神经网络CNN+OpenCV4实现)视频教程 - 验证检测到的矩阵是否符合车牌尺寸比例和面积特征

基于Python深度学习的车辆车牌识别系统(PyTorch2卷积神经网络CNN+OpenCV4实现)视频教程 - 图像预处理

本课程介绍如何基于HuggingFace Transformers进行GPT-2中文模型的全量微调训练。使用60万条对联数据集,通过自定义Dataset类加载数据,利用AutoTokenizer进行文本编码。采用AutoModelForCausalLM加载预训练模型,在3轮训练中优化模型参数,实现对联生成功能。训练过程中监控损失和准确率,每1000批次保存模型权重。测试结果显示模型已初步具备对联生