简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

ROS(Robot Operating System)是一个专为机器人开发设计的开源中间件框架,旨在简化机器人系统开发。其核心包括:roscore(通信中枢)、节点(功能单元)、功能包(代码组织)、话题(异步通信)、服务(同步通信)等组件。ROS采用模块化设计,支持跨语言、跨设备交互,提供传感器驱动、路径规划等常用功能封装。开发流程通常从启动roscore开始,通过rosrun或roslaunch

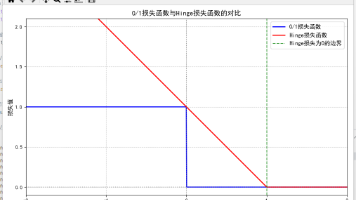

0/1 损失是 “理想但不可用” 的损失函数 —— 其非凸、非连续的特性导致无法高效优化,且不区分置信度的设计与 SVM “最大化间隔” 的目标完全冲突。而 Hinge 等替代损失函数,通过凸性 + 连续性解决了优化难题,通过 **“低置信度惩罚”** 精准匹配了 SVM 的间隔目标,最终成为 SVM 的核心损失函数。这一选择本质是 “任务目标(最大化间隔)” 与 “优化可行性” 权衡后的最优结果

要理解深度学习中的优化器,核心是从 “如何高效更新模型参数以最小化损失” 这一问题出发,按 “基础→改进→融合” 的逻辑梳理。以下从最简单的优化器开始,逐步深入复杂方案,每个优化器均包含,帮助清晰理解演进脉络。

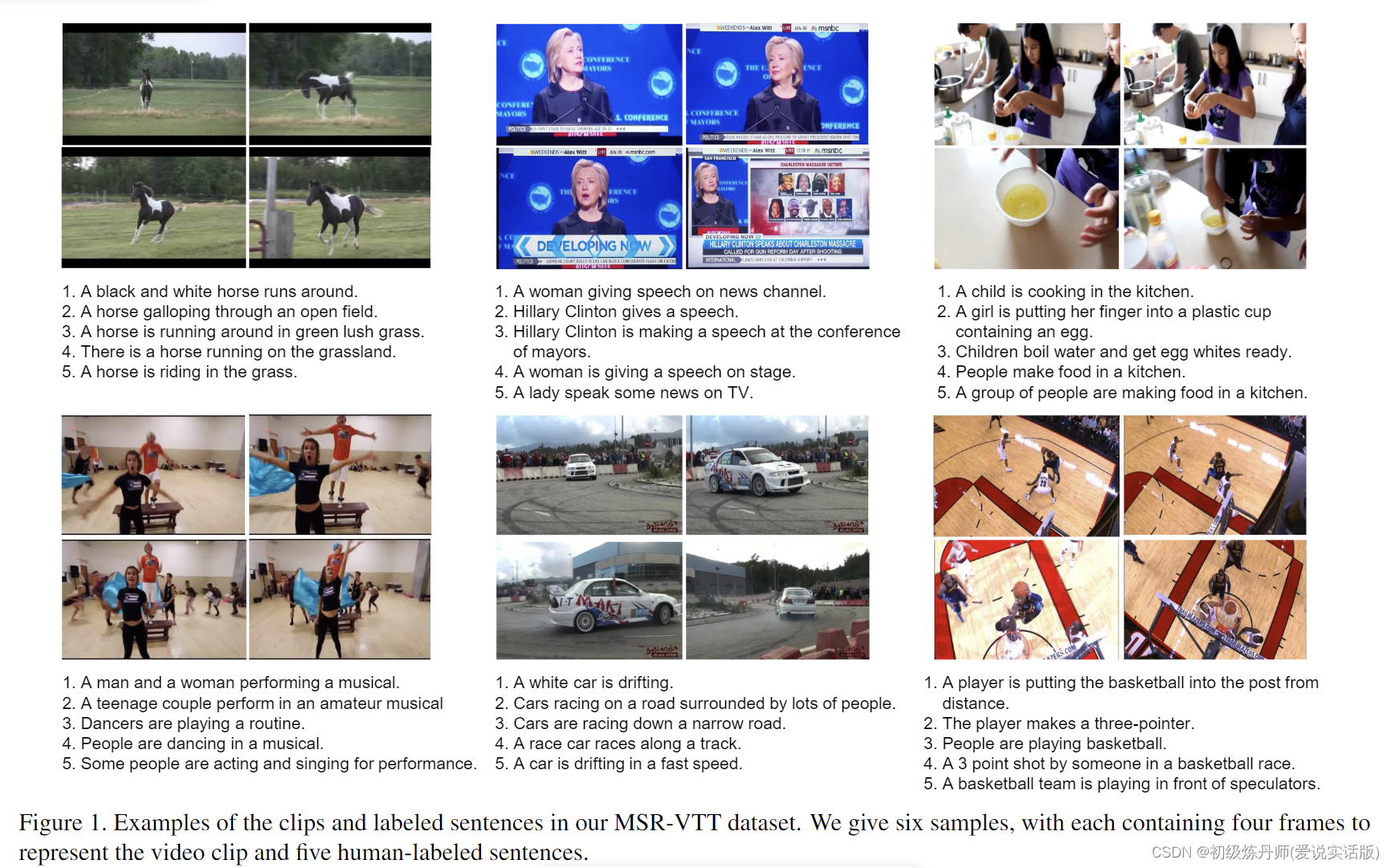

虽然人们对用自然语言描述视频的任务越来越感兴趣,但目前的计算机视觉算法在视频及其可以识别的相关语言的可变性和复杂性方面仍然受到严重限制。这在一定程度上是由于当前基准测试的简单性,这些基准测试主要集中在特定的细粒度领域,具有有限的视频和简单的描述。虽然研究人员已经为图像字幕提供了几个基准数据集,但我们不知道有任何大规模的视频描述数据集具有全面的类别和多样化的视频内容。在本文中,我们提出了MSR-VT

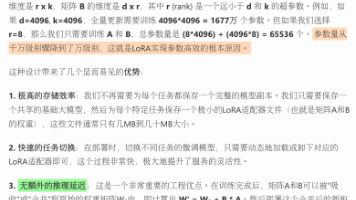

一、Prompt 工程(Prompt Engineering)Prompt 工程是通过设计输入文本(Prompt)的形式,引导大模型在不修改参数的情况下,更好地理解任务需求并输出符合预期的结果。核心是 “用自然语言指令或示例‘激活’模型的固有能力”,无需训练,属于 “零样本 / 少样本学习” 范畴。用人类可理解的文本形式,为大模型提供 “任务锚点”,激活其预训练知识,约束其生成逻辑,最终弥合 “模

指令微调是连接 “通用预训练模型” 与 “实用化应用” 的关键桥梁 —— 它通过 “指令 - 响应” 数据的监督学习,让模型从 “被动续写” 转变为 “主动响应人类需求”,是目前大语言模型落地(如企业定制化模型、垂直领域 AI 助手)的核心技术之一。没有指令微调,预训练模型的强大能力难以转化为对人类有用的实际价值。

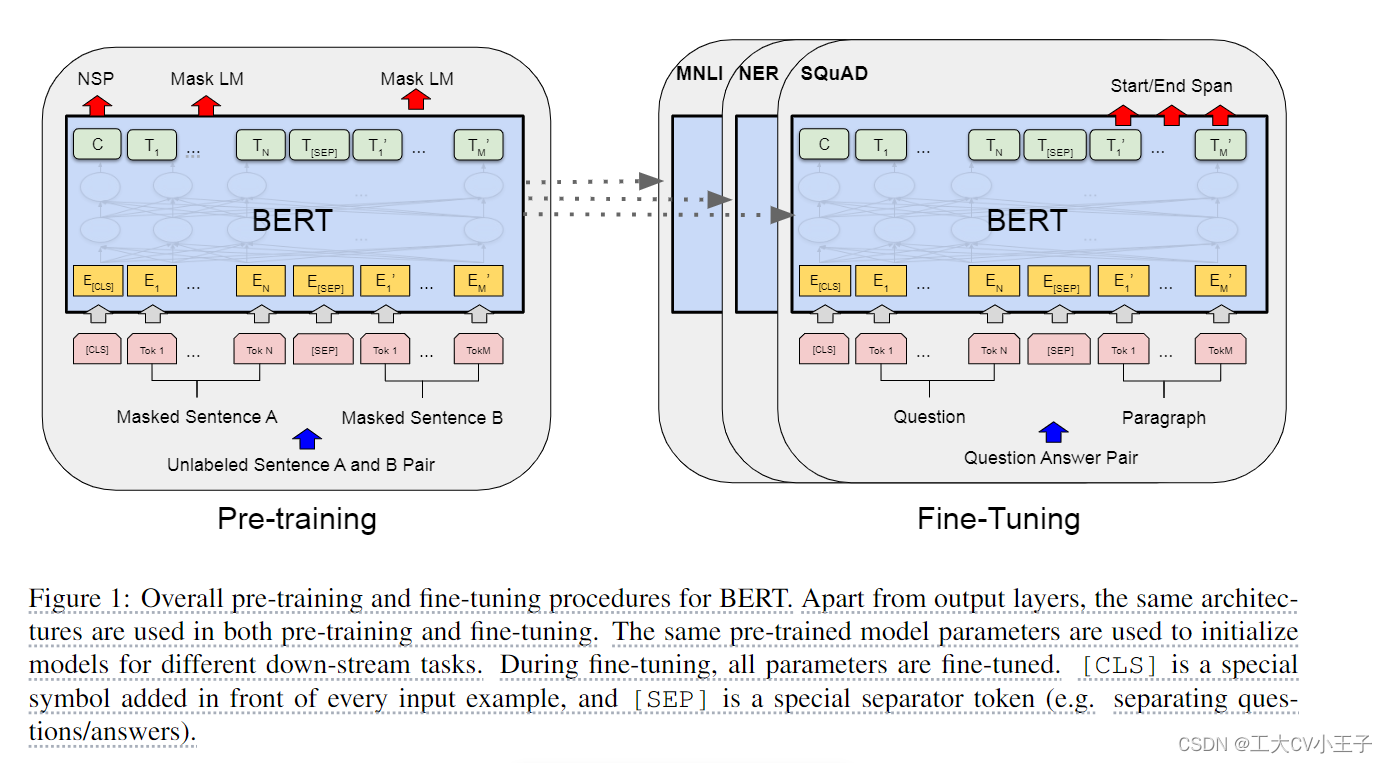

我们引入了一种新的语言表示模型 BERT,它代表来自 Transformer 的双向编码器表示。与最近的语言表示模型 (Peters et al., 2018aElmo;GPT) 不同,BERT 旨在通过联合考虑所有层中的左右上下文来从未标记文本中预训练深度双向表示。(这句话是针对GPT而说的)因此,预训练的 BERT 模型只需一个额外的输出层就可以进行微调,为各种任务(例如问答和语言推理)创建最

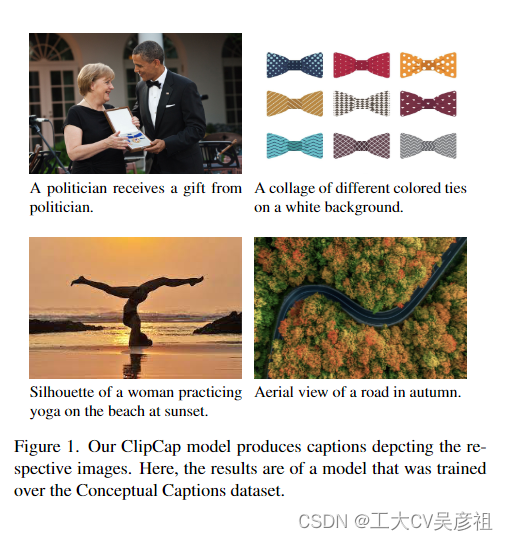

mapper/mapper输出的带prefix的序列 就是做一个CLIP和GPT2的桥梁,如果是训练时不冻结decoder则decoeder和mapper都适应clip,效果自然好,这会儿用mlp或者tansformer结构的mapper都可以,但是作者又通过实验证明:我们得出结论,当采用语言模型的微调时,转换器体系结构的表达能力是不必要的。;如果decoder冻结,mapper就完全当一个转接器

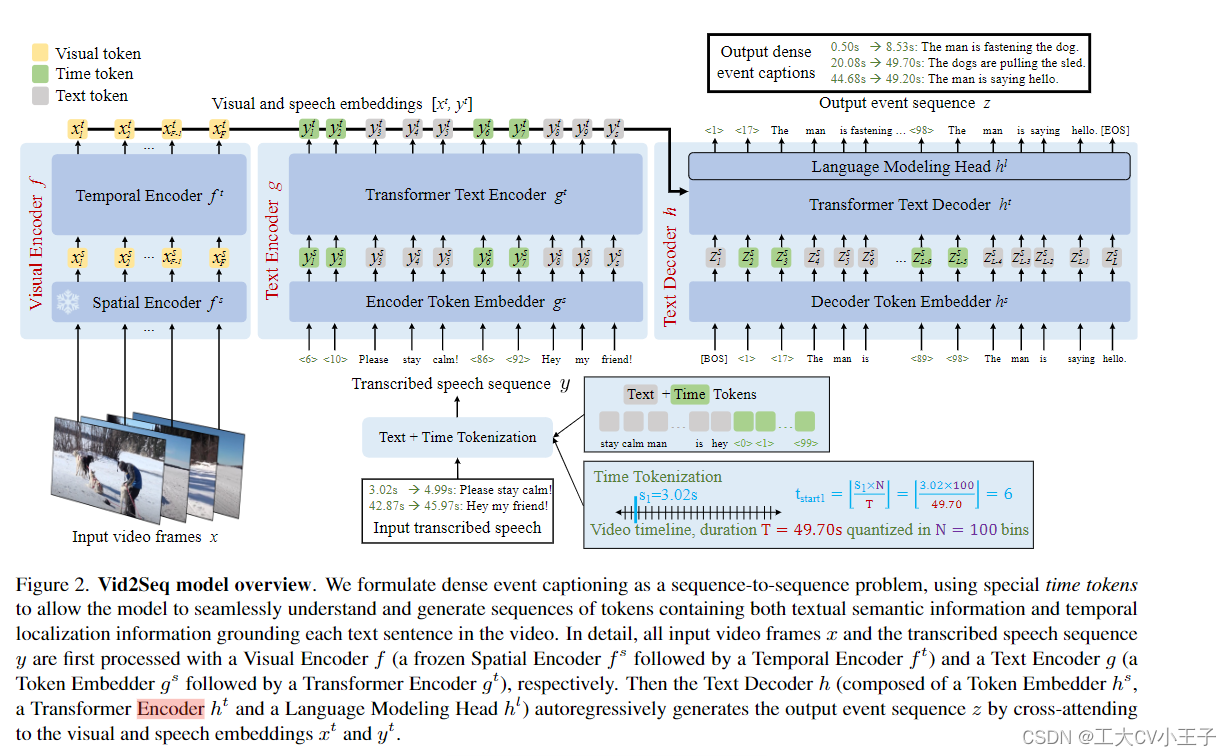

在这项工作中,我们引入了Vid2Seq,这是一种多模态单阶段密集事件字幕模型,它在大规模可用的叙述视频上进行了预训练,Vid2Seq 架构使用特殊的时间标记(time tokens)增强了语言模型,使其能够同时预测同一输出序列中的事件边界和文本描述。这种统一的模型需要大规模的训练数据,这在当前的注释数据集中是不可用的。我们表明,通过将转录语音的句子边界重新表述为伪事件边界,并使用转录的语音句子作为

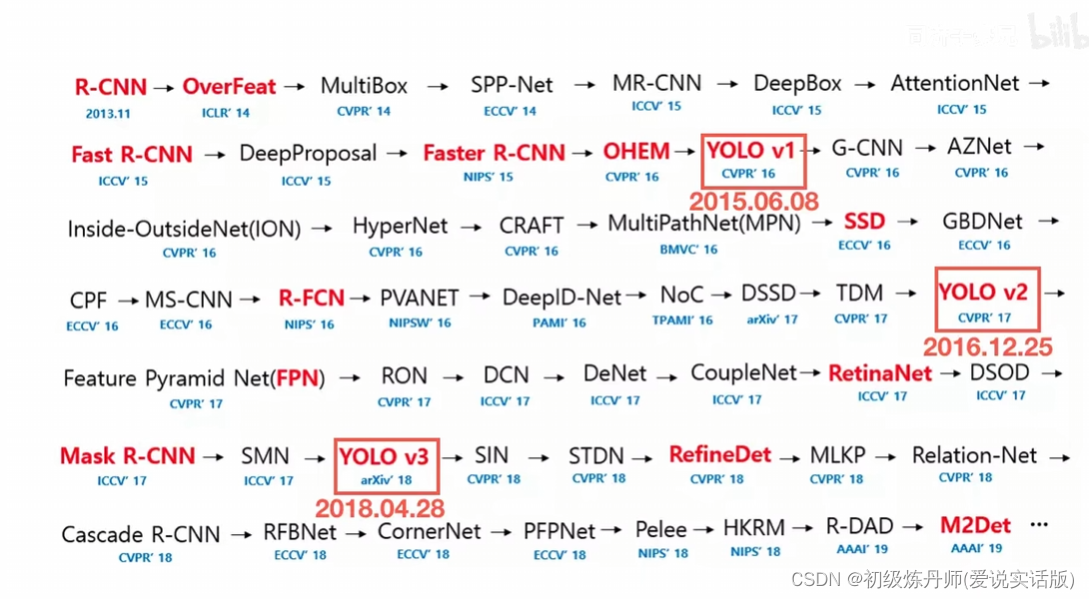

1、准确 (候选框多,效果自然好一些)1、慢 2、候选框太小不能看到整个图像的全景(管中窥豹)(会丢失信息:背景|背景和前景之间的关系|不同物体之间的关系|全图的关系)速度快,不需要复杂的上下游产业链的协同,也不需要对每一个工序单独的训练和优化,是一个,端到端,完整统一的框架但准确率不高,对小目标和密集目标识别效果不好(当然这是以前的说法了)better:比V1性能提升。准确率高Faster:比V