简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

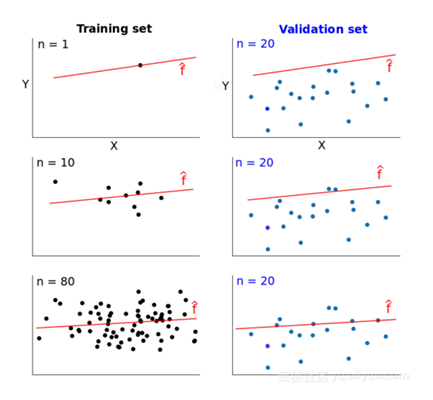

验证曲线是调节学习器的参数的,学习曲线是用来调节训练样本大小的。从理论上来讲,如果数据“同质”,当数据量到达一定程度时,学习器可以学到所有的“特征”,继续增加样本没有作用。

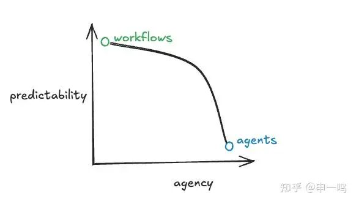

Agent开发框架正从全栈向模块化方向发展,解决早期框架过度设计问题。文章将框架分为全栈开发、流程编排、模型交互、外部工具和低代码五类,每类各有特点和适用场景。开发者应根据业务需求、开发语言和项目规模选择合适框架,模块化、高自由度和维护友好是现代Agent开发框架的关键特征。

2025年LLM领域迎来重大变革,可验证奖励强化学习(RLVR)成为新训练阶段,使模型发展出推理能力。LLM智能呈现"幽灵vs动物"特点 - 某些领域极高智能,其他领域却很弱。Cursor展示了LLM应用新层级,Claude Code成为首个在本地运行的LLM Agent。"氛围编程"让普通人也能编写代码。Google Gemini的Nano Banana预示了LLM的GUI发展方向。2025年是

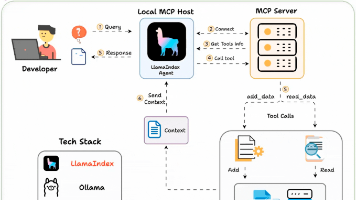

本文详细介绍了如何构建完全本地化的MCP客户端,使AI智能体能直接与SQLite数据库交互。技术栈包括LlamaIndex、Ollama、LightningAI和SQLite。文章提供了从服务器搭建、模型配置到工具包装和智能体构建的完整代码实现,展示了用户查询到智能响应的工作流程。该系统完全本地化,保障数据安全,可扩展应用于数据管理、智能客服等多种场景,为AI智能体与本地数据源的集成提供了实用解决

本文介绍AI Agent的概念、四大核心机制(感知、思考、行动、记忆)及其与大模型的关系。通过实例展示应用场景,并提供在扣子平台创建专属Agent的5步实操指南(建体、定设、添能、调试、发布)。强调Agent是能自动完成任务的全能型AI助手,新手也能快速上手打造个人专属AI助手。

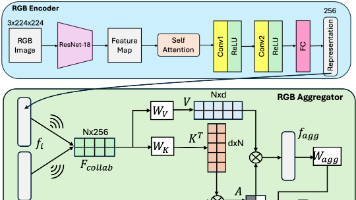

本文提出多模态协同决策(MMCD)框架,通过知识蒸馏技术解决车联网环境中信息异质性与通信资源有限的矛盾。该框架结合多模态感知与图神经网络实现跨车全局感知,利用教师-学生结构降低通信开销,提升系统在模态缺失情况下的鲁棒性。MMCD不仅提升自动驾驶安全性与效率,还为无人机群、多机器人协作等群体智能系统提供普适性解决方案,推动自动驾驶从"单车智能"向"群体智能"转变。

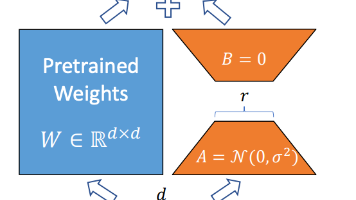

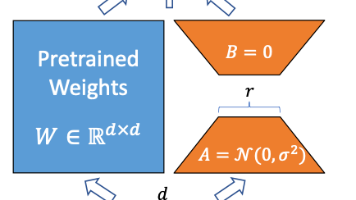

文章详细介绍了低秩适应(LoRA)技术,这是一种参数高效微调方法,通过低秩矩阵分解模拟参数更新,大幅减少可训练参数量。LoRA仅微调查询矩阵和值矩阵即可达到接近全量微调的效果,且较小的秩(r)就能覆盖模型核心变化。相比全量微调,LoRA实现多任务服务、快速迭代、存储优化和推理无开销,显著降低大模型在不同任务适配的资源门槛。

现在的大模型推理能力越来越厉害,人们开始怀疑:我们还需要花时间和资源去微调大模型吗?这个问题没有标准答案,关键在于你的具体需求。下面我们来聊聊什么情况下值得微调,什么情况下可以省这份力气。

LoRA技术通过低秩矩阵分解实现大模型高效微调,将全秩权重更新矩阵ΔW分解为两个低秩矩阵A和B的乘积,参数压缩比达256:1。训练时冻结原始权重,仅优化A和B矩阵,推理时合并至原始权重不增加延迟。该技术灵活应用于Transformer的MHA/FFN层,适用于各种模型结构,是降低大模型微调成本的关键技术。

本篇从基座模型选择、模型整体架构、数据设计、训练微调四个角度总结垂直领域大模型微调经验。本篇将现有垂类大模型微调已公布的实践经验做一个全面的总结,大部分经验实测可推广,大家在自己实践过程中可以进行适当参考。