简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

AI技术正在重塑IT行业,替代重复性任务如基础编程、运维监控和数据处理,但无法取代人类在创造性问题解决、系统决策和跨领域协作中的核心价值。未来IT从业者需转型为解决方案架构师、数据价值挖掘者或复合型人才,将AI作为效率工具,专注于AI难以复制的创新能力。人机协同将成为IT行业新生态,优秀从业者将借助AI实现更大技术价值。

本文介绍了在欧拉Linux系统上部署Dify平台并对接本地Ollama大模型的完整流程。首先确保已安装Docker、Docker Compose和正常运行Ollama服务,然后通过Docker Compose一键部署Dify。重点讲解了如何配置Dify连接Ollama API接口,以及创建首个AI聊天机器人应用的方法。文章还提供了常见问题解决方案和运维管理指南,帮助用户实现本地大模型与可视化AI应

本文详细介绍了使用kubeadm工具在CentOS7系统上搭建单Master节点Kubernetes测试环境的完整流程。主要内容包括:环境准备(硬件要求、系统配置)、基础环境设置(关闭防火墙/SELinux/Swap、内核参数调整)、容器运行时containerd安装、K8s工具集部署、Master节点初始化、Calico网络插件配置、Worker节点加入,以及集群功能测试和日常运维操作。教程针对

本文详细介绍了在openEuler Linux系统上安装Ollama工具并本地部署大模型的完整流程。内容包括环境准备(系统架构检查、硬件要求)、安装步骤(基础依赖安装、Ollama部署)、模型运行方法(以Llama3为例),以及国内用户优化的镜像源配置方案。同时提供了常用操作指南(模型管理、服务配置)和常见问题解决方案(权限、内存、网络等问题)。该教程帮助开发者在欧拉系统上快速实现大模型本地化部署

本文提供了CherryStudio与Ollama的零代码对接教程,帮助用户快速构建本地AI知识库助手。主要内容包括:1) 介绍两款工具的核心优势,实现"本地模型+私有知识库";2) 详细的环境准备与安装步骤;3) 可视化对接Ollama模型的配置方法;4) 实际使用指导,包括文档上传与问答操作;5) 常见问题解决方案。该方案无需编码,数据完全本地化,适合非技术用户和小微团队快速

摘要:本文详细介绍了本地部署AnythingLLM与Ollama的完整流程。AnythingLLM作为开源大模型管理工具,可与Ollama的本地模型运行能力结合,实现私有知识库管理。文章包含环境准备、Ollama安装验证、AnythingLLM两种安装方式(推荐独立安装包)、关键对接步骤及常见问题解决方案。通过本方案,用户可在本地搭建"模型+知识"的管理系统,支持文档上传、知识

本文详解基于Python的Ollama自动化部署脚本,实现AI大模型本地化一键部署。该脚本包含三大核心模块:SSH连接管理(带重试机制)、远程命令执行(支持输出解析)和主流程控制,可完成从服务器连接、依赖安装到模型拉取的全流程自动化。核心特性包括:进度可视化、网络波动容错、多编码支持和智能错误处理。脚本特别适用于批量部署、远程服务器标准化安装等场景,显著提升部署效率和可靠性。通过参数化设计,该方案

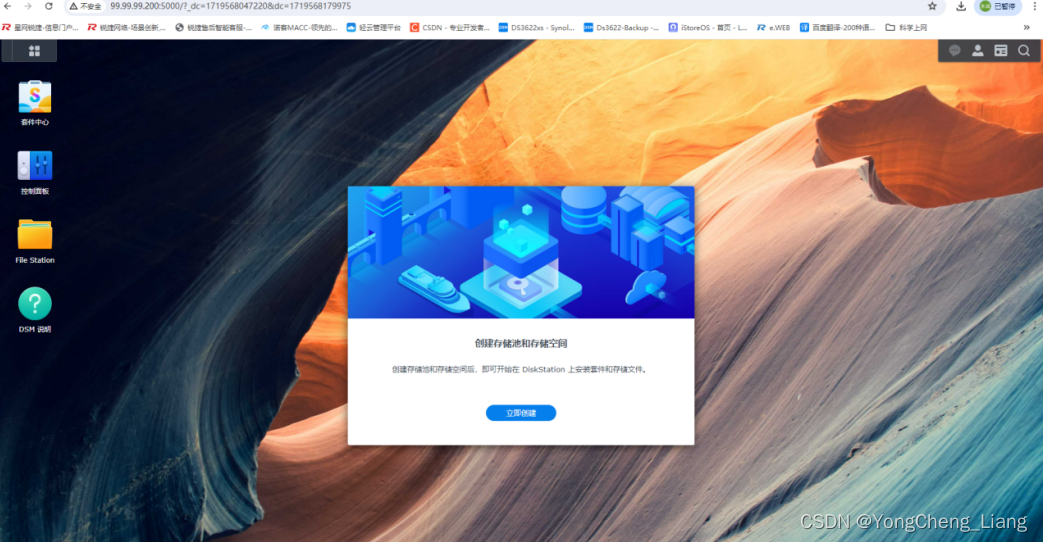

懒人版黑群晖Ds3615xs-DSM7.1安装教程

VMware ESXi 8.0 安装

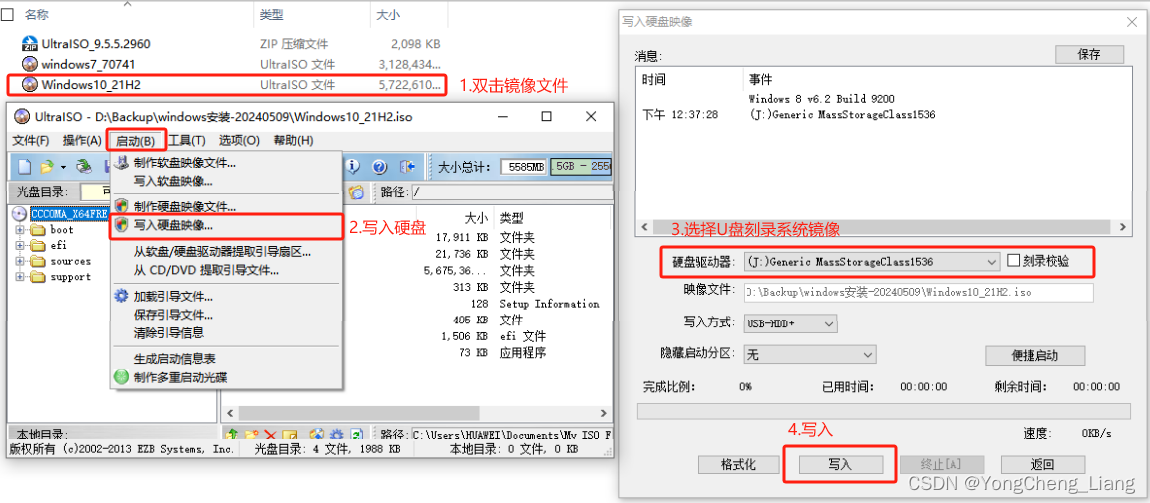

1.准备16GU盘2.准备刻录软件及镜像,下载链接如下3.使用UltraISO刻录软件,将镜像刻录到U盘上4.确认好电脑/笔记本U盘启动快捷键1.台式机:联想、惠普、宏基、神州、方正、清华同方、海尔都是F12启动,华硕(F8),戴尔(ESC)2.笔记本电脑:联想、宏基、小米、戴尔、神州、三星、IBM都是F12启动,华硕(ESC),惠普(F9)3.常见主板:华硕(F8)、技嘉(F12),微星(F11