简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

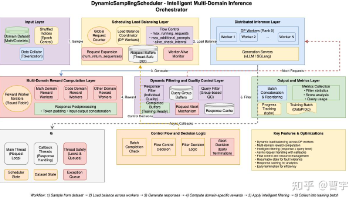

《AgenticRL在终端环境中的实践与挑战》摘要 本文探讨了在终端环境中构建Agentic强化学习(RL)系统的实践经验与核心挑战。相较于传统RLVR(单步bandit问题),AgenticRL涉及多步交互式决策、长时序信用分配和环境状态转移,对算法设计、工程基建和环境管理提出更高要求。文章通过两个研究者的故事引出AgenticRL的典型困境,并系统介绍了解决方案:1)构建ROLL训练框架与RO

来自港科大、字节跳动、港中深和南洋理工的研究者们发现可验证不等于可长期可训练再叠加多轮交互带来的长程信用分配与训练不稳定,使得长期、可扩展的 RL 训练一直缺少系统化方案。

2025年AI领域迎来重大范式转移,Agent自进化技术从理论走向实践。不同于传统静态模型,自进化Agent通过"执行-反思-改进"闭环实现持续优化,在100次任务交互后成功率提升37%。学界存在两种主流路径:模型权重持续更新与记忆上下文进化。青稞社区将举办首期AI AMA直播,邀请6位青年学者(来自阿里、芝加哥大学等机构)探讨自进化的定义、评估、工业落地等核心议题,2月5日1

本文探讨了LLM中的监督微调(SFT)与强化学习(RL)训练之间的关系与差异。作者指出:1) SFT和RL在数学形式上具有统一性,SFT可视为advantage恒为1的RL特例;2) RL训练不稳定主要源于系统级bug、数据质量差异以及训练样本的"毒性"效应;3) 过度依赖训练技巧可能掩盖问题本质,建议优先分析数据分布变化;4) 数据清洗和reward模型训练是RL最可靠的方法

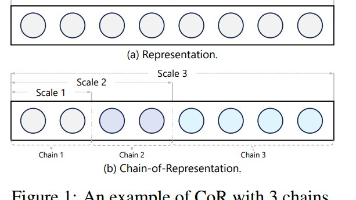

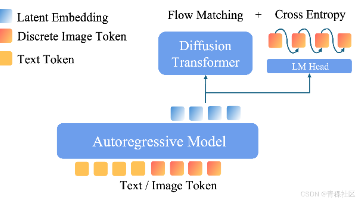

《模型链:大语言模型扩展新范式》摘要 微软、复旦等机构研究者提出"表征链"(CoR)概念,将表征分解为多个子表征链,并在此基础上开发出"模型链"(CoM)学习范式。该范式通过链式层(CoL)在不同尺度间建立因果依赖关系,构建出语言模型链(CoLM)架构。实验表明,CoLM在保持性能的同时展现出更好的扩展性和灵活性:支持链式扩展提升模型能力,实现弹性推理适应不

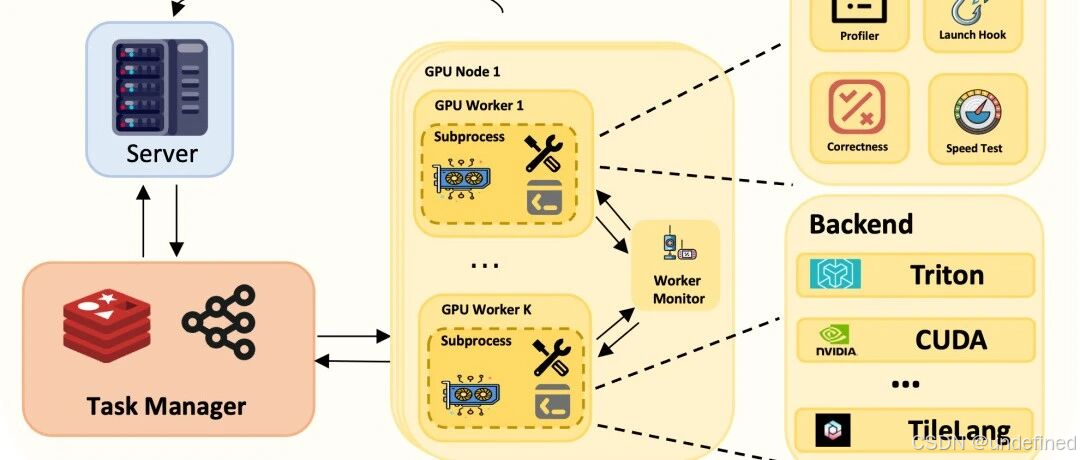

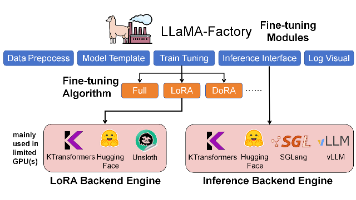

11月22日上午10点,青稞社区联合趋境科技举办第91期青稞Talk,邀请清华大学章明星副教授和KTransformers核心开发者李沛霖,分享大模型微调与推理的系统化实践。面对大模型显存与带宽瓶颈,KTransformers通过GPU+CPU异构协同,实现低成本高性能的百亿/万亿级模型本地化部署。内容涵盖LoRA微调、AMX加速等核心技术,并演示在LLaMA-Factory与SGLang的端到端

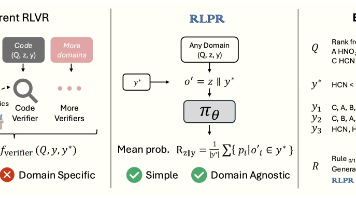

RLPR 提出了创新的 Prob-to-Reward奖励机制,解决了现有 RLVR范式的领域依赖问题。通过在 Gemma、Llama、Qwen 等主流模型系列上的广泛验证,RLPR 不仅证明了其卓越的有效性和相对于传统规则奖励的显著优势,更在推动强化学习(RL)向更大规模(scaling)发展的道路上,迈出了坚实而有力的一步。更多研究细节,可参考原论文。

青稞社区官网:https://qingkeai.online/,青稞Talk 第73期,马里兰大学博士生陈玖海,将直播分享《

摘要: 新加坡国立大学研究团队针对多智能体系统(Multi-Agent Systems)高失败率问题,提出首个全自动失败归因框架AgenTracer。通过构建TracerTraj数据集(2000+高保真失败轨迹)和设计多粒度强化学习算法,其微调的8B参数模型在定位根本错误时,准确率超越GPT-4.1等大型模型达18.18%。实验表明,该框架不仅能精准识别导致系统失败的**"决定性错误&q

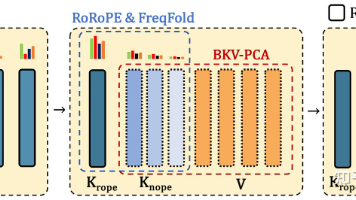

TransMLA模型实现了三大突破:1)压缩大部分KV Cache;2)最小化性能损失;3)兼容DeepSeek推理代码,无需硬件优化即可加速。该工作通过RoRoPE和FreqFold技术去除K中多数head的位置编码,结合BKV-PCA进行低秩压缩,解决了此前Palu方案因RoPE导致的推理效率问题。实验表明,TransMLA的表达能力超过Group-Query Attention(GQA),在