简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

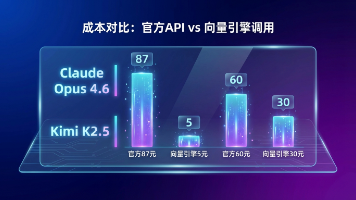

很多同学会问:“博主,为什么不直接把所有文档都扔给 GPT-5.3-Codex 的长窗口?这个问题问得好。确实支持很长的上下文。贵:Token 是按量收费的。如果你每次提问都把几百页的技术文档发过去,你的钱包撑不过三天。慢:处理 10万字 和处理 100字,延迟是完全不一样的。用户体验会极差。迷失:研究表明,当上下文过长时,大模型容易忽略中间的信息(Lost in the Middle 现象)。而

想象一下。你是一个图书管理员。图书馆里有几亿本书(你的数据)。如果有人来问:“有没有关于‘怎样用Python写一个爬虫’的书?传统的数据库(比如MySQL)是怎么找的?它是用关键词匹配。它会疯狂地翻书名,看哪本书名字里同时有“Python”和“爬虫”。这种方法很笨,经常找不到书,或者找到一堆不相关的。AI时代的做法是什么?我们雇佣了一个超级懂书的专家(Embedding模型)。这个专家不看关键词。

大家好我是你们的AI探路者。最近AI圈子简直比娱乐圈还乱。今天OpenAI发个炸弹。明天Anthropic扔个王炸。后天Google又来个回马枪。我们这些搞开发的简直苦不堪言。每天不是在申请Waitlist的路上。就是在调试各种稀奇古怪的API文档。尤其是最近那个火到不行的Open Claw。还有大家都在折腾的opencode配置教程。我也跟风去搞了一下。结果为了配置那个OpenClaw Claw

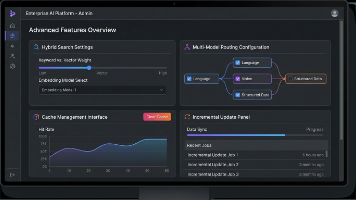

Clawdbot是运行在OpenClaw之上的一个高级机器人/代理框架。它就像是OpenClaw的一个超级插件。它主要解决的是“状态管理”和“工具调用”的问题。而我们最关心的“长期记忆”,就是一种最重要的状态。当用户发消息给Clawdbot时。Clawdbot要先去我们前面搭建的向量引擎里溜达一圈。看看有没有相关的历史背景信息。如果有,就捞出来。打包发给大模型。大模型回答完之后。Clawdbot还

Clawdbot是运行在OpenClaw之上的一个高级机器人/代理框架。它就像是OpenClaw的一个超级插件。它主要解决的是“状态管理”和“工具调用”的问题。而我们最关心的“长期记忆”,就是一种最重要的状态。当用户发消息给Clawdbot时。Clawdbot要先去我们前面搭建的向量引擎里溜达一圈。看看有没有相关的历史背景信息。如果有,就捞出来。打包发给大模型。大模型回答完之后。Clawdbot还

上周五晚上十点我刚准备关电脑下班老板突然发来消息客户的AI客服系统炸了五千个用户在线排队超时率百分之八十五我打开监控一看GPT API调用全线崩溃请求堆积如山错误日志刷屏那一刻我在想为什么调用个API这么难OpenClaw是向量引擎推出的自定义中转站配置工具说人话就是它给你搭建了一个专属的API通道你不用再直连OpenAI服务器而是通过向量引擎的高速节点中转就像你从北京到上海以前要坐绿皮火车现在可

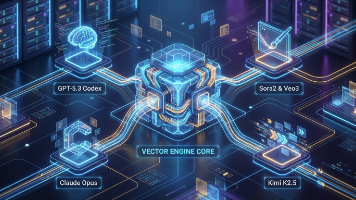

作为一个重度选择困难症患者,我最怕的就是"太多选择"。OpenAI有GPT-4、GPT-5.2、GPT-5.2-Pro…Anthropic有Claude Opus 4.6、Claude Sonnet…还有Gemini、Kimi、DeepSeek、通义千问…我直接麻了。然后我发现了向量引擎,号称支持500多个模型。我当时的表情:😱557个?这不是要我命吗?但测试了3天后,我发现了一个惊人的秘密…6

支持20万上下文,直接“喂”一本小说:用向量引擎快速检索长文档配置完成后,点击“保存路由”,OpenClaw就会自动把你的请求“分发”到最合适的模型。现在,你只需要调用服务器IP:8080/api/codex就能用GPT-5.3写代码;调用/api/opus就能用Claude Opus 4.6写文案;调用/api/kimi就能用Kimi K2.5读长文了!写了这么多,其实就是想告诉你一个真相:AI

上个月我在做一个 AI 代码审查工具,技术栈是 Next.js + GPT-4,本来想着赶在产品发布会前上线。结果凌晨三点,测试环境突然全线超时,OpenAI API 直接给我返回 429 和 503 轮着来。我盯着监控面板,看着错误率从百分之五飙到百分之八十,整个人都麻了。更崩溃的是,我去年充的 500 美元配额还剩 300 多,因为项目延期根本用不完,眼看着下个月就要过期。这感觉就像你办了健身

最近AI圈又炸了OpenAI的Claw刚发布就被玩坏各路大神都在测试极限但你知道吗真正让这些AI模型跑得飞快的秘密不是算力不是显卡而是一个你可能从没听说过的东西向量引擎今天我就来给大家掰扯掰扯这个神器保证让你看完就能上手先说个大白话你有没有遇到过这种情况问AI一个问题它转啊转啊转半天最后给你来句我不知道或者答非所问这就是因为AI没有找到合适的知识库向量引擎就是解决这个问题的它把所有信息都变成数学向