简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

手动设计AI组件的时代正在过去,AI自我进化的时代正在到来。这篇论文证明了,与其让人类绞尽脑汁去猜Agent需要什么样的数据库结构,不如给AI一个代码编辑器,让它在千万次试错中自己找到答案。ALMA的关键启示:用代码作为策略的搜索空间,比调整参数强大得多。没有通用的完美记忆,只有最适合当前任务的记忆。当Agent学会了优化自己的大脑(记忆结构),通向AGI的递归自我改进(Recursive Sel

这篇论文不仅仅是一个技术实验,更是一个高能预警。AI安全不仅仅是对话安全:以前我们只关心AI会不会说脏话,现在我们要关心AI会不会组团骗钱。现有的安全护栏已失效:大部分模型(除了Llama-3.1-405B)在面对诈骗指令时,几乎没有任何拒绝。技术是双刃剑:DeepSeek、Claude等模型强大的推理能力,既能用于科研,也能被用于构建完美的骗局。屏幕对面坐着的,是人,还是一群正在开会复盘诈骗话术

DeepSeek-OCR 2 的发布标志着视觉编码从单纯的“特征提取”向“语义推理”的转变。通过将 LLM 架构引入 Vision Encoder 并结合因果注意力机制,DeepSeek 探索出了一条在二维空间结构与一维因果语言建模之间搭建桥梁的技术路径。这不仅优化了 OCR 任务,也为未来构建处理音频、视频等全模态(Omni-modal)数据的统一编码器提供了验证。项目地址:https://gi

如果用泡茶来比喻,蒸馏就像提取茶叶中最精华的香气和味道,将其浓缩到一杯水中。**教师生成“解题笔记”:**大模型(教师)针对数学、代码等任务生成详细答案,例如解方程时每一步的推导逻辑。**学生模仿“思维模式”:**小模型(学生)不再死记硬背答案,而是学习教师解题时的决策过程,比如优先选择哪种公式、如何验证结果。**提炼“知识精华”:**最终,小模型能像教师一样举一反三,甚至在未见过的新题型上灵活应

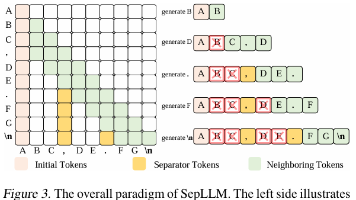

本文旨在解决 Transformer 长序列推理时 KV 缓存随长度二次膨胀的问题。作者发现分隔符 token(如“.”、“,”)在注意力中权重显著高于语义 token,推测其已将所在片段信息压缩于自身。据此提出SepLLM:一种仅保留aaa个)、(全部)与nnn个)KV 的稀疏注意力机制;其余 token 在注意力中被掩码。

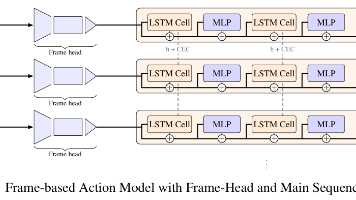

Recurrence-Complete Frame-based Action Models》这篇论文的真正价值,是促使我们重新审视“深度”的含义。过去,我们习惯用网络层数和参数量来衡量模型的深度与容量。而该研究有力地证明,如果一个模型在时间维度上不具备递归更新状态的能力,其理论表达力将受到结构性的限制。FBAM 架构及其展现出的新型缩放定律,为我们指明了一条通往更长时程、更强交互智能的可能路径。

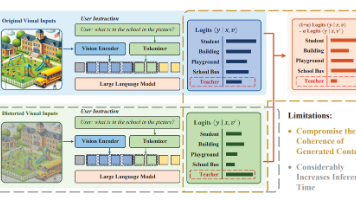

多模态大语言模型(MLLMs)是当前AI领域的重要研究方向。这类模型突破了传统语言模型仅依赖文本的局限,融合文本、图像、音频等多种模态,使交互更自然、应用场景更广泛。例如,在智能客服中,它能结合语音与文字精准理解用户需求;在智能写作中,可根据图片生成适配文案,展现出强大的潜力。然而,多模态大语言模型的发展也面临诸多挑战。高质量多模态数据稀缺是一个关键问题,现有数据质量参差不齐,标注难度大、成本高,

考虑受控马尔可夫过程MSApMSAp,其中SSS为状态空间,AAA为动作空间,ps′∣saS×A→ΔˉSps′∣saS×A→ΔˉS为转移概率分布。给定无标签数据集DτiiDτii,包含长度一致(简化讨论)的无奖励轨迹;目标是学习目标条件策略πa∣sgS×S→Aπa∣sgS×S→A,最大化目标函数VπsgEτ∼pπτ∣sg∑t0TγtIs。

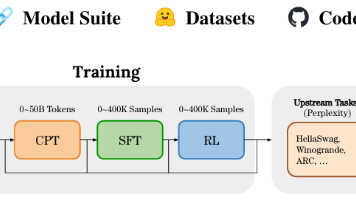

本文探讨了在计算资源受限(如仅有 8 张 RTX 4090)的真实环境下,如何科学地分配算力以训练出高性能的垂直领域语言模型。研究基于哈佛与斯坦福团队发表于 NeurIPS 2025 的EvoLM项目,通过对 100 多个 1B/4B 规模模型进行全生命周期(预训练 PT、持续预训练 CPT、监督微调 SFT、强化学习 RL)的穷举式实验,揭示了模型训练动力学的核心规律。文章否定了盲目追求大参数量