简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

1.H2简介H2是一个开源的、内存型嵌入式数据库引擎,它是一个用Java开发的类库,可直接嵌入到应用程序中,与程序一起打包发布出去,不受平台的限制。2.引入依赖新建一个SpringBoot工程,并在pom.xml文件中添加集成H2所需要的dependency。<dependency><groupId>com.h2database</groupId><art

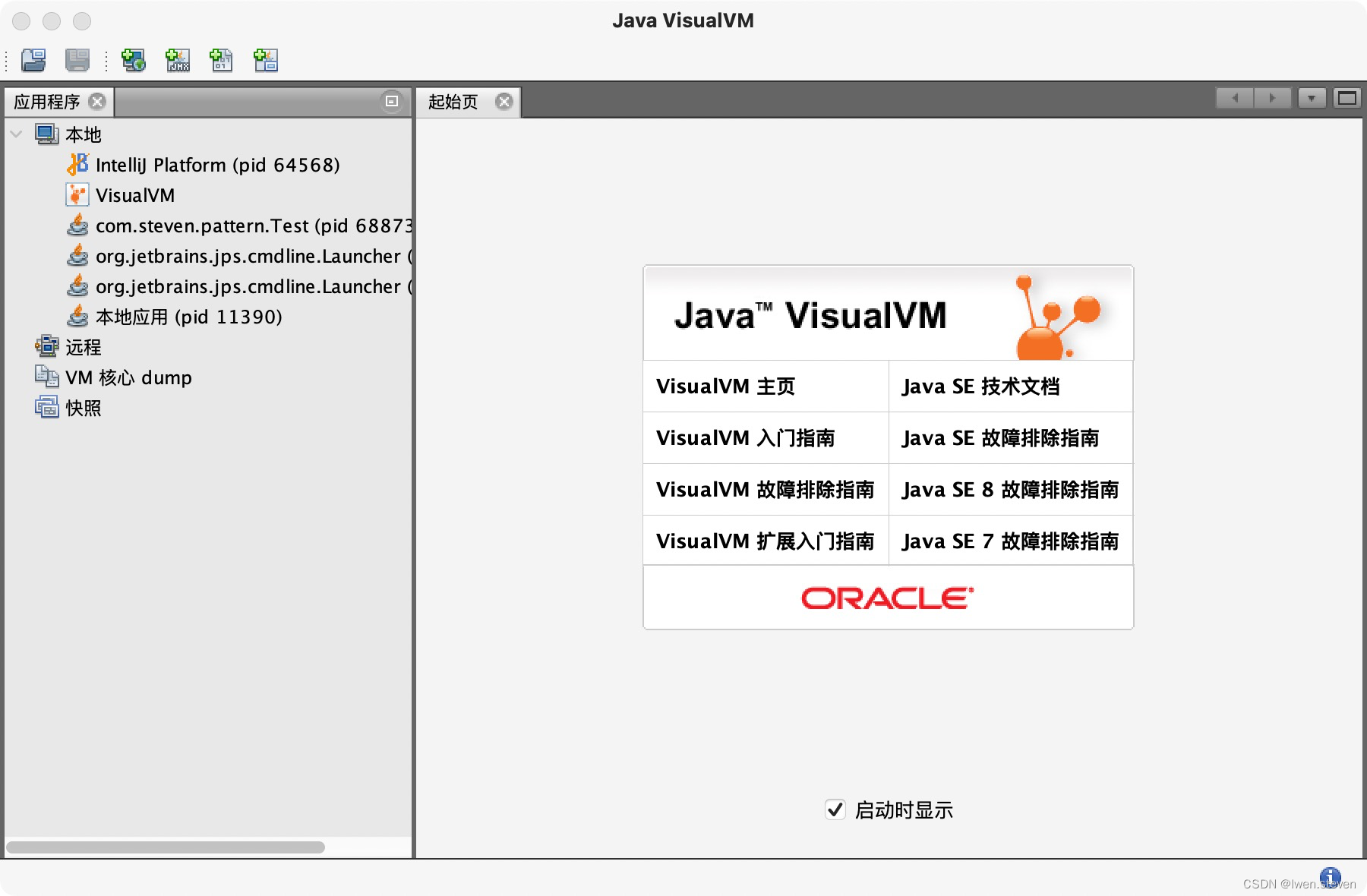

1.简介VisualVM是JDK内置的可视化工具,使用jvisualvm命令打开。2.概述显示应用的概要信息。

1.命令方式(1).API设置为从节点(新增数据会同步)localhost:6379 > slaveof 127.0.0.1 6379查看节点主从属性(role的值)localhost:6379 > info replication取消复制localhost:6379 > slaveof no one(2).复制流程客户端执行slaveof命令从节点向客户端返回消息(异步过程)从

1.Admin APIAPI作用AdminClientAdminClient客户端对象NewTopic创建topicCreateTopicsResult创建topic的返回结果ListTopicsResult查询topic列表ListTopicsOptions查询topic列表及选项DescribeTopicsResult查询topicDescribeConfigsResult查询topic配置项

1.condition开发在项目目录“/src/main/java/com/example/es”下新建condition目录,并在condition目录下新建SampleEmployeeCondition查询条件类,具体代码如下。@Datapublic class SampleEmployeeCondition {@Must@Field("employeeId")private String e

1.客户端实现基本原理(1).step1获取所有Sentinel节点和masterName,遍历Sentinel集合得到一个可用(即可以ping通)的Sentinel节点。(2).step2向可用的Sentinel节点发送Sentinel的get-master-addr-by-name的请求(参数masterName)来获取master节点信息。(3).step3客户端获取master节点后,会执