简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

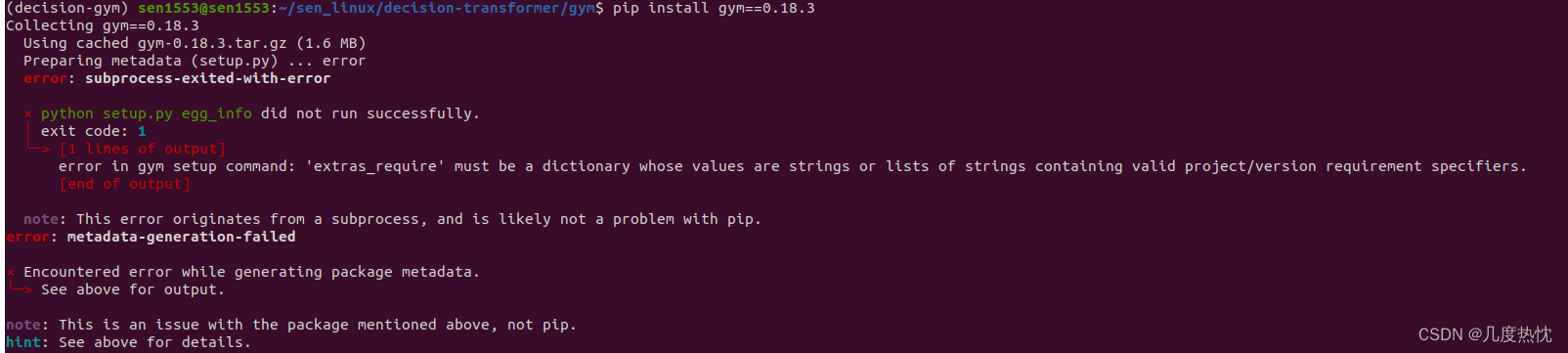

安装gym==0.18.3报错的解决方法Collecting gym==0.18.3Using cached gym-0.18.3.tar.gz (1.6 MB)Preparing metadata (setup.py) ... errorerror: subprocess-exited-with-error× python setup.py egg_info did not run succes

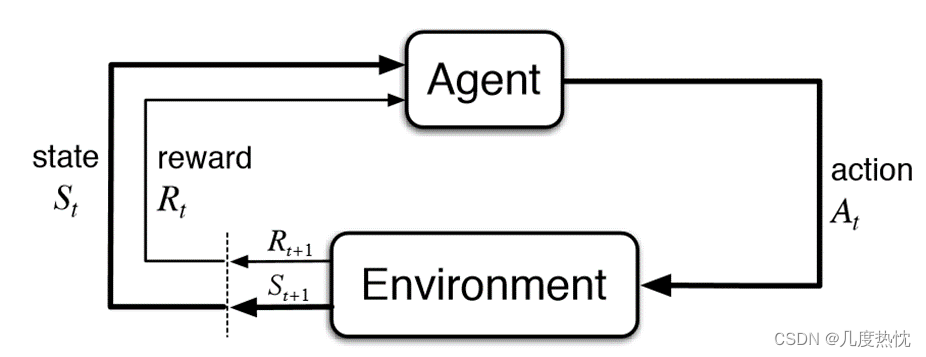

【强化学习】强化学习基础教程:基本概念、强化学习的定义,要素,方法分类 以及 Rollout、episode回合、transition转移、trajectory轨迹的概念1.基础概念1.1 强化学习的定义1.2 强化学习的基本要素2.强化学习分类2.1 根据agent学习方式分为基于策略的强化学习Policy based RL ,基于价值的强化学习Value based RL以及Actor-Cri

这三个项目都是Stable Baselines3生态系统的一部分,它们共同提供了一个全面的工具集,用于强化学习的研究和开发。SB3提供了核心的强化学习算法实现,而RL Baselines3 Zoo提供了一个训练和评估这些算法的框架。SB3 Contrib则作为实验性功能的扩展库,SBX则探索了使用Jax来加速这些算法的可能性。

基础概念线性回归的过程是已知数据点,需要通过一条直线来拟合这些点,这条直线对应的参数 都是通过线性回归求得例子:假设y = X × w + by是一个房子的价格X是一个向量[X1,X2],X1是面积,X2是位置,是影响y的因素,w是X中对应的权重[w1,w2]T, b 是偏差y=w1 × X1+ w2 × X2+b 通过梯度下降寻找不断更新参数以得到最优解从0实现线性回归代码是指定w为 [2, 3

【强化学习】Q-learning,DQN,SARSA算法介绍强化学习算法分类基于价值的方法基于策略的方法Actor-Critic方法Q-learning算法DQN算法强化学习训练数据存在的问题经验回放机制备份网络机制Sarsa算法总结

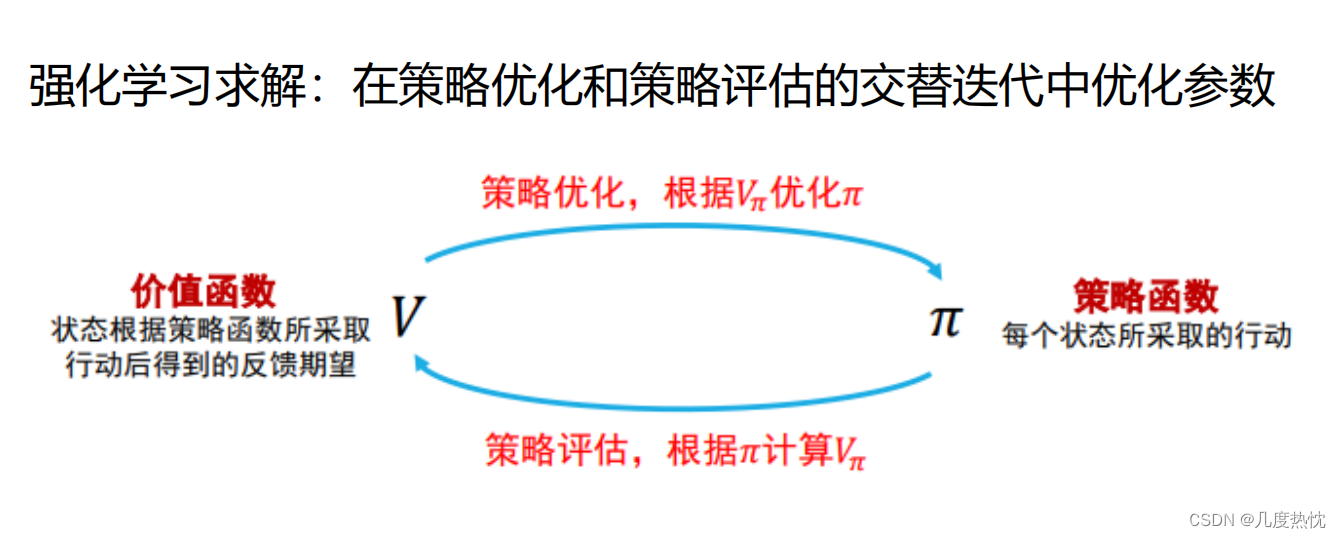

【强化学习基础算法】基础算法:贪婪算法 策略迭代 价值迭代 Sarsa Q-learning核心思想简介贪婪算法ϵϵ-贪婪算法递减的ϵϵ-贪婪算法上置信界算法UCB汤普森采样法基于动态规划的强化学习算法策略迭代价值迭代时序差分算法Sarsa算法Q-learningN步sarsa算法参考文献

ImportError: cannot import name ‘imresize’ from ‘scipy.misc调试项目报错,百度查找介绍说Imresize在scipy的1.3.0版本后被弃用,可以通过安装1.2.1版本的scipy来解决而通过 pip install scipy==1.2.1会报很多错 orz解决方法:只能另辟蹊径,查到了一篇帖子,介绍说imresize可以被以下代码代替f

【强化学习基础算法】基础算法:贪婪算法 策略迭代 价值迭代 Sarsa Q-learning核心思想简介贪婪算法ϵϵ-贪婪算法递减的ϵϵ-贪婪算法上置信界算法UCB汤普森采样法基于动态规划的强化学习算法策略迭代价值迭代时序差分算法Sarsa算法Q-learningN步sarsa算法参考文献

【Easy RL】Easy RL蘑菇书全书学习笔记第一章 强化学习基础1.1 强化学习概述监督学习强化学习与监督学习的不同之处二者的区别总结强化学习的特征强化学习的优越性预演(rollout)和 轨迹(trajectory)的概念端到端的概念深度强化学习(deep reinforcemet learning)sim2real1.2序列决策基本概念状态和观测的关系环境信息完全可观测-->马尔科夫决策

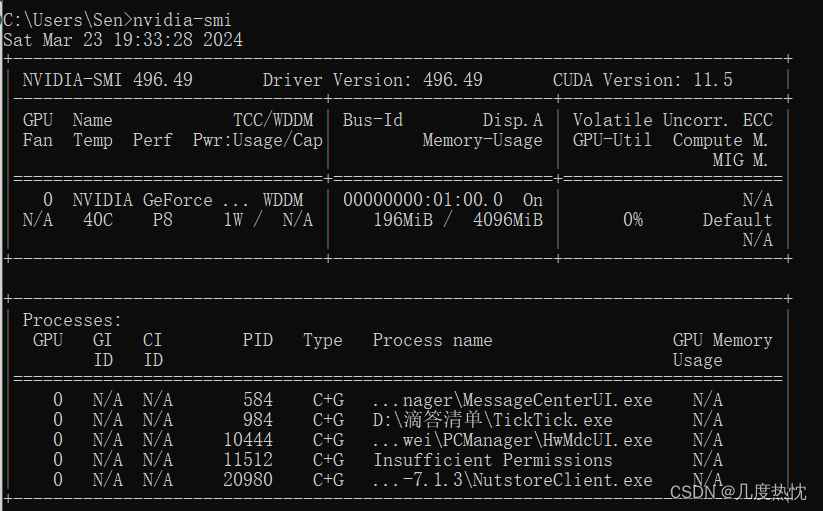

每隔X秒执行一次 nvidia-smi 命令,并持续显示 GPU 的使用情况。这样可以更频繁地更新 GPU 的状态信息,提供更实时的监控数据。nvitop 是一个基于 NVIDIA GPU 的实时性能监控工具,类似于 Linux 系统上的 top 命令。windows下可使用以下命令,可达到类似效果,每秒更新一次信息,但每次都会打印一遍信息 体验不是很好。nvitop能够以可视化的方式展示GPU的