简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

最后,文章重点对比了 PCIe 与 SXM 封装形式及 NVLink 互连方案的优劣,并基于计算能力、内存和互联性能三大维度,为 AI 工程师提供了在不同部署环境下(云端或本地)选择 GPU 的实用决策框架。带宽是另一个关键的性能维度。从大家用来训练 LoRA 适配器的 RTX 3/4/590,到驱动(并仍在驱动)大语言模型集群的 H100,再到专为大规模生成式 AI 训练与推理而进入数据中心的全

本文系原作者观点,Baihai IDP 仅进行编译分享作者 | Peter Steinberger编译 | 岳扬最近我没怎么在社交平台上活跃,因为我正全身心投入到最新的项目中。如今,智能体工程(Agentic engineering)已经变得非常强大,几乎能编写出我需要的 100% 的代码。然而,我却看到很多人还在费力解决本不该存在的问题,搞出一堆繁复的表演,而不是专注把事搞定。这篇文章的部分灵感

作者通过“代码整洁度检查”这一完整示例,清晰展示了如何组合使用 Command + Agent 实现手动流程,或 Skill + Agent 实现智能主动介入,并强调 —— 选择依据不应是“功能复杂度”,而应是“谁来决定执行时机”。Command 是手动触发器。Agent 并非比 Command “更高级” —— Command 是触发器,Agent 是执行者,它们扮演着不同的角色。Command

BI和AI开发平台并不是非此即彼的替代关系,而是相互协作与补充,共同帮助企业构建强大的数据洞察挖掘能力。

尽管 Nvidia 拥有丰富的资源,数据集的大小适中,答案也相对简短,但研究者们还是通过一种新的 RAG 方法,发送 48K 的文本片段并连同用户查询一起,打破了之前的最先进水平,实现了 47.25 的 F1 score(如果发送的内容更少,F1 score 会更低)基于同义词的搜索确实能够找到关键字搜索遗漏的产品,但这是有代价的。这意味着,当搜索关于“国王”的信息时,系统会优先展示关于“王后”的

这篇论文提出了一种高效的方法,可以在有限的内存和计算资源约束下,将基于 Transformer 的大语言模型(LLMs)扩展到处理无限长的输入。通过将海量外部知识嵌入模型的上下文窗口,CAG 能够生成信息丰富且上下文相关的回答,避免了传统检索增强生成(RAG)系统的检索延迟。这些策略为扩展测试时计算(test-time computation)提供了额外的灵活性(例如,通过增加检索的文档数量或生成

文章通过简历筛选这一典型应用场景,系统阐述了 AI 系统发展的四个核心阶段:从最基础的纯 LLM 架构,到增强检索能力的 RAG 系统,再到具备工具调用能力的 AI 工作流,最终发展为具有自主决策能力的 AI Agent。它尤其擅长处理依赖其参数化知识(即训练阶段内化的信息)的任务,典型场景包括:总结小说内容、撰写关于全球变暖的论述、用 5 岁儿童能理解的语言解释狭义相对论、或者创作俳句(译者注:

的观点(原因已在上文简要说明),但我认为她提出的“数字化进程推动破折号的使用”这一说法非常可信。文章系统梳理并逐一反驳了多种主流解释,然后通过分析标点使用的历史趋势、尼日利亚英语语料库统计数据,以及 GPT-3.5 到 GPT-4o 破折号使用激增的时间节点,有力支撑了“旧书数字化”这一最合理的假说。我们今天为大家带来的文章,作者的核心观点是:当前主流大语言模型对破折号的偏爱,很可能源于其训练数据

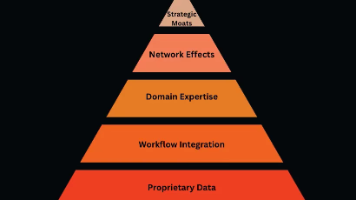

唯有当你的模型性能超越业界公开的、性能最好的开源模型,且能在数小时(而非数周)内完成重新训练时,优势才会真正显现。人工智能并非灵丹妙药 —— 尤其是在那些因过去妥协或短视决策累积许多落后技术架构、设置许多机械死板的操作规范、拥有过度保守的官僚体系的传统企业内部。我们今天为大家带来的文章,作者的观点是:真正的 AI 护城河需要系统性地构建六层递进式能力,从技术底座到战略壁垒,缺一不可。例如,Zill

"时,基于 OCR 识别出的错误表格结构数据的 RAG 系统可能曲解数据之间的关系,产生诸如"2025 年研发占比 49%,而 2024 年高达 8,675%"的荒谬回答。这样,它就能准确地做出反应:“您的权益类资产配置在过去的一年内从 45% 攀升至 58%,这是您的投资组合构成中最大的变化。"时,基于传统 OCR 输出的 RAG 系统只能提供有关投资组合组成部分的一般信息,完全无法解读图表中揭