简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

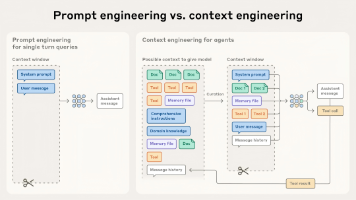

摘要 上下文工程是构建高效AI智能体的核心方法,旨在解决大模型的上下文衰减和注意力预算限制问题。关键策略包括:使用信息量高但token少的系统提示;通过即时上下文检索和工具动态加载数据;采用压缩、结构化笔记和子智能体架构管理长周期任务。这些方法帮助智能体在有限上下文窗口中保持高效运作,实现更强大的自主性和连贯性。随着模型能力提升,混合策略和自主检索将成为智能体设计的趋势。

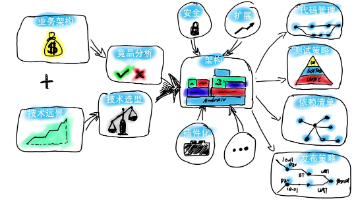

企业级智能体高效构建方法论 本文提出了一套系统化的企业级智能体构建框架,包含4大阶段和10个步骤: 明确需求阶段:确定应用场景、目标与验收标准,识别关键干系人和数据来源,产出场景说明书、验收标准和成本清单。 体系架构设计阶段:完成整体技术架构设计,进行关键技术PoC验证,细化核心模块(如AI网关、RAG知识库等)并落地实施。 智能体落地与评估阶段:采用敏捷方式,将系统拆分为可独立验证的子智能体MV

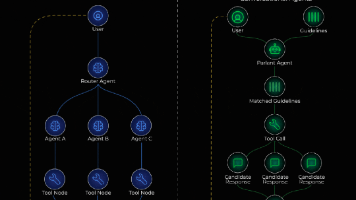

下一代AI Agent架构突破多话题混合处理瓶颈:传统监督者模式面临用户混合提问时的失忆问题,新方案采用动态准则匹配机制替代单一路由决策。如Parlant框架通过评估所有相关准则、动态加载上下文,使AI能够同时处理退货和保修等交叉问题,实现更自然的对话体验。这种从"选路"到"配方"的转变,解决了LangGraph在复杂对话中的固有局限,代表AI客服系统的进化

本文介绍了一个简单AI Agent的开发过程,用于管理本地文件。主要内容包括:1)编写三个工具函数(read_file、list_files、rename_file)用于文件操作;2)使用pydantic-ai框架创建Gemini模型实例;3)构建Agent对象并注册工具函数;4)开发基础交互程序;5)改进版本添加对话记忆功能。该Agent能自动调用相应函数执行用户请求,如读取文件内容、重命名文件

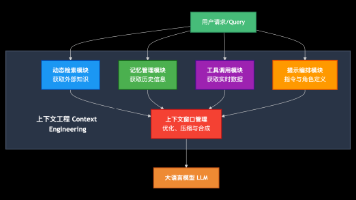

摘要 上下文工程(CE)是优化大模型交互效果的系统化方法,相比提示词工程(PE)具有四大优势:结果更稳定可重复、扩展性更强、具备状态记忆能力、用户操作负担更低。CE包含五大模块:动态检索、记忆系统、工具使用、提示工程和上下文更新机制,不同场景可灵活组合。以AI编程助手为例,CE通过显式配置文件(编码规范等)和隐式交互信息(代码片段、对话历史)的智能组合,显著提升代码生成质量。CE代表了AI开发范式

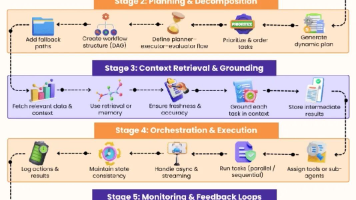

AI智能体工作流设计6阶段详解:1.任务理解与目标定义(拆解任务、设置自主性);2.规划与分解(创建DAG结构、动态调整);3.上下文检索(RAG技术、确保准确性);4.编排执行(并行/顺序任务、状态管理);5.监控反馈(实时检测、自动重试);6.评估优化(定义KPI、自动化改进)。该框架为构建稳健AI工作流提供系统方法论,助力应对复杂任务场景。

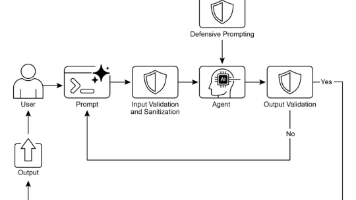

智能体安全护栏设计模式 本文介绍了AI智能体系统中的关键安全机制——护栏(Guardrails)设计模式,旨在防止有害内容生成和系统滥用。护栏作为多层防御机制,通过输入验证、输出过滤、行为约束等手段确保智能体安全合规运行。文章详细阐述了护栏在客服机器人、内容生成、教育辅导等多个场景的应用,并强调工程化智能体需遵循模块化、可观测性等软件工程原则。护栏机制对维护AI系统可信度、防止伦理法律风险至关重要

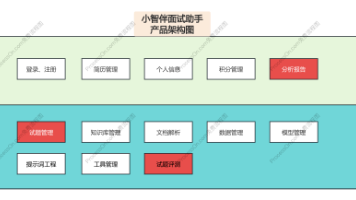

本文介绍了两种AI大模型推理策略(ReAct和Plan-and-Execute)在智能产品"小智伴"中的应用。ReAct模式通过推理-执行循环实时调用工具,适合需要频繁查证的任务;Plan-and-Execute则先规划再执行,适用于复杂多步骤任务。文章详细阐述了从需求分析到流程图设计,再到代码实现的完整推理步骤拆解方法,并提出了包括匹配度评估、评测集验证和人工兜底在内的结果评

本文探讨了LangGraph框架中的ToolNode机制,该组件能有效扩展智能体的工具调用能力。ToolNode作为LangGraph的"工具执行器",封装了工具调度逻辑,支持同步/异步调用,并能自动处理错误。文章介绍了ToolNode的三大核心功能:接收LLM工具请求、执行调用、更新图状态,并重点说明了使用@tool装饰器定义工具的四个关键要素。通过两个代码示例,展示了Too

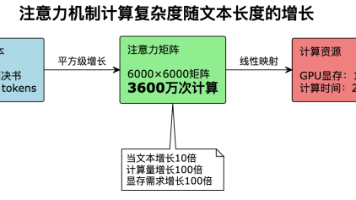

突破大模型Token限制的司法应用方案 本文探讨了突破大模型Token限制的技术方案在司法文书处理中的应用挑战与解决方案。主要内容包括: 问题概述:司法文书平均20万字远超GPT-5(128K)等模型的处理能力,专业术语和复杂法律关系的分析需求加剧了这一挑战。 技术瓶颈:Transformer架构的O(n²)计算复杂度使处理10万字案卷需要1.4TB显存,远超当前硬件能力。 司法特殊需求:证据链完