简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

解决的问题:当前基于指令的图像编辑模型通常依赖于监督微调训练,这导致模型在标注模式上过拟合,限制了它们在训练分布之外的探索和泛化能力。此外,编辑指令和任务的多样性使得缺乏通用的奖励模型。提出的方案:引入Edit-R1框架,该框架基于策略优化,结合了扩散负面感知微调(DiffusionNFT)和多模态大语言模型(MLLM),以提供免训练的奖励机制,帮助解决模型在不同指令环境下的泛化问题。应用的技术。

本文介绍了AnyTalker框架,用于生成自然的多人说话视频。该框架引入了可扩展的音频-人脸交叉注意力结构,支持任意数量角色的驱动,并通过创新的两阶段训练方法(先利用单人数据模拟多人说话,再微调增强互动)显著降低了多人生成模型的训练成本。此外,文章首创了基于眼部动作的交互性定量评估指标及其配套数据集。实验表明,AnyTalker在口型同步、视频质量和角色间互动自然度上均优于现有方法。

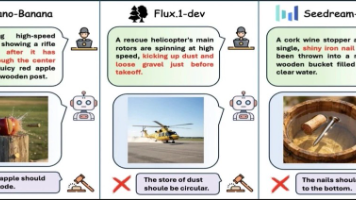

核心能力缺失:当前文生图模型缺乏对隐含世界知识和物理因果推理的理解。它们能生成逼真且符合指令的图像,但在需要常识和逻辑推理的提示词上经常失败。评估体系不完善:现有的评估方法要么侧重于组合对齐(即图像是否包含提示词中提到的元素),要么依赖单轮视觉问答进行打分。这导致对知识基础、多物理交互和可审计的证据等关键维度的测试严重不足。评估方法不可靠:依赖多模态大语言模型进行整体评判的现有方法存在幻觉(看到不

摘要: 论文提出WithAnyone框架,解决多身份图像生成中的“复制粘贴”伪影问题。通过构建大规模配对数据集MultiID-2M(含50万张多人照片)和评估基准MultiID-Bench,结合对比身份损失与四阶段训练策略,模型在保持身份一致性的同时显著减少伪影。实验表明,WithAnyone在生成保真度与多样性权衡上优于现有方法,用户研究验证其视觉质量与可控性优势。

【摘要】VFR框架突破性地实现了从单张图片生成任意时长(720×1152分辨率,24FPS)的高质量虚拟试衣视频,解决了现有技术局限于静态图像或超短视频的痛点。该研究通过自回归分段生成策略,结合"锚视频"全局引导和"前缀条件"局部优化,在保持3D一致性的同时,创新性地实现了分钟级视频的平滑过渡与时间连贯性。实验表明,该方法在四个评估维度(服装/人体一致性、手

精度与效率的权衡问题现有基于微调的方法(Fine-tuning)需要大量计算资源和数据集,效率低。免训练方法(Training-free)在指令理解和编辑质量上表现不佳,精度不足。指令理解与编辑质量不足免训练方法难以准确解析复杂指令,导致编辑效果不理想。微调方法依赖大规模数据训练(如 450K~10M 样本),计算成本高。初始噪声选择影响编辑质量不同的初始噪声会导致不同的编辑效果,如何优化噪声选择

现有的图像与视频生成模型在质量、一致性和计算效率方面仍存在不足。需要构建大规模、高质量的数据集,以支持高性能生成模型的训练。现有的生成架构未能充分统一图像和视频的表示,影响跨模态生成效果。训练大规模生成模型的计算成本高,需优化并行计算与存储机制。

解决的问题当前文本生成图像(T2I)模型,如 DALLE 3、Stable Diffusion 3 等,参数量巨大,推理时内存需求高,难以在资源有限的设备(如移动设备)上部署。本文重点研究极低比特量化(1.58-bit)在 T2I 模型中的可行性,以减少存储和内存需求,同时提升推理效率。**提出的方案 **选用 FLUX.1-dev 模型作为量化目标,通过后训练量化方法将其权重压缩为 1.58-b

核心挑战:现有视频生成技术难以实现精细化的细节控制,无法精确对齐用户意图,特别是在视频背景替换任务中。具体问题前景一致性:替换背景时,难以保持前景主体(如人物、物体)的像素级细节和外观一致性,容易出现非预期的改变。时序照明一致性:难以在视频序列中保持照明效果的时序连贯性。资源限制:专业绿幕流程成本高昂;基于数据驱动的视频方法缺乏高质量的配对视频数据集,且模型训练需要巨大的计算资源。

Hunyuan-GameCraft-2提出了一种指令驱动的交互式游戏世界模型,通过集成文本、键盘和鼠标信号实现语义化交互控制。该模型采用14B参数的MoE架构,结合自回归蒸馏与随机化长视频微调技术,支持高效稳定的长时序视频生成。创新性地定义了交互式视频数据标准,并开发了自动化数据构建管道。实验表明,模型在InterBench基准上取得SOTA性能,能以16FPS实时生成高质量交互视频,显著提升了动