简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

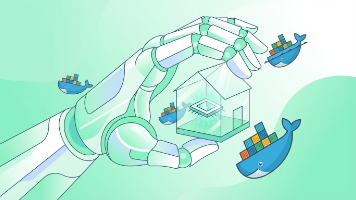

OpenClaw 是 GitHub 上热门的 AI Agent 项目,可通过 Docker 快速部署,避免环境冲突问题。只需安装 Docker 并准备 API Key(如 Claude 3.5 或 GPT-4o),拉取镜像后配置 config.json 文件,启动容器即可运行。OpenClaw 支持文件操作、浏览器访问和命令执行,还能连接本地大模型(如 Ollama)。遇到问题可查看日志排查,轻松

本文介绍了一种利用AI生成透明背景PNG素材的高效方法。通过绿幕技术配合FFmpeg自动抠图管线,可以批量生产透明素材,解决传统获取方式昂贵、耗时的问题。文章详细拆解了实现原理:首先让AI生成纯绿背景图片,再用FFmpeg的colorkey滤镜去除绿色背景并处理边缘溢出,最后自动裁切透明区域。该方法适用于轮廓清晰的实物素材,成本低至每个$0.1,但处理半透明物体时仍有局限。GitHub上已有封装好

Anthropic 指控 DeepSeek、月之暗面、MiniMax 通过 Claude API 进行知识蒸馏。本文从蒸馏技术原理、API 防御方案、模型输出版权归属三个角度分析,并讨论对开发者调用 AI API 的实际影响。

摘要:大模型厂商发布的benchmark成绩往往存在设计、运行条件和报告方式的差异,不能直接作为决策依据。以Anthropic发布的Opus 4.6为例,其Terminal-Bench分数受不同工具链影响,Humanity's Last Exam成绩依赖额外工具支持,GDPval-AA的144 Elo优势仅代表70%场景领先。更值得关注的是,该模型在核心指标SWE-bench和MCP Atlas上

OpenClaw(前身是 Clawdbot/Moltbot)最近火得一塌糊涂。GitHub 星数飙升到 149k,大家都在感叹终于有个开源版的"贾维斯"了。你可以让它帮你发邮件、整理文件、甚至控制智能家居。但就在几天前,爆出的 CVE-2026-25253 漏洞给这股热潮浇了一盆冷水。CVSS 评分 8.8,高危。简单说,如果你在用老版本的 OpenClaw,黑客只要发给你一个链接,你点开,你的电

OpenClaw项目GitHub星标激增但暴露严重安全隐患:默认绑定localhost的设计在容器化环境中失效,导致上千实例暴露公网,其中一起案例造成1.8亿AI令牌被盗。核心问题在于单点架构将所有敏感功能集中,使攻击者一旦突破即可完全接管系统。文章指出AI代理的特殊风险在于能执行自然语言指令,建议必须默认开启认证、拆分功能模块、实施最小权限原则。随着项目热度持续攀升(18万星标),如何在易用性与

AI技能平台ClawdHub存在严重安全漏洞:研究员通过伪造下载量使恶意技能登上热门推荐,48小时内23名用户安装。该平台缺乏代码审查、下载量验证和作者信誉系统,使攻击者可轻易植入窃取API密钥的恶意指令。更复杂的供应链攻击和依赖污染手法可能造成更大危害。建议用户安装前检查作者历史、查看源码并限制权限,同时官方正计划改进统计方式和引入安全扫描。这暴露出AI Agent生态缺乏成熟信任基础设施的问题

摘要:Peter Steinberger展示了AI编程(Vibe Coding)的极致形态,一天提交688次commit,其中296次来自AI项目Clawdbot。与传统开发流程不同,Vibe Coding通过自然语言描述需求,AI生成代码并直接提交,将开发时间从数天缩短至数小时。然而,研究发现仅10.5%的AI生成代码是安全的,常见漏洞包括硬编码敏感信息、SQL注入、路径遍历等。AI编程还导致技

摘要:Peter Steinberger展示了AI编程(Vibe Coding)的极致形态,一天提交688次commit,其中296次来自AI项目Clawdbot。与传统开发流程不同,Vibe Coding通过自然语言描述需求,AI生成代码并直接提交,将开发时间从数天缩短至数小时。然而,研究发现仅10.5%的AI生成代码是安全的,常见漏洞包括硬编码敏感信息、SQL注入、路径遍历等。AI编程还导致技

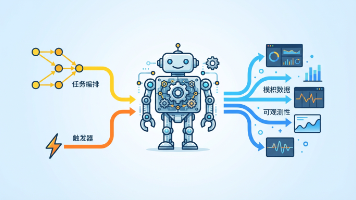

clawdbot是一款开源AI助手,能操作浏览器、调用API、访问shell,强调沙盒隔离和系统化能力。文章从编排、触发、可观测性三方面分析如何将其从"能用"升级为"敢长期跑"的自动化系统:1)任务编排需拆解阶段并设置护栏;2)通过cron、事件和人工触发实现自动化运转;3)建立日志、指标、追踪、审计的可观测性闭环。建议从低风险场景起步,逐步构建可靠的自动化