简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

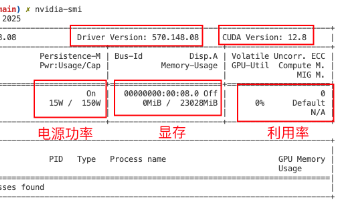

本文介绍了使用vLLM框架进行大模型本地化部署的完整流程。主要内容包括:1)环境安装与配置,推荐使用docker方式;2)两种模型部署方式(命令行参数和配置文件);3)通过OpenAI SDK进行API测试调用;4)性能测试脚本开发,评估首token时间、QPS等关键指标;5)在腾讯Cloud Studio平台上的实战操作演示。文章以Qwen2.5-1.5B模型为例,详细说明了从环境搭建到性能测试

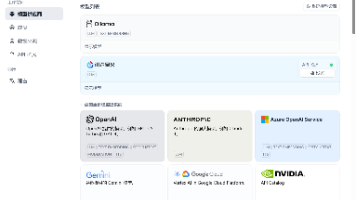

Dify是一款开源的大语言模型应用开发平台,提供BaaS服务,让开发者快速构建生成式AI应用。平台支持多种模型接入(推理、Embedding、语音转文字)、5种应用类型(聊天助手、文本生成等)和可视化工作流编排(包含多个功能节点)。其核心功能包括知识库管理(实现RAG技术)、灵活的流程设计以及多场景应用开发。安装需WSL和Docker环境,提供直观界面简化开发流程,适合从简单对话到复杂业务场景的A

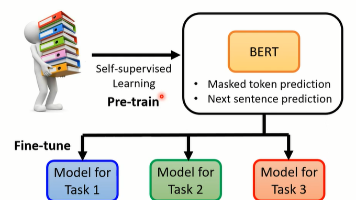

NLP任务发展经历了四个范式:传统机器学习、深度学习、预训练微调和提示学习。Prompt-Tuning作为最新范式,通过构建模板和标签映射将下游任务转化为预训练任务,显著减少数据需求。其发展历程包括离散提示(GPT3、PET)和连续提示(PromptTuning、P-tuning、PPT)两种方法。连续提示通过参数化模板向量,解决了离散提示方差大的问题。该方法尤其适合大模型场景,可在冻结主模型参数

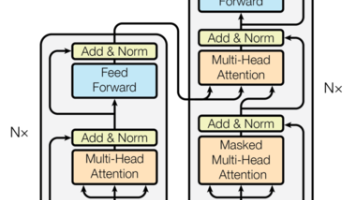

Transformer模型是2018年由Google团队提出的革命性架构,在BERT等模型中发挥核心作用。其核心优势在于并行计算能力和强大的特征提取性能。模型主要由输入部分(词嵌入+位置编码)、编码器(多头自注意力机制+前馈网络)、解码器三部分组成。输入部分通过词嵌入和三角函数位置编码实现文本表示;编码器采用多层结构,每层包含自注意力机制和规范化处理;解码器结构与编码器类似但增加跨注意力层。该架构

摘要:本文介绍了bitsandbytes模块的量化原理及其在大模型部署中的应用。该工具通过INT8/INT4量化技术显著减少显存占用(INT8为FP32的25%,INT4为12.5%),同时利用GPU的TensorCore加速推理。实验表明,Qwen1.5-14B-Chat模型在INT8和INT4量化后仍保持流畅对话和代码生成能力,而预训练模型Qwen2.5-32B量化后不具备对话能力。使用vLL

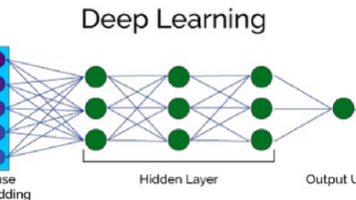

文章摘要: 循环神经网络(RNN)是一种专门处理序列数据的神经网络,通过循环结构能够记忆历史信息,适用于时间序列和自然语言处理任务。RNN在文本生成、语音识别、时间序列预测等领域有广泛应用。词嵌入层是RNN处理文本的关键,将离散单词转换为连续向量表示(如使用PyTorch的nn.Embedding),捕捉语义关系并降低维度。RNN通过循环结构处理序列数据,保持文本的顺序特性,解决传统神经网络无法处

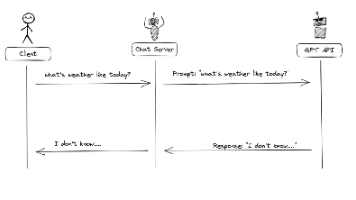

OpenAI于2023年6月推出的FunctionCall功能使GPT-4/3.5-turbo能通过JSON对象调用外部函数,解决了大模型的信息实时性、数据局限性和功能扩展性问题。文章详细介绍了FunctionCall的工作原理,通过查询天气、航班信息和SQL数据库三个实践案例,展示了如何定义函数、描述参数并实现交互。案例代码包括函数调用流程、参数传递及结果处理,证明FunctionCall能有效

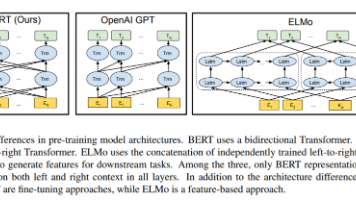

BERT是由Google提出的一种基于Transformer Encoder的双向预训练语言模型。文章首先介绍了BERT的架构,包括Embedding模块、双向Transformer模块和预微调模块;其次详细说明了BERT的两个预训练任务:Masked LM(采用15%的token进行随机遮掩训练)和Next Sentence Prediction(句子关系预测);然后分析了BERT的优缺点,其优

Chroma是一款轻量级本地向量数据库,支持嵌入管理、查询、过滤和持久化功能。它可与大语言模型结合构建RAG问答系统。主要功能包括:安装通过pip,使用DuckDB+Parquet作为存储后端;通过Collection管理数据,支持添加文本/自定义向量;提供相似性查询和元数据过滤功能;支持按ID或条件删除数据;可查看文档数和预览数据;具备持久化存储能力;能与LangChain集成使用自定义Embe

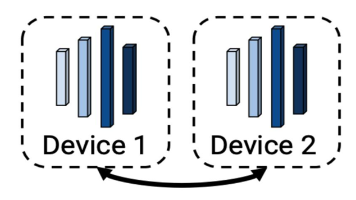

项目推荐配置GPU 数量≥16 张 A100 80G(或 ≥32张 A100 40G)最小总显存≥1.2 TB(模型 + 梯度 + 优化器)模型精度优化器AdamW(默认)或 8-bit Adam(节省内存)batch size128~512(依赖 grad accumulation)并行框架推荐 DeepSpeed ZeRO-3 / Megatron-LM。