简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

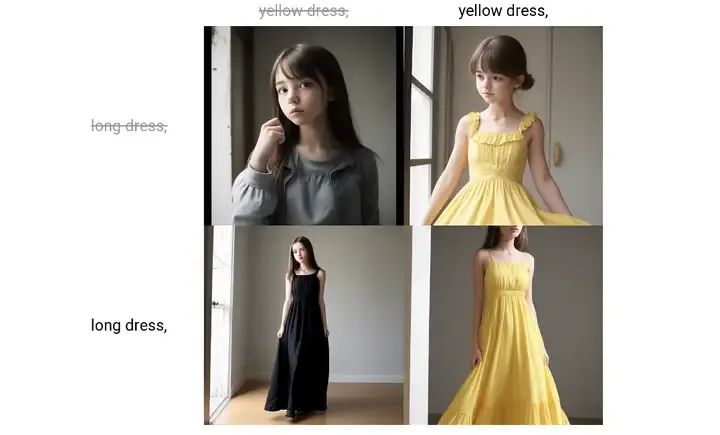

随着[AI技术]的飞速发展,AI绘画已经成为了艺术创作领域的新宠。而亚洲人物写实模型,以其绝美的颜值和青春靓丽的形象,成为了AI绘画领域的一大亮点。

在数字化转型浪潮中,图像处理技术已深度融入各行各业,成为推动创新的关键力量。作为新一代图像增强模型,SDXLControlnetTileV2凭借其卓越的高清分辨率和灵活可控的处理能力,为用户带来了全新的创作体验。

常用工作流已经给各位小伙伴打包好了,可以按需自取,无偿分享。

AIGC技术的未来发展前景广阔,随着人工智能技术的不断发展,AIGC技术也将不断提高。未来,AIGC技术将在游戏和计算领域得到更广泛的应用,使游戏和计算系统具有更高效、更智能、更灵活的特性。同时,AIGC技术也将与人工智能技术紧密结合,在更多的领域得到广泛应用,对程序员来说影响至关重要。未来,AIGC技术将继续得到提高,同时也将与人工智能技术紧密结合,在更多的领域得到广泛应用。感兴趣的小伙伴,赠送

关于ComfyUI的正式版是否会收费的问题是很多AI玩家都关心的问题。一旦ComfyUI正式版发布,我们是否需要为它买单?不再开源同时这也引出了一个核心问题:开源究竟等不等于免费?

感兴趣的小伙伴,赠送全套AIGC学习资料,包含AI绘画、AI人工智能等前沿科技教程和软件工具,具体看这里。AIGC技术的未来发展前景广阔,随着人工智能技术的不断发展,AIGC技术也将不断提高。未来,AIGC技术将在游戏和计算领域得到更广泛的应用,使游戏和计算系统具有更高效、更智能、更灵活的特性。同时,AIGC技术也将与人工智能技术紧密结合,在更多的领域得到广泛应用,对程序员来说影响至关重要。未来,

一、流程图在工作流中操作数据库。作用:在数据库中查询个人信息1.首先准备数据库,这里我们使用mysql,数据库中存放的是个人信息2.写一个后台程序调用mysql(这里我们使用python语言)3.在dify中创建工作流:在工作流的节点中写另外一个python程序来调用我们上一步写好的后台程序从而达到获取数据库中个人信息的目的二、具体操作。

AIGC技术的未来发展前景广阔,随着人工智能技术的不断发展,AIGC技术也将不断提高。未来,AIGC技术将在游戏和计算领域得到更广泛的应用,使游戏和计算系统具有更高效、更智能、更灵活的特性。同时,AIGC技术也将与人工智能技术紧密结合,在更多的领域得到广泛应用,对程序员来说影响至关重要。未来,AIGC技术将继续得到提高,同时也将与人工智能技术紧密结合,在更多的领域得到广泛应用。感兴趣的小伙伴,赠送

各位设计界的领军人物们,你们一定对PS(也就是大家熟知的Photoshop)不陌生吧。同样,对于AI领域的精英们,SD(stablediffusion)这款软件也应该是如雷贯耳。这两款软件,各自独立且功能强大,都是设计领域不可或缺的工具。特别是在今年AI技术的飞速发展下,我们很难在设计工作中完全忽视SD这款强大且高度可控的AI软件。与此同时,PS作为设计师的必备工具,其地位也是不言而喻的。然而,在

大家好,我是爱绘画的彤姐。在探讨数字艺术与创意设计的前沿领域时,Stable Diffusion(简称SD)作为一款引领潮流的AI绘画工具,以其卓越的图像生成能力和广泛的应用潜力,正逐步改变着我们对艺术创作的传统认知。今天,我们将聚焦于Stable Diffusion在建筑设计领域的应用,特别介绍十个令人瞩目的SD建筑模型。