简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

用了大量的行业数据,模型怎么反而变弱了?比如,对一个回答问题能力不错的模型,用大量数据做指令微调以后,模型变得不会回答问题了。对这个问题,正好做了不少实验,也和周边很多有实践的人讨论了这方面的问题。

如果你真的想学习大模型,请不要去网上找那些零零碎碎的教程,真的很难学懂!你可以根据我这个学习路线和系统资料,制定一套学习计划,只要你肯花时间沉下心去学习,它们一定能帮到你!

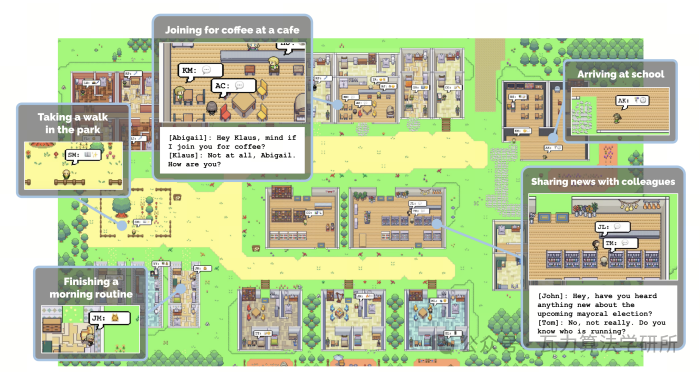

Agent(智能体)概念最早由人工智能领域的研究者提出,旨在模拟人类的智能行为。最初的Agent系统主要集中在解决特定问题或领域,如专家系统、规则引擎等。20世纪80年代末和90年代初,随着计算机和网络技术的发展,Agent开始融入到各种应用中,如搜索引擎、个人助理等。强化学习等技术的兴起(2014年起,深度强化学习出现)使得Agent能够通过与环境的交互来学习和优化其行为。

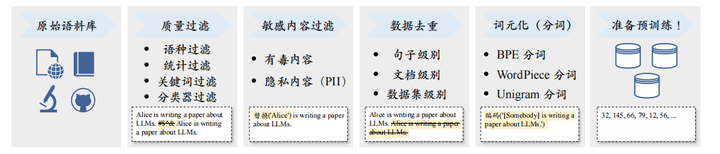

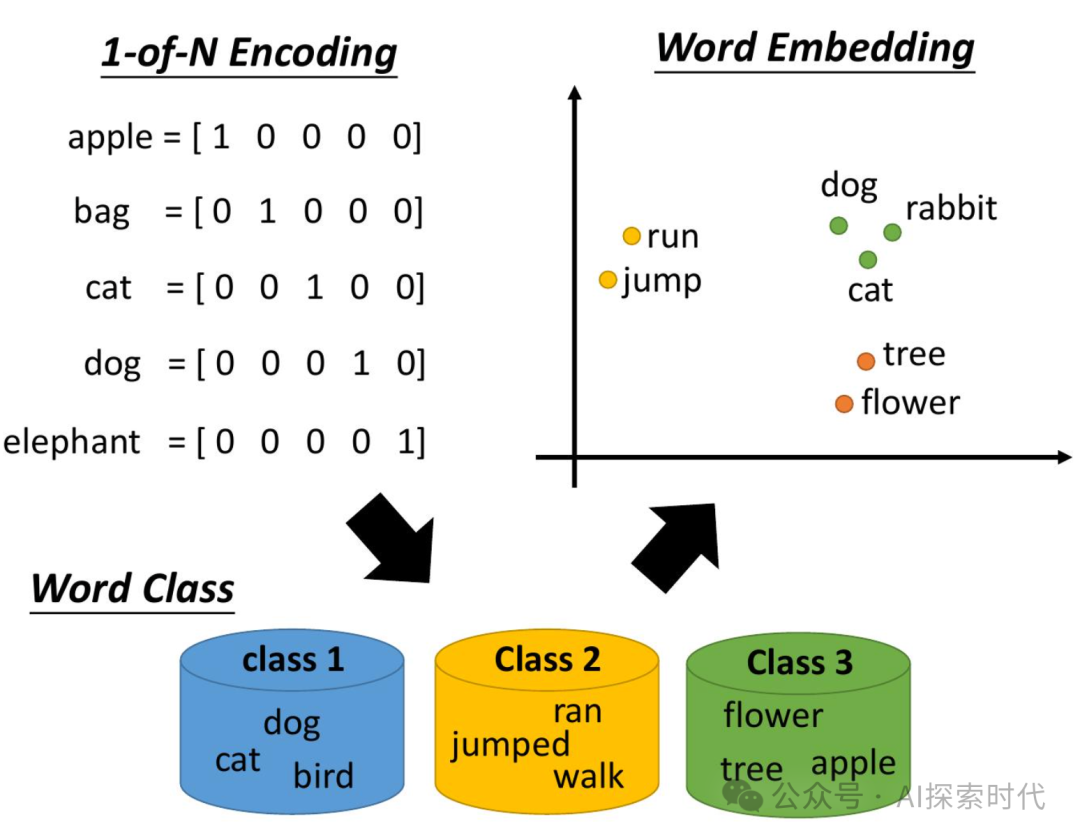

向量化是一切大模型技术的基础,大模型中的一切都是向量。在之前的文章曾不止一次的讲过向量,向量作为大模型的基础数据格式,其重要性不言而喻;但大部分人对向量还是没有一个深刻的认识。所以,今天我们就来讨论一个问题,那就是向量化,大模型的入口。向量化向量的概念这里就不解释了,有问题的可以看之前的文章,或者自己去找一下向量,矩阵的内容看看。先来讨论第一个问题,为什么要向量化?原因在于计

总体而言,微信接入大模型技术将是一个颠覆性的进步。它不仅能通过智能化提高用户的交流效率,为内容创作者带来更多灵感和受众,也能为商家开辟全新的营销渠道。其潜在的收益和影响是巨大的,但收获这些益处的同时,也要学会管理由此产生的“难以预估”的大挑战。(如果不转变,就有可能会逐步蚕食替代,正如胶卷被数码相机替代)微信是一个“巨人”,每一步的动作都仔细揣摩,正如托尔斯泰所说:**“所有的伟大变革都是静悄悄地

并不是说以上的“做法1”是不对的,我自己也有过很多次的“做法1”,毕竟相信前辈往往都能有不错的结果。我只是想强调:SFT这个方向有没有技术含量,还是要看自己的定位和做法。

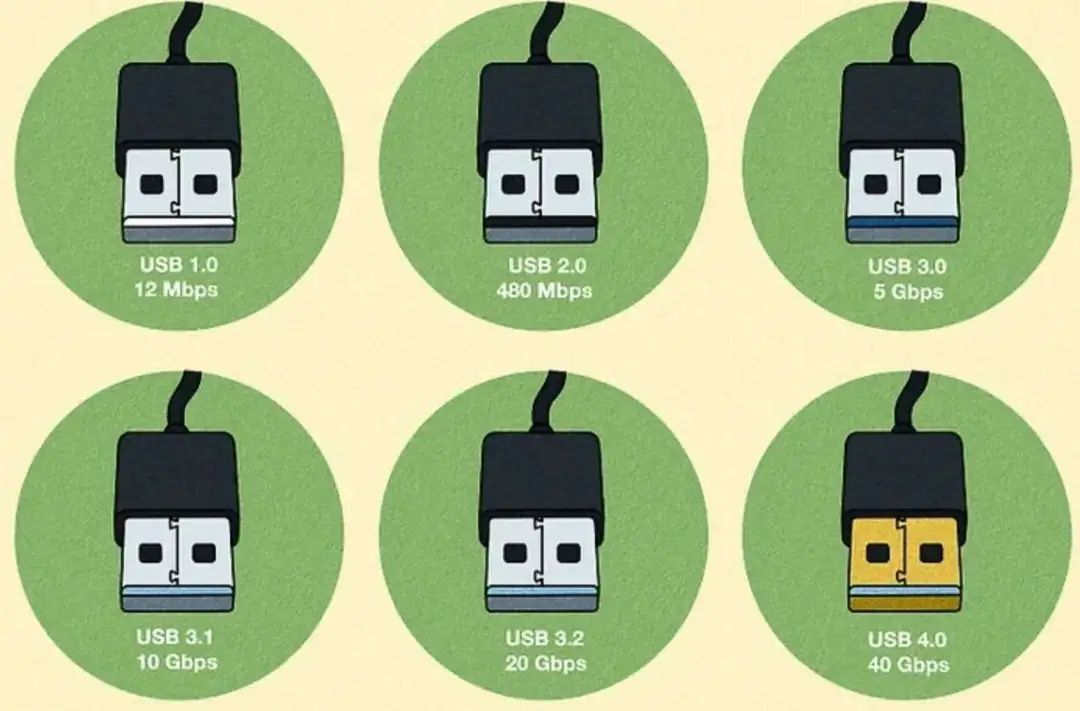

迄今为止,应该没有人还怀疑大模型的能力吧?但目前大模型实现真正落地,其实还有一段艰难的路要走。**1. 大模型:**一般指1亿以上参数的模型,但是这个标准一直在升级,目前万亿参数以上的模型也有了。大语言模型(Large Language Model,LLM)是针对语言的大模型。**2. 175B、60B、540B等:**这些一般指参数的个数,B是Billion/十亿的意思,175B是1750亿参数

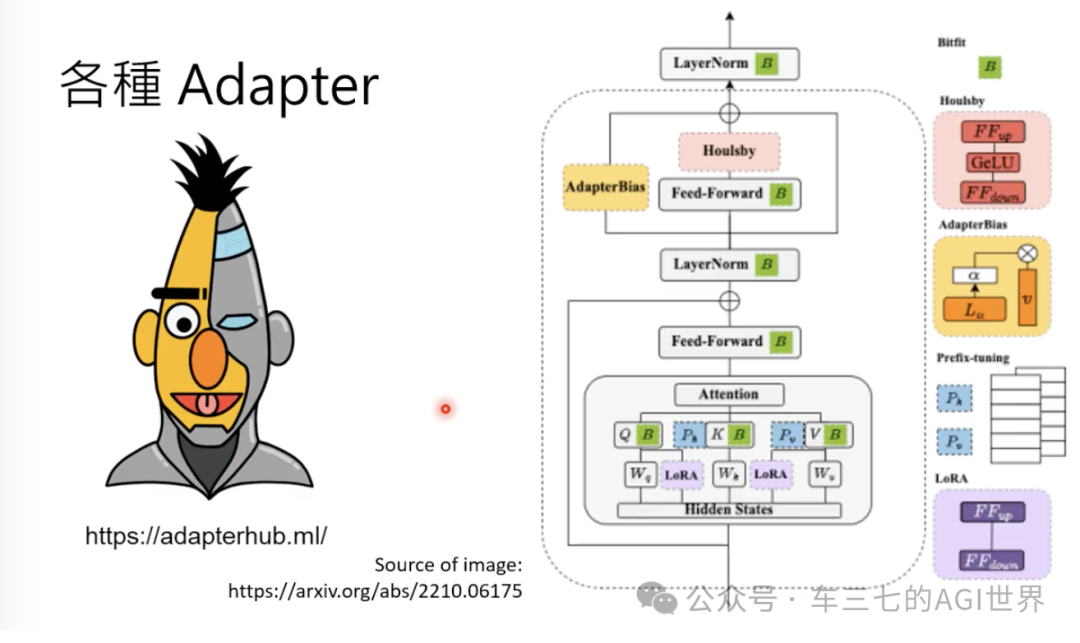

这两天看大模型微调的材料,发现这个概念是个筐,里面装的东西很多很多。比如之前认识到的[指令遵循数据集],其实它是一种指令微调,是众多微调方式中的一种。也就是说通过指令微调,GPT可以Chat了。所以,微调是微调的GPT,ChatGPT是微调GPT的结果,而不能理解为在ChatGPT基础上进行微调(虽然这种理解在某种层面或某些实际应用上也是对的)。大模型通过预训练掌握语言结构,学会了说人话,表现形式

大模型指的是参数规模超过亿级甚至千亿级的深度学习模型。特点:高容量:能够捕捉复杂模式和分布。通用性:支持多任务、多模态(如文本、图像、音频)学习。可扩展性:在预训练基础上,通过少量样本(Few-shot)或无监督微调(Zero-shot)完成特定任务。

一年多来,业界发布了非常多的大模型,从去年OpenAI GPT-3 1750亿参数开始到年初华为盘古大模型 1000亿,鹏程盘古- 2000亿参数,及谷歌最近发布的大模型是PaLM-E,拥有5620亿参数,号称史上最大规模视觉语言模型,快手1.9万亿参数推荐精排模型,阿里达摩院M6 10万亿参数等。很多小伙伴看得是眼花缭乱,那究竟这些模型有没有差异?如果有差异,差异在哪里?到底什么是大模型?到底大