简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

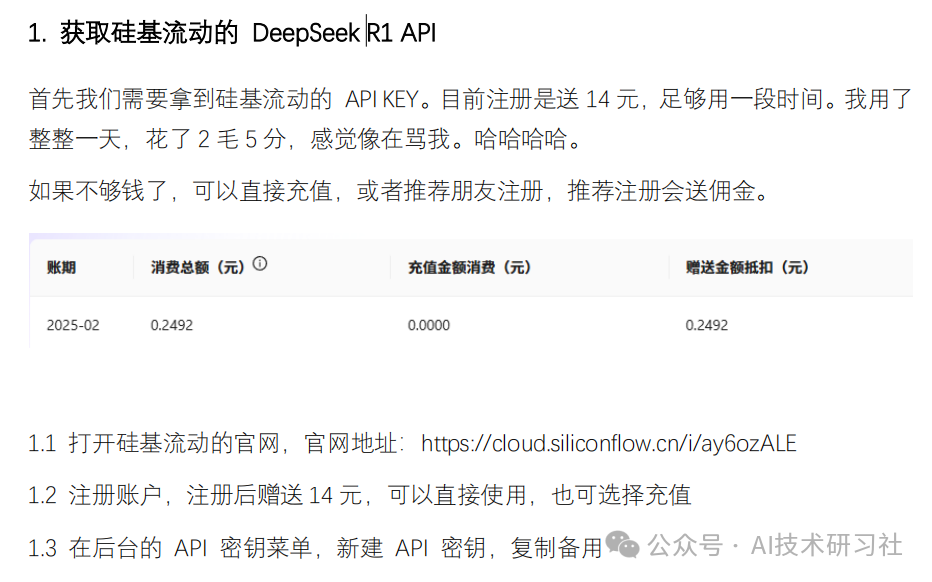

DeepSeek R1 发布后,风靡全球。在除了印度外的 100 多个国家下载量排名第一。用户访问量太大+各种外部原因,官网也光荣地倒下了。这两天经常处于瘫痪状态,是不是给你来个服务器繁忙,请稍后再试,太崩溃了,极其影响效率。

国产大模型Deepseek R1模型对标ChatGPT O1,可以直接本地运行的“GPT-4.0”,这篇文章,教你如何把Deepseek R1模型部署到本地。废话不多说,直接进入正题。

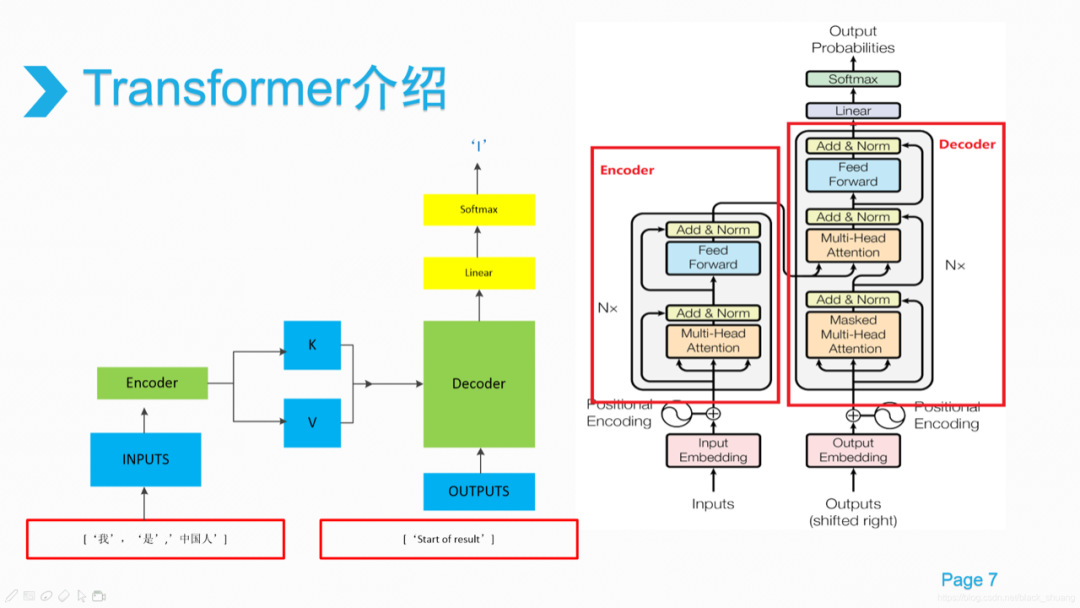

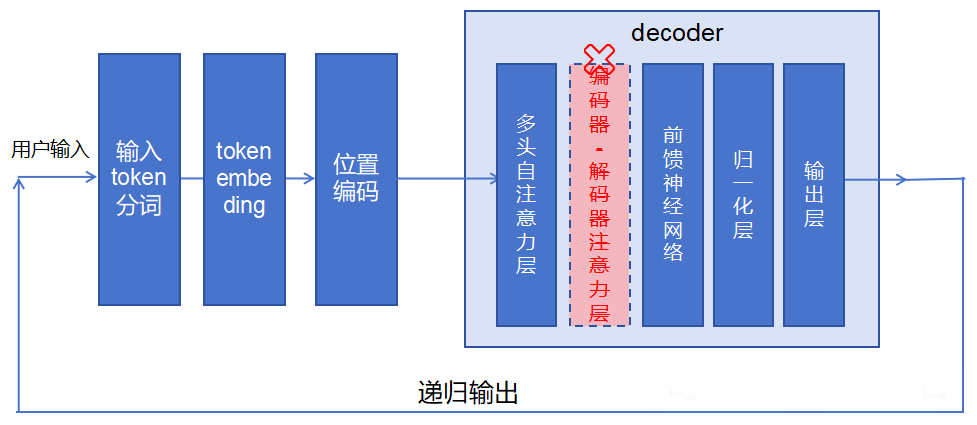

在大语言模型(LLM)的发展浪潮中,架构的选择对于模型的性能、效率和应用场景起着至关重要的作用。DeepSeek没有随波逐流采用当下流行的Decoder only架构,而是另辟蹊径选择了混合专家(MOE)架构,这背后有何考量呢?今天,就来拆解下。

近年来,大语言模型(LLM)的应用日益广泛,而高效的部署方案至关重要。Ollama和vLLM作为两种流行的LLM部署工具,各有优劣。本文将深入比较Ollama和vLLM的部署方式,帮助选择最合适的方案。

当我们谈论AI,谈论人工智能领域时,经常会提到“模型微调”。这个词儿听起来可能有些专业,但它的的确确是解锁AI强大潜力,让AI更加精准地服务于我们的需求,推动人工智能落地的关键。

在人工智能领域不断发展的进程中,检索增强生成(RAG)技术已成为提升大型语言模型(LLM)性能的关键力量。它通过整合外部知识源,有效弥补了 LLM 自身知识的局限性,在众多应用场景中展现出巨大潜力。今天我们一起聊一下如何选择合适的 RAG 技术,希望对大家有帮助。

昨天有读者问我:火爆全球的DeepSeek,到底有啥用?我估计,提出这个问题的朋友,应该还没试用过这个App。作为一个海淀爸爸,就说一件你们最关心的事吧!它能替你鸡娃,用好了真能省妈,就问你心动不?😎至于怎么个省法,后面会有详细的指南,大家慢慢往下看。如此一个现象级的产品,为啥还会有很多人没下载 and 没试用呢?

35岁,还想学习AI?你一定不是一个人。人工智能(AI)迅速崛起,已经成为现代社会和未来发展的重要推动力。不论是在工作中提升效率,还是在创业中找到新机会,掌握AI技能都可能带来巨大的优势。那么,35岁的你能否学懂、用好AI呢?答案是肯定的!本文将为你提供一条清晰的学习路径,帮助你从零开始进入AI的世界。35岁学AI完全没问题,甚至可能比年轻人更有优势。不要被年龄限制住,35岁学AI完全可行,只要你

在人工智能(AI)领域,想要获得一份理想的工作,面试无疑是至关重要的一环。近日,一份在Github上标星超过30K的面试笔记成为了AI领域的热门话题。这份被誉为“神仙面试笔记”的资料,包含了所有AI大模型和大厂的知识面试题,成为了求职者们的“秘密武器”。

从去年到今年,大模型、chatGPT等概念和技术越来越火,但是像笔者一样的技术小白一直对大模型是一种似懂非懂的状态。鉴于最近在做基于大模型和Agent的上层AI应用,如若不了解底层概念,始终还是会限制产品层的能力,因此,最近2周零散时间读完了这本由复旦团队出版的《大规模语言模型:从理论到实践》,基本涉及到了大模型入门所需的核心框架内容,适合扫盲看。