简介

该用户还未填写简介

擅长的技术栈

可提供的服务

暂无可提供的服务

设计模式是软件开发中反复出现问题的通用解决方案,能显著提升开发效率、系统健壮性和团队协作能力。本文系统回顾了GoF 23设计模式(创建型、结构型、行为型),并探讨了其在云原生、大模型时代的价值,包括正确性验证、与LLM协同的Prompt-Pattern映射以及ROI量化模型。文章强调设计模式的核心价值在于降低技术债务、加速协作、提升系统可扩展性与代码可理解性,并提供了审慎应用和成为模式大师的专业实

本文深入剖析了当前AI认知的两极分化现象,指出许多AI项目失败源于定位偏差。文章核心观点是,AI Agent作为将大模型智能具象化的软件实体,能自主感知、制定策略、执行任务并学习优化,实现从“Copilot”到“Autopilot”的范式转变。AI Agent为企业带来降本增效、创新服务与体验、赋能员工三大核心价值。文章系统阐述了从战略规划、技术架构到工程实践的AI Agent落地全流程,强调以业

本文强调在大模型微调项目中,营销和业务思维的重要性远超技术本身。作者指出,对于新手程序员,应避免简单复刻开源项目,而要注重数据收集与处理、科学评测和项目包装。通过独特的选题、高质量的数据集构建、系统性的评测方法以及展示业务敏感度,即使是“玩具级”项目也能在面试中脱颖而出,展现个人潜力。文章旨在帮助读者掌握如何将微调项目“营销”出去的方法论,提升竞争力。

文章详述了Java在大模型工程化,特别是RAG应用中的核心作用。通过分析Java的技术优势(生态成熟、性能稳定、兼容性强),文章拆解了RAG应用的四大核心模块(数据处理层、检索服务层、模型调用层、应用服务层)的实现方法,并结合企业级案例展示了Java如何支撑大模型后端服务的构建与优化,强调Java在大模型后端中占据不可替代的位置。

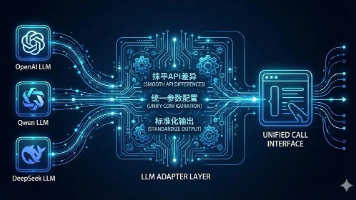

本文系统解析了AI Agent框架的设计原理与主流选型,详细介绍了"大脑-双手-记忆-中枢"四大核心技术支柱,对比分析了LangChain、LlamaIndex、Qwen-Agent和AutoGen四大框架的特点与适用场景,并通过多文件智能问答案例展示了实操过程,为开发者提供全面的AI Agent开发指南和框架选型参考。

《RAG实践手册》是开源指南,详细介绍如何使用Cloudflare技术栈构建智能问答系统。内容涵盖RAG原理、无服务器架构设计、技术栈选择、知识库构建与检索实现、答案生成与对话管理,以及运维最佳实践。手册提供完整的环境搭建步骤和代码示例,强调"分离关注点"设计理念和多语言支持,适合个人开发者低成本实现高性能RAG应用。

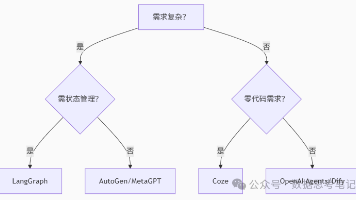

本文对LangGraph、AutoGen、Dify、Coze等主流AI Agent开发框架进行了全方位对比分析,从核心定位、技术特性、典型场景、成本模型和社区支持等多个维度评估各框架特点。文章针对复杂流程管理、多智能体协作、快速原型开发等不同需求场景提供了选型建议,并从技术深度、落地速度、生态依赖和长期成本等角度为企业或个人开发者提供了决策参考,帮助不同技术背景的人群选择适合的AI Agent开发

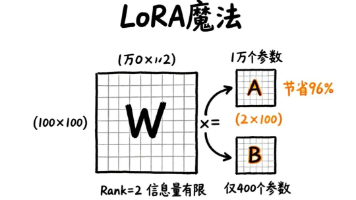

本文介绍LoRA技术如何通过矩阵分解将大模型微调成本降低96%。微调本质是学习参数改动量Δ,而LoRA用两个小矩阵近似表示大矩阵改动,只需原参数的2%-16%。该方法可大幅减少显存占用和训练时间,同时保持接近全量微调的效果,还支持"可插拔式技能包"实现多任务切换。LoRA让个人开发者也能负担得起大模型微调,是参数高效微调(PEFT)的代表技术。

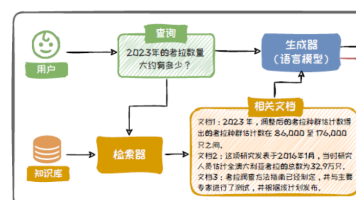

大语言模型存在"幻觉"问题,即生成看似合理但错误或过时的回答。RAG(检索增强生成)技术通过引入外部知识库,无需修改模型参数即可提高生成质量、避免灾难性遗忘。RAG系统由知识库、检索器和生成器组成,相比全量微调,RAG具有灵活性高、成本低、时效性强等优势,特别适合需要快速集成新知识的场景,已成为解决大模型幻觉问题的重要技术手段。

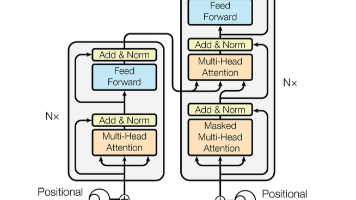

本文系统介绍了语言模型与智能体的核心技术,对比分析了大语言模型(LLM)和小语言模型(SLM)的特点与应用场景,详细阐述了智能体的核心组件、推理范式、RAG技术及多智能体系统架构。文章还探讨了开发框架、平台工具及未来应用趋势,为开发者提供了从理论到实践的全面指导,帮助构建高效、可靠的AI智能体系统。