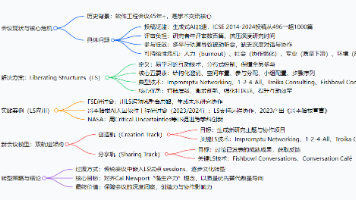

MiniCPM-V 4.5超强端侧多模态模型上线,性能速度兼具,端侧运行无压力;MedChatZH含超1K中医典籍,助力中医问诊

MedChatZH 数据来源于超过 1k 本中医典籍与医家笔记,以及从互联网与多家中国医院汇集的超过 700 万条中文医疗指令并结合 BELLE-3.5M 通用指令,经过筛选清理得到医药类指令 763,629 条、通用指令 1,305,194 条,共同组成用于对话微调的 med-mix-2M 数据集,与中医典籍语料配合,分别服务于继续预训练与指令微调两个阶段。MiniCPM-V 4.5 端侧部署友

公共资源速递

This Weekly Snapshots !

5 个公共数据集:

* MCD 多模态代码生成数据集

* WideSearch 信息搜集基准数据集

* MedChatZH 中文医疗对话指令数据集

* We-Math2.0-Standard 视觉数学推理基准数据集

* Nemotron-Pretraining-Dataset-sample 样本数据集

2 个公共教程:

* BioEmu:生成式深度学习系统

* MiniCPM-V 4.5:最强端侧多模态模型

访问网立即使用:http://openbayes.com

公共数据集

Multimodal Coding Dataset(MCD)数据集包含总计约 59.8 万条/对高质量样本,以指令跟随格式组织,覆盖多种输入模态(文本、图像、代码)与输出模态(代码、答案、解释),适用于多模态代码理解与生成任务。

* 在线使用:

https://go.openbayes.com/RbDbL

WideSearch 包含研究团队从真实用户查询中精心挑选并手工清洗出 200 个高质量问题(100 个英文问题、100 个中文问题),这些问题来自 15 个以上的不同领域。

* 在线使用:

https://go.openbayes.com/b5XUm

数据集构建与自动评测流程图

MedChatZH 数据来源于超过 1k 本中医典籍与医家笔记,以及从互联网与多家中国医院汇集的超过 700 万条中文医疗指令并结合 BELLE-3.5M 通用指令,经过筛选清理得到医药类指令 763,629 条、通用指令 1,305,194 条,共同组成用于对话微调的 med-mix-2M 数据集,与中医典籍语料配合,分别服务于继续预训练与指令微调两个阶段。

* 在线使用:

https://go.openbayes.com/1GB4L

4. We-Math2.0-Standard 视觉数学推理基准数据集

We-Math2.0-Standard 数据集围绕 1,819 条精定义的知识原理(Knowledge Principles)建立统一标签空间,对每道题进行显式原理标注与严格策展,从而在整体上实现广泛且均衡的覆盖,特别补强以往代表性不足的数学子领域与题型。

* 在线使用:

https://go.openbayes.com/8JOHO

数据集概览

5. Nemotron-Pretraining-Dataset-sample 样本数据集

Nemotron-Pretraining-Dataset-sample 数据集包含从完整的 SFT 与预训练语料的不同组成部分中选取的 10 个代表性子集,内容涵盖高质量问答数据、专注于数学领域的提取内容、代码元数据及 SFT 风格指令数据,适用于检阅和快速实验。

* 在线使用:

https://go.openbayes.com/hKn4M

公共教程

BioEmu 可以高效模拟蛋白质的动态结构和平衡态构象,能在单个 GPU 上每小时生成数千种蛋白质结构样本,效率远超传统的分子动力学(MD)模拟。通过结合大量蛋白质结构数据、超过 200 毫秒的 MD 模拟数据以及实验蛋白质稳定性数据,BioEmu 能以约 1 kcal/mol 的相对自由能误差准确预测蛋白质的平衡态构象。

* 在线运行:

https://go.openbayes.com/IC6zR

MiniCPM-V 4.5 拥有 8B 参数。模型在图片、视频、OCR 等多个领域表现卓越,尤其在高刷视频理解方面取得突破,能处理高刷新率视频并精准识别内容。模型支持混合推理模式,可平衡性能与响应速度。MiniCPM-V 4.5 端侧部署友好,显存占用低,推理速度快,适合在车机、机器人等设备上应用,为端侧 AI 发展树立新标杆。

* 在线运行:

https://go.openbayes.com/XDzRq

新用户福利

* 注册福利:点击下方邀请链接注册,即可获得 4 小时 RTX 4090 + 5 小时 CPU 的免费算力时长,永久有效!

小贝总专属邀请链接(直接复制到浏览器打开):

更多推荐

已为社区贡献1条内容

已为社区贡献1条内容

所有评论(0)